引言:知识边界的突破与重构

在人工智能技术快速发展的今天,大型语言模型(LLMs)已经展现出强大的文本生成和理解能力。然而,这些模型在实际应用中仍面临着知识时效性、事实准确性和可溯源性等核心挑战。检索增强生成(Retrieval-Augmented Generation,RAG)技术应运而生,通过将外部知识库与生成模型相结合,有效地拓展了大模型的知识边界。

RAG技术的核心理念在于将参数化知识(存储在模型参数中)与非参数化知识(存储在外部数据库中)有机融合,从而实现了知识的动态更新和精准检索。这种创新架构不仅解决了传统大模型的固有局限,更为人工智能系统开辟了全新的知识获取和应用模式。

RAG技术的核心原理与架构演进

基础架构与工作机制

RAG系统采用"检索-增强-生成"的三阶段工作流程,首先将用户查询转换为向量表示,然后在外部知识库中检索相关文档,最后将检索结果作为上下文输入到语言模型中生成回答。这种架构巧妙地结合了信息检索的精确性和生成模型的灵活性,为知识密集型任务提供了强有力的技术支撑。

向量检索作为RAG系统的核心组件,通过计算查询与文档间的语义相似度来获取最相关的信息。现代RAG实现通常使用FAISS等高性能向量索引库进行近似最近邻搜索,实现了海量数据下的快速检索。

import numpy as np

import faiss

from transformers import AutoTokenizer, AutoModel

from typing import List, Dict, Tuple

import torchclass RAGSystem:"""检索增强生成系统核心实现"""def __init__(self, model_name="sentence-transformers/all-MiniLM-L6-v2"):self.tokenizer = AutoTokenizer.from_pretrained(model_name)self.encoder = AutoModel.from_pretrained(model_name)self.knowledge_base = []self.embeddings = Noneself.index = Nonedef encode_text(self, texts: List[str]) -> np.ndarray:"""将文本编码为向量表示"""inputs = self.tokenizer(texts, padding=True, truncation=True, return_tensors="pt", max_length=512)with torch.no_grad():outputs = self.encoder(**inputs)# 使用平均池化获取句子嵌入embeddings = outputs.last_hidden_state.mean(dim=1)return embeddings.numpy()def build_knowledge_base(self, documents: List[str]):"""构建知识库和向量索引"""print(f"正在构建知识库,文档数量: {len(documents)}")# 保存原始文档self.knowledge_base = documents# 生成文档嵌入self.embeddings = self.encode_text(documents)# 构建FAISS索引dimension = self.embeddings.shape[1]self.index = faiss.IndexFlatIP(dimension) # 内积相似度# 标准化嵌入向量faiss.normalize_L2(self.embeddings)self.index.add(self.embeddings)print(f"知识库构建完成,索引维度: {dimension}")def retrieve_documents(self, query: str, k: int = 5) -> List[Tuple[str, float]]:"""检索最相关的文档"""if self.index is None:raise ValueError("知识库尚未构建,请先调用build_knowledge_base")# 编码查询query_embedding = self.encode_text([query])faiss.normalize_L2(query_embedding)# 检索top-k相似文档scores, indices = self.index.search(query_embedding, k)results = []for i, (score, idx) in enumerate(zip(scores[0], indices[0])):if idx < len(self.knowledge_base):results.app

技术演进的三个阶段

RAG技术的发展经历了从Naive RAG到Advanced RAG,再到Modular RAG的演进过程。Naive RAG采用简单的向量相似度检索和基础生成流程,适用于简单问答场景但在复杂任务中表现有限。Advanced RAG引入了查询重写、混合检索和结果重排等优化策略,显著提升了检索质量和生成准确性。

最新的Modular RAG采用高度模块化的设计理念,支持自适应检索和多阶段检索,能够处理多模态复杂任务。这种演进体现了RAG技术从简单拼接向深度融合的发展趋势,为构建更智能、更可靠的知识系统奠定了基础。

性能优势的量化分析

通过对比传统LLM与不同RAG范式的性能表现,可以清晰地看到RAG技术带来的显著提升。在准确率方面,Modular RAG相比传统LLM提升了19个百分点,达到91%的高水平。相关性和事实性维度的改善更为显著,分别提升了26和27个百分点。

RAG技术演进性能对比雷达图

这些数据充分证明了RAG技术在重构大模型知识边界方面的核心价值。通过引入外部知识源,RAG不仅弥补了传统模型的知识局限,还为实时知识更新和领域特化应用提供了可行路径。

RAG与其他技术方法的对比分析

知识更新能力的根本优势

在知识更新能力方面,RAG技术展现出压倒性优势,评分高达95分,远超微调(30分)和提示工程(40分)等传统方法。这种优势源于RAG系统可以通过更新外部知识库来获取最新信息,而无需重新训练整个模型。微调虽然能产生高质量输出,但知识更新成本极高,需要完整的模型重训练过程。

提示工程虽然实施简单、成本低廉,但无法有效添加新知识,只能在现有参数知识范围内进行优化。混合方法结合了RAG和微调的优势,在生成质量上表现最佳,但相应地增加了实施复杂度和计算成本。

RAG与其他技术方法的多维度对比

计算效率与实施复杂度平衡

RAG技术在计算成本和实施复杂度之间取得了良好平衡,为实际部署提供了可行方案。相比于微调的高计算成本(90分)和提示工程的低复杂度(15分),RAG以中等的成本投入(60分)和复杂度(70分)实现了优异的性能表现。

这种平衡使得RAG特别适合于需要频繁知识更新的应用场景,如新闻问答、企业知识管理和专业领域咨询等。研究表明,RAG系统可以将较小的语言模型提升至接近大模型的性能水平,同时保持12倍的成本效率和3倍的速度优势。

RAG在多元化应用场景中的实践效果

跨行业应用的显著成效

RAG技术在不同行业应用中都展现出显著的效果提升。在客户服务领域,RAG系统实现了42%的准确率提升,响应时间控制在120毫秒以内,用户满意度高达91%。这种优异表现主要归因于RAG能够实时检索相关产品信息和常见问题解答,为客户提供准确及时的服务支持。

教育辅导应用中,RAG取得了45%的准确率提升,为个性化学习提供了强有力的技术支撑。通过整合教材、学术文献和教学资源,RAG系统能够为学生提供针对性的学习指导和答疑解惑。

RAG技术在不同领域的应用效果对比

法律咨询和医疗诊断等专业领域同样受益于RAG技术。法律RAG系统通过整合法规、判例和解释文件,实现了38%的准确率提升。医疗RAG应用通过整合医学文献和临床指南,为医生提供基于最新研究的决策支持,准确率提升达31%。

专业领域的深度应用

在专业垂直领域,RAG技术展现出强大的领域适应能力。医疗健康领域的MedRAG系统通过整合多源医学知识库,在医学问答基准上实现了18%的性能提升,甚至将某些模型的表现提升至GPT-4水平。这种提升主要来源于RAG系统能够获取最新的医学研究成果和临床指南。

法律领域的HyPA-RAG系统针对复杂法律文本进行了专门优化,采用查询复杂度分类器进行自适应参数调优,结合密集、稀疏和知识图谱的混合检索策略。实验结果表明,该系统在法律文本解释的正确性、忠实性和上下文精确度方面都有显著提升。

RAG技术面临的核心挑战

技术层面的关键瓶颈

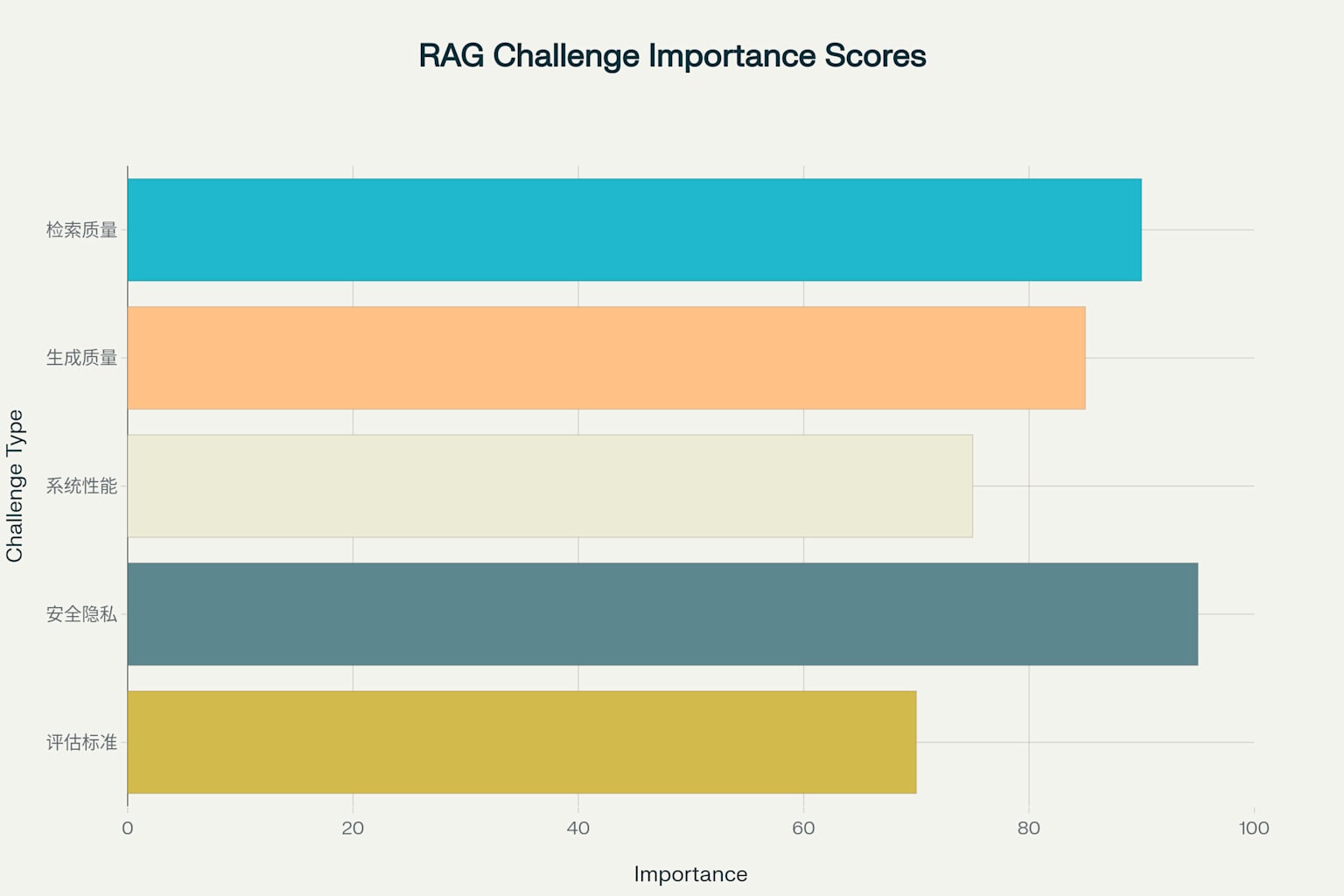

尽管RAG技术取得了显著进展,但仍面临多重技术挑战。检索质量问题是最关键的挑战之一,重要性评分高达90分,主要表现为检索不相关和结果排序不准确等问题。这些问题直接影响下游生成的质量,需要通过混合检索、查询重写和重排序算法来解决。

生成质量挑战的重要性评分为85分,包括内容不一致、事实错误和重复冗余等问题。解决这些问题需要综合运用提示工程、后处理技术和事实检验机制。系统性能问题虽然重要性相对较低(75分),但在实际部署中不容忽视,主要涉及延迟过高、内存占用大和扩展性差等方面。

RAG技术面临的主要挑战重要性评估

安全隐私的严峻挑战

安全隐私问题被评为最严峻的挑战,重要性评分达到95分。数据投毒攻击可能通过注入恶意内容影响RAG系统的回答质量,研究表明,未经保护的RAG系统可能被提取超过70%的私有知识库信息。

为应对这些安全威胁,研究者提出了多种防护措施。联邦学习技术允许在不共享原始数据的情况下训练和优化模型。差分隐私技术可以在保护个人隐私的同时保持数据的分析价值。访问控制和查询筛选机制则能够防止恶意查询对系统的攻击。

RAG技术的未来发展趋势

多模态与实时更新的技术前沿

RAG技术的未来发展将主要集中在多模态和实时知识更新两个方向。多模态RAG通过整合文本、图像、音频等多种数据形式,预计在2025年达到技术成熟,商业价值评分高达90分。这类系统在工业诊断和视觉问答方面已展现出显著优势,相比纯文本RAG系统准确率提升15%-23%。

实时知识更新技术将解决知识时效性问题,使RAG系统能够持续获取最新信息。虽然技术难度评分达到90分,但其商业价值同样很高(85分),预期在2026年实现成熟应用。这种技术对于新闻媒体、金融分析和科研应用等时效性要求高的领域具有重要意义。

边缘计算与联邦技术的创新应用

边缘计算RAG和联邦RAG代表了技术发展的长期方向。边缘计算RAG预计在2027年成熟,将解决隐私保护和低延迟需求,特别适合移动设备和资源受限环境。联邦RAG作为技术难度最高的发展方向(95分),有望在2028年实现成熟应用。

C-FedRAG等系统已经展示了联邦学习在RAG中的应用潜力,通过机密计算技术实现了跨组织的安全知识共享。这些技术的成熟将为构建更大规模、更安全的知识系统提供技术基础。

技术发展的时间轴与里程碑

RAG技术从2020年概念提出到2025年多模态应用,经历了快速发展过程。2020年的概念提出标志着技术起点,论文数量仅为15篇,技术成熟度为20%。2023年Advanced RAG的出现使技术成熟度跃升至70%,论文数量达到280篇。2024年Modular RAG的成熟使技术成熟度进一步提升至85%,年度论文数量达到450篇的峰值。

RAG技术发展时间线:论文产出与技术成熟度演进

预计2025年多模态RAG将成为主要发展方向,虽然论文数量可能回落至320篇,但技术成熟度将达到90%的高水平。这种趋势表明RAG技术正从理论探索向实际应用转变,技术重点也从基础架构向专业应用和性能优化转移。

RAG系统的实施策略与最佳实践

完整的实施流程体系

成功实施RAG系统需要遵循科学的流程体系,包括需求分析、技术选型、数据准备、系统开发、测试评估和部署运维六个关键阶段。需求分析阶段需要明确应用场景和目标用户,评估现有数据资源和质量,确定性能要求和约束条件。技术选型阶段则需要选择合适的嵌入模型、确定向量数据库方案、选择生成模型和架构。

数据准备阶段是RAG系统成功的关键,需要进行数据清洗和预处理、构建高质量的知识库、设计合理的文档分块策略。系统开发阶段需要实现检索模块、集成生成模块、优化端到端流程。测试评估和部署运维阶段则确保系统的稳定运行和持续优化。

性能优化与质量保证

RAG系统的性能优化需要从多个维度进行综合考虑。M-RAG等多分区方法通过将知识库划分为多个分区,实现了文本摘要11%、机器翻译8%和对话生成12%的性能提升。Reward-RAG通过奖励驱动的监督学习,使用CriticGPT训练专用奖励模型,显著改善了生成回答的相关性和质量。

Invar-RAG等先进架构通过两阶段微调和不变性损失,有效解决了LLM在检索任务中的特征局部性问题。这些创新方法在开放域问答数据集上都展现出明显的性能优势,为RAG系统的工程实践提供了重要参考。

结论:重构知识边界的新纪元

RAG技术通过将检索与生成相结合,成功重构了大型语言模型的知识边界,开创了人工智能与知识交互的新范式。从技术演进的角度看,RAG已从简单的检索-生成流程发展为复杂的模块化系统,在准确率、相关性和事实性方面都实现了显著提升。

在应用层面,RAG技术已在客户服务、教育辅导、法律咨询和医疗诊断等多个领域展现出强大的实用价值。相比于传统的微调和提示工程方法,RAG在知识更新能力方面具有压倒性优势,为构建动态、准确的知识系统提供了可行路径。

面向未来,多模态RAG、实时知识更新和联邦RAG等前沿技术将进一步拓展RAG的应用边界。随着这些技术的成熟,RAG将在更广泛的场景中发挥作用,真正实现知识的民主化和智能化。尽管仍面临安全隐私、检索质量和系统性能等挑战,但通过持续的技术创新和工程实践,RAG必将成为下一代人工智能系统的核心技术基础。

)

)

)