目录

前言

一、Embedding 模型基础:文本到向量的“魔术师”

1.1 什么是 Embedding?

1.2 为什么需要 Embedding?

二、核心作用与优势:语义分析的“利刃”

三、工作原理拆解:从训练到应用的完整链条

3.1 训练阶段:学习语义关系

3.2 推理阶段:生成向量

3.3 应用阶段:相似度计算与决策

四、实际应用场景:以智能客服为例,Embedding 如何“把关”

五、衡量相似度的方法

六、Embedding 在不同场景的应用模式

6.1 语义搜索

6.2 语义分类 / 意图识别

6.3 语义匹配

6.4 推荐系统

6.5 聚类与主题发现

七、如何评估 Embedding 的效果

八、调优与实践建议

未来展望:Embedding 的无限可能

前言

在人工智能领域,Embedding 模型已成为连接人类语言与机器理解的桥梁。它不仅仅是“词向量分析”的工具,更是现代 AI 系统(如搜索引擎、推荐系统和聊天机器人)背后的核心引擎。今天,我们来全面剖析 Embedding 模型的作用、原理和工作机制。作为一名 AI 从业者,我将用通俗易懂的语言,结合实际场景,帮助你彻底搞懂这个概念。

文章结构如下,便于你逐层深入:

- Embedding 模型基础:什么是 Embedding?它如何将文本转化为向量?

- 核心作用与优势:Embedding 在语义分析中的关键功能。

- 工作原理拆解:从训练到应用的全流程。

- 实际应用场景:以智能客服为例,展示 Embedding 如何优化系统。

- 衡量相似度方法:常用余弦相似度、点积、欧氏距离等方式量化向量间的语义接近度。

- Embedding在不同场景的应用模式:语义搜索、分类、匹配、推荐、聚类等多领域落地。

- 如何评估Embedding的效果:通过相似度任务、分类准确率、检索指标和可视化分析验证质量。

- 调优和实践建议:合理选型、归一化、批量计算、缓存与索引优化提升性能与效果。

- 未来展望:Embedding 的发展趋势。

通过这篇文章,你将明白 Embedding 为什么是 AI 的“语义翻译家”,并学会如何在项目中应用它。

一、Embedding 模型基础:文本到向量的“魔术师”

1.1 什么是 Embedding?

Embedding 是将文本等信息转化为向量并通过相似度计算实现语义理解与应用的核心技术。

Embedding 模型是一种将离散数据(如单词、句子或图像)映射到连续向量空间的 AI 技术。在自然语言处理(NLP)中,它最常见的形式是 文本 Embedding,即将文字转化为高维向量(例如,一个 768 维的数字数组)。这些向量捕捉了文本的语义、语法和上下文信息。

简单比喻:想象语言是一张地图,单词是城市。Embedding 就像 GPS 坐标系统——相似的“城市”(如 “猫” 和 “狗”)坐标接近,不相关的(如 “猫” 和 “汽车”)则相距甚远。

1.2 为什么需要 Embedding?

因为计算机不能直接理解语言、图片的含义,但向量可以:

方便用距离/相似度来衡量内容是否相近

支持模糊匹配(不同表达、同一意思)

高效检索(向量数据库支持毫秒级相似度查询)

是很多 AI 应用的基础特征表示

传统计算机处理文本时,只能看到字符串(如 “apple”),无法理解含义。Embedding 解决了这个问题:

- 语义捕捉:它让机器“懂” 同义词(“happy” 和 “joyful” 向量相似)和多义词(“bank” 在不同上下文中向量不同)。

- 维度降维:从海量词汇库中提取本质特征,便于计算。

常见模型包括:

- Word2Vec:早期词向量模型,基于上下文预测。

- BERT / Sentence-BERT:句子级 Embedding,考虑全局上下文。

- OpenAI 的 text-embedding-ada-002:高效、通用,支持多语言。

二、核心作用与优势:语义分析的“利刃”

Embedding 的核心作用在于 向量表示与相似度计算,它在 AI 系统中的优势体现在多个层面:

1.语义相似度度量:

通过计算向量间的距离(如余弦相似度:cos(θ) = (A · B) / (|A| |B|)),Embedding 可以判断两个文本的相似程度。

优势:超越关键词匹配,能处理变体表达(如 “天气热” 和 “今天好晒” 相似度高)。

2.高效过滤与分类:

在大数据场景中,Embedding 作为“前置筛子”,快速排除无关内容,节省计算资源。

优势:生成向量只需毫秒,远低于完整模型推理。

3.多模态扩展:

现代 Embedding 支持文本、图像甚至音频的统一向量空间(如 CLIP 模型),便于跨模态搜索。

优势:实现“图文匹配”或“语音转义义”。

4.下游任务支持:

Embedding 是许多 AI 应用的“输入层”,如聚类、推荐和检索增强生成(RAG)。

优势:可微分,便于与神经网络集成。

用数据说话:根据 Hugging Face 的基准测试,Embedding 模型在语义相似度任务上的准确率可达 90% 以上,远超传统方法。

三、工作原理拆解:从训练到应用的完整链条

以文本 embedding 为例,大致过程是:

分词/编码:将句子切分成 token(字、词、子词)

向量化表示:用词向量(word embeddings)或上下文向量(contextual embeddings)

模型处理:通常是 Transformer(如 BERT、RoBERTa、SimCSE)

池化(Pooling):把每个 token 的向量合并成一个固定长度的句向量(CLS token、平均池化等)

归一化:可选,将向量模长归一化,便于余弦相似度计算

可视化示意(二维化后):

要讲透 Embedding,我们从头拆解其原理。过程分为三个阶段:

3.1 训练阶段:学习语义关系

- 数据输入:海量文本语料(如维基百科、书籍)。

- 模型架构:使用 Transformer(如 BERT)或 Skip-Gram(Word2Vec)。模型通过自监督学习预测缺失词或上下文。

- 输出:一个嵌入矩阵,每个词/句子对应一个固定维度向量。

示例:训练中,“The cat sits on the mat” → 模型学习 “cat” 和 “mat” 的关联,向量中编码位置、语法等。- 关键技术:负采样(加速训练)和注意力机制(捕捉长距依赖)。

3.2 推理阶段:生成向量

- 输入文本 → Tokenization(分词) → 通过模型前向传播 → 输出向量。

- 示例代码(Python + Hugging Face):

from sentence_transformers import SentenceTransformer model = SentenceTransformer('all-MiniLM-L6-v2') sentence = "Embedding models are powerful." embedding = model.encode(sentence)输出: [0.12, -0.34, ..., 0.56] (384 维)

- 耗时:单句通常 < 10ms。

3.3 应用阶段:相似度计算与决策

- 比较两个向量:使用欧氏距离或余弦相似度。

- 阈值判断:相似度 > 0.7 视为相关。

- 扩展:KNN 搜索(最近邻)用于大规模检索。

这个链条确保 Embedding 不仅准确,还高效、可扩展。

四、实际应用场景:以智能客服为例,Embedding 如何“把关”

虽然智能客服只是一个场景,但它完美展示了 Embedding 的实战价值。假设客户拨打热线(如 10086),常聊无关话题(如天气),导致系统占线。传统客服“有问必答”,但 Embedding 可在调用主模型(如 LLM)前进行语义识别,过滤无关查询。

Embedding 在此的作用:

- 语义识别前置:将客户查询转为向量,与预定义业务主题向量(e.g., “套餐咨询”的向量)比较。

- 无关(如 “聊聊人生”):相似度低 → 直接回复“不在服务范围”,不调用模型。

- 相关(如 “信号差”):相似度高 → 转入深度处理。

- 具体优势:

- 资源优化:减少 30%-50% 无谓调用,降低成本。

- 实时性:向量计算快,响应延迟最小化。

- 准确提升:处理模糊表达,避免误答。

流程:

- 语音转文本 → 查询向量生成。

- 计算与业务向量的相似度。

- 决策:相关 → 调用 LLM;无关 → 标准拒绝。

这个场景突显 Embedding 的“过滤器”作用,但它在搜索(如 Google 的语义搜索)、推荐(如 Netflix 的内容匹配)中同样闪耀。

五、衡量相似度的方法

-

余弦相似度(cosine similarity):衡量方向一致性(常配归一化)

-

点积(dot product):衡量向量投影大小

-

欧氏距离(L2):几何距离

公式示例:

cos_sim(u,v) = (u · v) / (||u|| * ||v||)

六、Embedding 在不同场景的应用模式

这里给出几个典型模式(智能客服只是其中之一):

6.1 语义搜索

用户输入问题 → embedding

文档向量库检索相似度最高的内容

应用:知识库搜索、法律文书检索、代码搜索

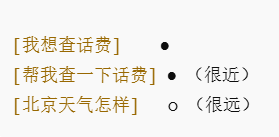

6.2 语义分类 / 意图识别

将输入 embedding 后,与各类别中心向量对比

应用:客服意图分类、工单路由、垃圾邮件识别

6.3 语义匹配

比较两段文本 embedding,判断是否语义相似

应用:FAQ 匹配、重复问题检测、相似商品推荐

6.4 推荐系统

用户行为 embedding + 物品内容 embedding

计算相似度推荐最相关的物品

6.5 聚类与主题发现

embedding 后做 K-means / HDBSCAN

应用:自动话题聚类、热点分析

七、如何评估 Embedding 的效果

-

语义相似度任务:STS(Semantic Textual Similarity)数据集,计算 Spearman / Pearson 相关系数

-

分类准确率:在分类任务上用 embedding 作为特征

-

检索指标:Recall@K、nDCG、MRR

-

可视化:用 t-SNE/U-MAP 将高维向量降维,看聚类效果

八、调优与实践建议

-

模型选择

小模型:快(适合在线实时)

大模型:准(适合离线检索、分析)

-

归一化:方便余弦相似度计算

-

批量计算:提高吞吐量

-

缓存:热门查询 embedding 缓存

-

向量库优化:HNSW 索引参数调优

-

阈值调节:结合 ROC 曲线选择合适阈值

未来展望:Embedding 的无限可能

随着 AI 进步,Embedding 将更智能:多模态统一(文本+图像+视频)、实时学习(在线更新)和量子加速(更快计算)。想象未来,Embedding 可驱动元宇宙的语义交互,或医疗的精准诊断。

地图控件和矢量图形绘制)

原理详解与实例)

)