一.前言

前面我们介绍了RNN相关系列的模型,在当今大模型时代大家认识一下就好了,而本章节我们是要来介绍一下重中之重的Transformer模型,本章节就来介绍一下他的架构,了解Transformer模型的作⽤以及了解Transformer总体架构图中各个组成部分的名称。

二.Transformer模型的作用

基于seq2seq架构的transformer模型可以完成NLP领域研究的典型任务, 如机器翻译, ⽂本⽣成等. 同时⼜可以构建预训练语⾔模型,⽤于不同任务的迁移学习.

在接下来的架构分析中, 我们将假设使⽤Transformer模型架构处理从⼀种语⾔⽂本到另⼀种语⾔⽂本 的翻译⼯作, 因此很多命名⽅式遵循NLP中的规则. ⽐如: Embeddding层将称作⽂本嵌⼊层, Embedding层产⽣的张量称为词嵌⼊张量, 它的最后⼀维将称作词向量等

三.Transformer总体架构图

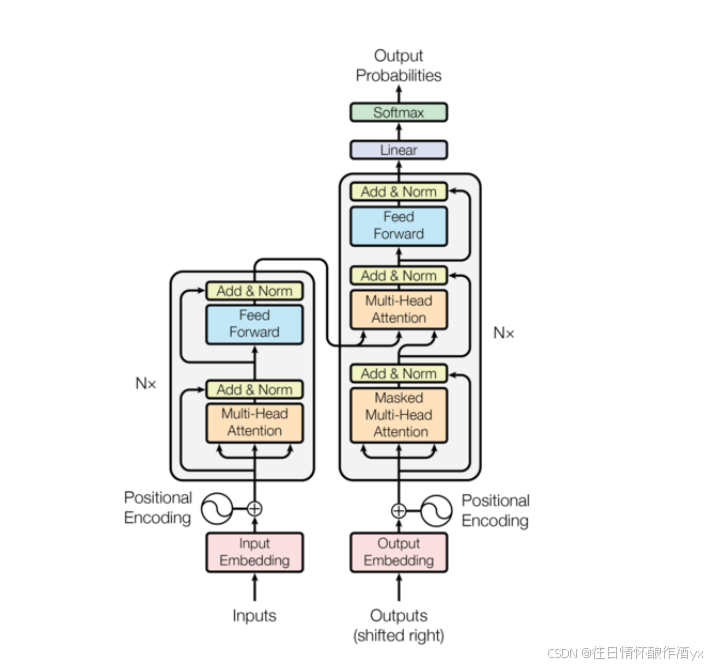

3.1 Transformer总体架构

输⼊部分

输出部分

编码器部分

解码器部分

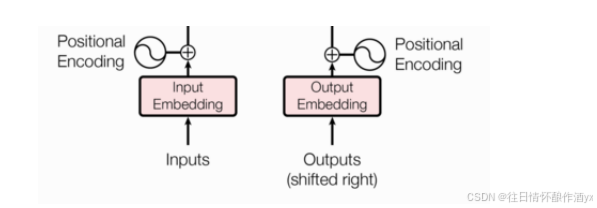

3.2 输⼊部分包含

源⽂本嵌⼊层及其位置编码器

⽬标⽂本嵌⼊层及其位置编码器

3.3 输出部分包含

线性层

softmax层

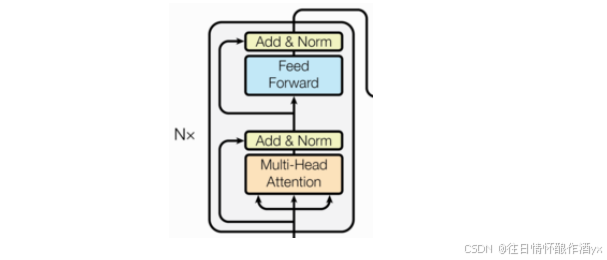

3.4 编码器部分

由N个编码器层堆叠⽽成

每个编码器层由两个⼦层连接结构组成

第⼀个⼦层连接结构包括⼀个多头⾃注意⼒⼦层和规范化层以及⼀个残差连接

第⼆个⼦层连接结构包括⼀个前馈全连接⼦层和规范化层以及⼀个残差连接

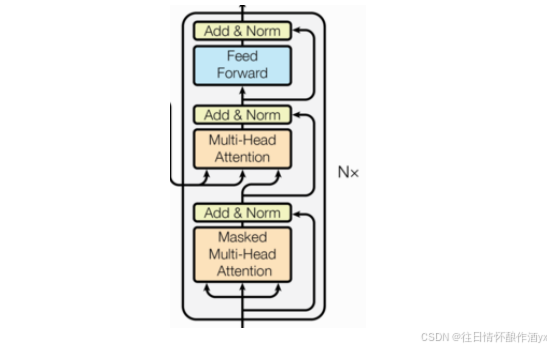

3.5 解码器部分

由N个解码器层堆叠⽽成

每个解码器层由三个⼦层连接结构组成

第⼀个⼦层连接结构包括⼀个多头⾃注意⼒⼦层和规范化层以及⼀个残差连接

第⼆个⼦层连接结构包括⼀个多头注意⼒⼦层和规范化层以及⼀个残差连接

第三个⼦层连接结构包括⼀个前馈全连接⼦层和规范化层以及⼀个残差连接

四.总结

本章节主要是介绍了一下Transformer的架构,后续还会继续更新相关知识,期待大家的点赞关注加收藏

![[3-02-02].第04节:开发应用 - RequestMapping注解的属性2](http://pic.xiahunao.cn/[3-02-02].第04节:开发应用 - RequestMapping注解的属性2)

)

- 数据结构】绪论)