模型介绍

OpenAI再次推出开源模型,发布了两款突破性的GPT-oss系列大模型,即GPT-oss-120b和GPT-oss-20b,为AI领域带来了巨大的创新和发展潜力。这两款模型不仅在性能上与现有的闭源模型媲美,而且在硬件适配性上具有明显优势,为开发者和企业提供了新的应用场景和商业机会。

一、两款模型的参数与性能特点

OpenAI这次开源的两款大模型各有特色,针对不同硬件配置和应用需求提供了解决方案。

| 模型 | 参数量 | 架构 | 激活参数量 | 性能特点 | 硬件要求 |

|---|---|---|---|---|---|

| GPT-oss-120b | 1170亿 | MoE(专家混合)架构 | 51亿 | - 在Codeforces竞赛编程和MMLU通用知识测试中超越o3-mini | - 单张80GB H100 GPU上运行,甚至高端游戏本可基本运行 |

- 在医疗健康(HealthBench)和竞赛数学(AIME 2025)领域表现优于闭源的o4-mini | |||||

| GPT-oss-20b | 210亿 | 常规架构 | 36亿 | - 在M3 Pro芯片的MacBook Pro上,以23.72 token/秒生成贪吃蛇游戏代码,性能接近o3-mini | - 仅需16GB内存设备即可驱动,适用于MacBook Pro、新款安卓手机等低配置设备 |

通过采用MoE架构,OpenAI成功实现了“参数规模”与“运行效率”的平衡,拓展了大模型的应用场景。

二、Apache 2.0 许可:商用与修改的宽松条件

与模型性能同样值得关注的是开源许可条款。此次发布的两款模型均采用Apache 2.0许可证,这意味着企业可以自由商用、修改代码并进行二次分发,无需公开修改后的源代码。相比Meta的Llama 3(限制非商业使用),Apache 2.0许可为企业商用提供了更为宽松的条件。不过需要注意的是,模型的训练数据并未公开,尽管如此,开发者仍可基于现有模型进行微调与部署。

三、生态支持:多方合作助力推广

为进一步推广开源模型,OpenAI已与多个技术合作伙伴达成合作,推动模型应用的广泛部署。

合作伙伴:Azure、AWS、Hugging Face、Ollama、NVIDIA等20多家企业。

- 模型下载与部署:开发者可以通过Hugging Face

下载模型权重,并在Ollama进行本地部署;微软还推出了Windows GPU优化版,支持AMD和苹果M系列芯片的原生运行。

离线能力:即使在断网环境下,模型仍能调用本地工具(如Python解释器)进行任务生成、数据运算等操作。

四、存在的争议:幻觉率与安全风险

尽管GPT-oss系列模型在硬件适配和性能上表现出色,但仍存在一些问题需要改进。

- 幻觉率问题:在PersonQA

测试中,120b模型的错误信息比例高达49%,是o1模型的三倍,这对医疗、法律等要求高精度的场景来说是一个潜在的挑战。

- 安全风险:由于Apache 2.0

的商用权限较宽松,可能会被滥用于生成垃圾信息或恶意代码。OpenAI表示已经进行过多轮安全测试,但仍无法完全避免滥用情况的发生。

尽管如此,这一开源举措无疑为AI行业注入了新的活力,打破了部分AI技术的垄断格局,促进了技术的快速发展。

结语:为开发者与企业提供更多选择

对于开发者而言,GPT-oss-20b模型可以帮助打造本地AI助手,提升工作效率;对于企业,GPT-oss-120b模型则为构建专属大模型提供了可行的解决方案。这两款模型为不同需求的用户提供了新的选择和机遇,推动AI领域向更广泛的应用场景发展。

详细信息与技术资源请访问:

GitHub 地址:https://github.com/openai/gpt-oss

hugging face 地址:https://huggingface.co/openai/gpt-oss-20b

hugging face 地址:https://huggingface.co/openai/gpt-oss-120b

modelscope地址:https://modelscope.cn/models/openai-mirror/gpt-oss-20b/summary

modelscope地址:https://modelscope.cn/models/openai-mirror/gpt-oss-120b/summary

ollama 可视化下载模型方法

Ollama 与 OpenAI 合作,将其最新的先进开放权重模型引入 Ollama。20B和120B这两个模型带来了全新的本地聊天体验,专为强大的推理能力、代理任务和多样化的开发者用例而设计。

功能亮点

- Agentic 功能:

使用模型的原生功能进行函数调用、网页浏览(Ollama 提供内置网页搜索,可以选择启用该功能以使用最新信息扩充模型)、python 工具调用和结构化输出。

- 完整的思路:

完全访问模型的推理过程,从而更轻松地进行调试并增强对输出的信任。

- 可配置的推理力度:

根据您的具体用例和延迟需求轻松调整推理力度(低、中、高)。

- 可微调:

通过参数微调完全根据您的特定用例定制模型。

- 宽松的 Apache 2.0 许可证:

自由构建,不受版权限制或专利风险 - 非常适合实验、定制和商业部署。

量化 - MXFP4 格式

OpenAI 利用量化技术来减少 gpt-oss 模型的内存占用。这些模型在训练后会将混合专家 (MoE) 权重量化为 MXFP4 格式,其中每个参数的权重被量化为 4.25 位。MoE 权重占总参数数量的 90% 以上,将这些权重量化为 MXFP4 格式后,较小的模型可以在内存低至 16GB 的系统上运行,而较大的模型则可以在单个 80GB 的 GPU 上运行。

Ollama 原生支持 MXFP4 格式,无需额外量化或转换。Ollama 的新引擎已开发新内核,以支持 MXFP4 格式。

Ollama 与 OpenAI 合作,根据他们的参考实现进行基准测试,以确保 Ollama 的实现具有相同的质量。

20B参数模型

gpt-oss-20b模型专为低延迟、本地或特殊用例而设计。

120B参数模型

gpt-oss-120b该模型专为生产、通用、高推理用例而设计。

NVIDIA 与 Ollama 合作在 GeForce RTX 和 RTX PRO GPU 上加速 gpt-oss

NVIDIA 和 Ollama 正在深化合作,以提升 NVIDIA GeForce RTX 和 RTX PRO GPU 上的模型性能。此次合作使使用 RTX 的 PC 用户能够精准地利用 OpenAI 的 gpt-oss 模型的功能。

我们将继续与 Ollama 合作,并不断改进。未来,我们将发布一篇关于该模型的深入工程文章。

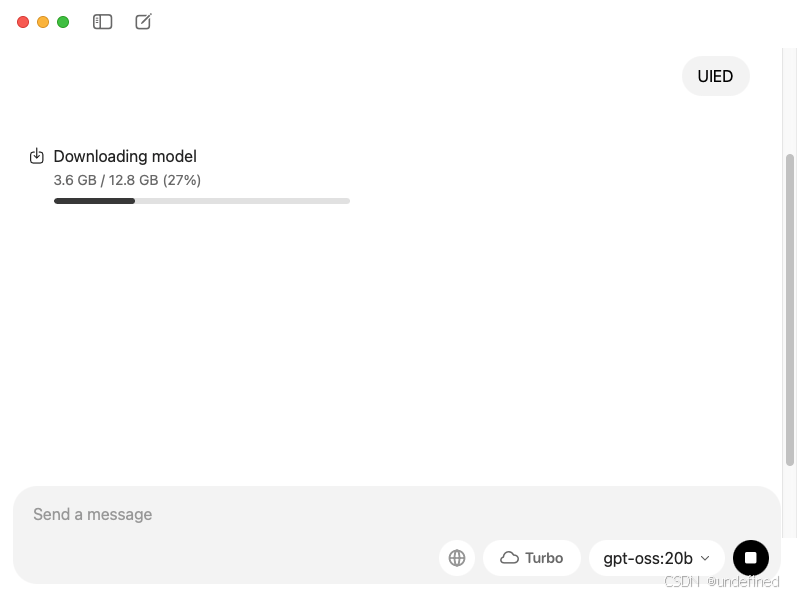

开始

1、下载最新的 Ollama 版本

2、安装模型

3、使用教程

该模型可以直接在 Ollama 的新应用程序中或通过终端下载:

ollama 运行 gpt-oss:20b

ollama 运行 gpt-oss:120b

ollama卸载方法

https://www.uied.cn/circle/85234.html

写在 最后

AI资料

AI学习平台 uied.cn

AI免费工具 uiedtool.com

AI资讯热榜 hot.uied.cn

AI工具导航 hao.uied.cn/ai

)

-Java并发篇)

![[AI 生成] Spark 面试题](http://pic.xiahunao.cn/[AI 生成] Spark 面试题)