文章目录

- 概要

- 1.安装必要的环境

- 2.安装 PyTorch

- 3.安装 Transformers 和 Datasets

- 4.克隆 LLaMA Factory 仓库和安装LLaMA Factory

- 5.准备数据和模型配置

- 6.运行 LLaMA Factory

- 7.监控和调整

- 8.后续步骤

概要

LLaMA Factory 是一个简单易用且高效的大型语言模型训练与微调平台。通过它,用户可以在无需编写任何代码的前提下,在本地完成上百种预训练模型的微调。

1.安装必要的环境

首先,确保你的 CentOS 系统已经安装了 Python。LLaMA Factory 需要 Python 3.6 或更高版本。你可以通过以下命令安装 Python 3(如果尚未安装):

sudo yum install -y python3

sudo yum install -y python3-pip

2.安装 PyTorch

LLaMA Factory 使用 PyTorch 进行模型的训练和推理,因此你需要安装 PyTorch。你可以访问 PyTorch 官方网站 获取安装命令。例如,对于 CUDA 11.3 和 Python 3.8,可以使用以下命令

pip3 install torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cu113

3.安装 Transformers 和 Datasets

LLaMA Factory 使用 Hugging Face 的 transformers 和 datasets 库。你可以使用 pip 来安装这些库:

pip3 install transformers datasets

4.克隆 LLaMA Factory 仓库和安装LLaMA Factory

克隆 LLaMA Factory 的 GitHub 仓库到你的系统中并安装 LLaMA Factory

git clone https://github.com/hiyouga/LLaMA-Factory.git

cd LLaMA-Factory

pip install -e ".[torch,metrics]" -i https://pypi.tuna.tsinghua.edu.cn/simple

执行 llamafactory-cli version 验证安装情况:

[root@VM-0-9-tencentos ~]# whereis llamafactory-cli

llamafactory-cli: /usr/local/bin/llamafactory-cli

[root@VM-0-9-tencentos ~]# /usr/local/bin/llamafactory-cli version

----------------------------------------------------------

| Welcome to LLaMA Factory, version 0.9.4.dev0 |

| |

| Project page: https://github.com/hiyouga/LLaMA-Factory |

----------------------------------------------------------

[root@VM-0-9-tencentos ~]#

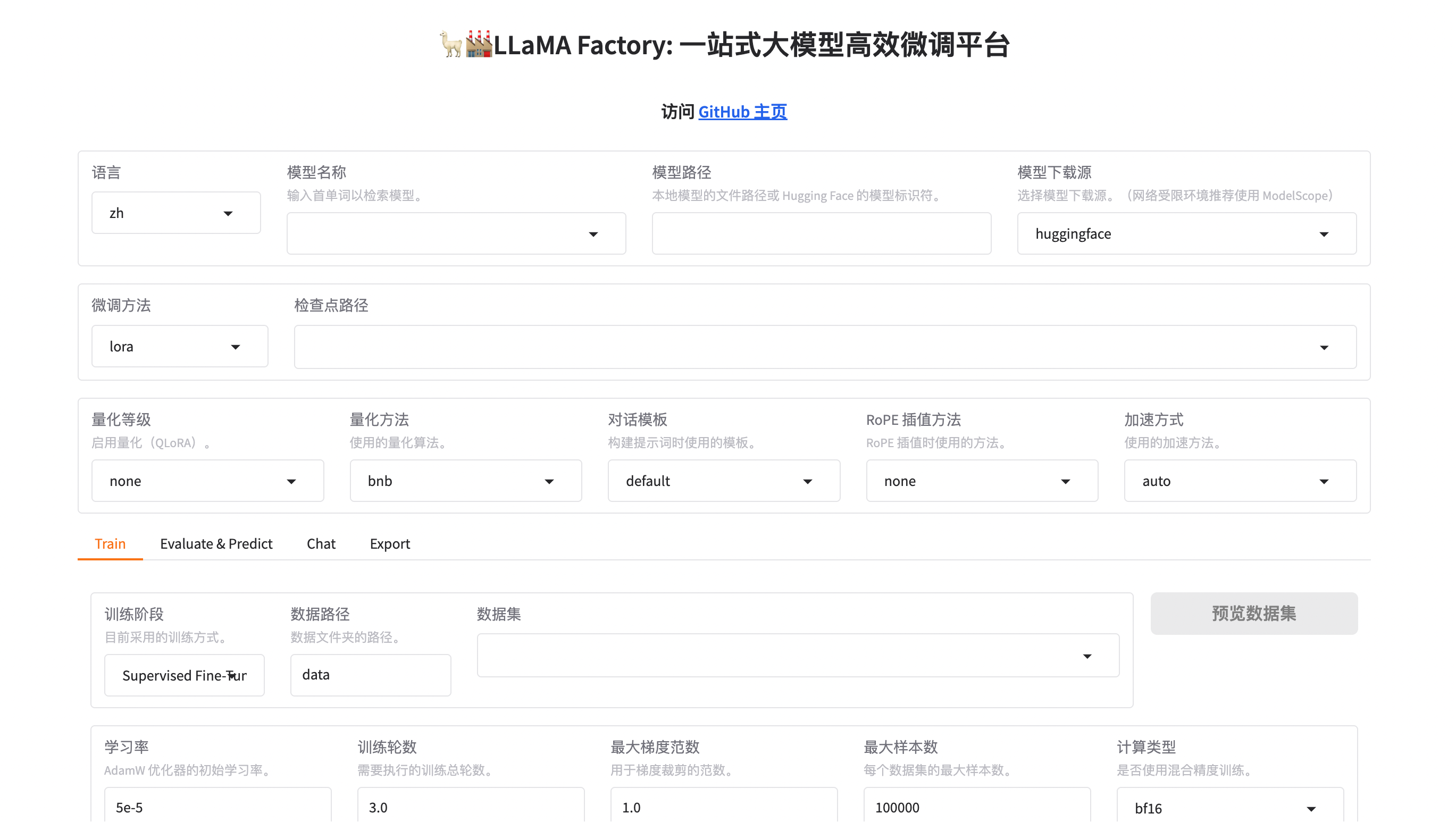

依赖安装完成后,执行:llamafactory-cli webui,可以启动 LLaMa Factory 的 webui:

llamafactory-cli webui

可以使用下面的命令启动,即使会话关闭了,UI界面仍可以访问:

nohup llamafactory-cli webui > llamafactory.log 2>&1 &

UI界面启动成功,使用 IP:7860 端口进行访问

到此,LLaMA Factory在linux服务器上的安装就完成了。

5.准备数据和模型配置

在开始训练之前,你需要准备数据集和配置文件。这通常包括下载数据集、编写配置文件等。你可以参考 LLaMA Factory 的 GitHub 仓库中的说明来准备这些资源。

6.运行 LLaMA Factory

一切准备就绪后,你可以运行 LLaMA Factory 来训练你的模型。通常,这涉及到运行一个 Python 脚本来启动训练过程

python3 train.py --config config.json

确保 config.json 是你的配置文件路径,其中包含了所有必要的设置。

7.监控和调整

在训练过程中,监控模型的性能并根据需要进行调整。你可以使用 TensorBoard 或其他工具来监控训练过程。

8.后续步骤

一旦模型训练完成,你可以使用它进行推理或进一步优化。确保保存好你的模型和相关的元数据以便后续使用。

以上就是在 CentOS 上安装和使用 LLaMA Factory 的基本步骤。如果你遇到任何问题,可以查看 LLaMA Factory 的 GitHub 仓库中的文档或寻求社区的帮助。

![[ubuntu][C++]onnxruntime安装cpu版本后测试代码](http://pic.xiahunao.cn/[ubuntu][C++]onnxruntime安装cpu版本后测试代码)

)