一、K8S介绍及部署

1 应用的部署方式演变

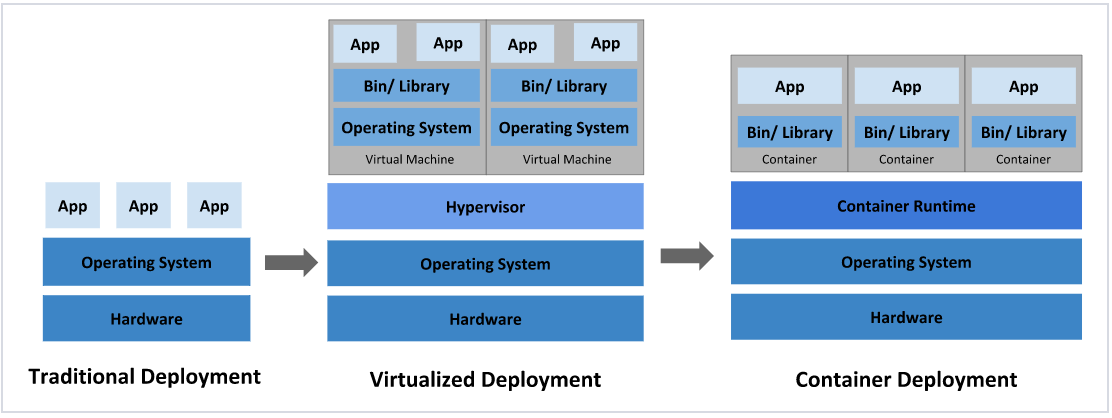

部署应用程序的方式上,主要经历了三个阶段:

传统部署:互联网早期,会直接将应用程序部署在物理机上

-

优点:简单,不需要其它技术的参与

-

缺点:不能为应用程序定义资源使用边界,很难合理地分配计算资源,而且程序之间容易产生影响

虚拟化部署:可以在一台物理机上运行多个虚拟机,每个虚拟机都是独立的一个环境

-

优点:程序环境不会相互产生影响,提供了一定程度的安全性

-

缺点:增加了操作系统,浪费了部分资源

容器化部署:与虚拟化类似,但是共享了操作系统

[!NOTE]

容器化部署方式给带来很多的便利,但是也会出现一些问题,比如说:

- 一个容器故障停机了,怎么样让另外一个容器立刻启动去替补停机的容器

- 当并发访问量变大的时候,怎么样做到横向扩展容器数量

2 容器编排应用

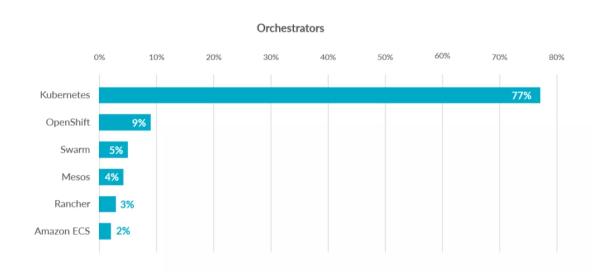

为了解决这些容器编排问题,就产生了一些容器编排的软件:

- Swarm:Docker自己的容器编排工具

- Mesos:Apache的一个资源统一管控的工具,需要和Marathon结合使用

- Kubernetes:Google开源的的容器编排工具

3 kubernetes 简介

- 在Docker 作为高级容器引擎快速发展的同时,在Google内部,容器技术已经应用了很多年

- Borg系统运行管理着成千上万的容器应用。

- Kubernetes项目来源于Borg,可以说是集结了Borg设计思想的精华,并且吸收了Borg系统中的经验和教训。

- Kubernetes对计算资源进行了更高层次的抽象,通过将容器进行细致的组合,将最终的应用服务交给用户。

kubernetes的本质是一组服务器集群,它可以在集群的每个节点上运行特定的程序,来对节点中的容器进行管理。目的是实现资源管理的自动化,主要提供了如下的主要功能:

- 自我修复:一旦某一个容器崩溃,能够在1秒中左右迅速启动新的容器

- 弹性伸缩:可以根据需要,自动对集群中正在运行的容器数量进行调整

- 服务发现:服务可以通过自动发现的形式找到它所依赖的服务

- 负载均衡:如果一个服务起动了多个容器,能够自动实现请求的负载均衡

- 版本回退:如果发现新发布的程序版本有问题,可以立即回退到原来的版本

- 存储编排:可以根据容器自身的需求自动创建存储卷

4 K8S的设计架构

1.4.1 K8S各个组件用途

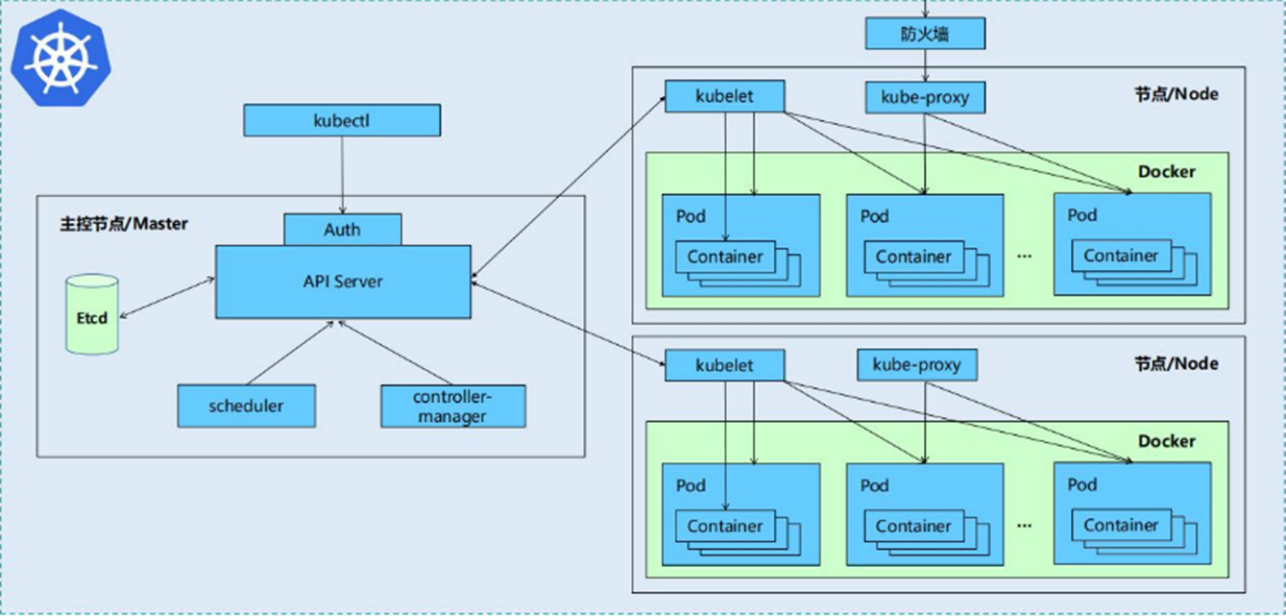

一个kubernetes集群主要是由控制节点(master)、**工作节点(node)**构成,每个节点上都会安装不同的组件

1 master:集群的控制平面,负责集群的决策

-

ApiServer : 资源操作的唯一入口,接收用户输入的命令,提供认证、授权、API注册和发现等机制

-

Scheduler : 负责集群资源调度,按照预定的调度策略将Pod调度到相应的node节点上

-

ControllerManager : 负责维护集群的状态,比如程序部署安排、故障检测、自动扩展、滚动更新等

-

Etcd :负责存储集群中各种资源对象的信息

2 node:集群的数据平面,负责为容器提供运行环境

- kubelet:负责维护容器的生命周期,同时也负责Volume(CVI)和网络(CNI)的管理

- Container runtime:负责镜像管理以及Pod和容器的真正运行(CRI)

- kube-proxy:负责为Service提供cluster内部的服务发现和负载均衡

1.4.2 K8S 各组件之间的调用关系

当我们要运行一个web服务时

-

kubernetes环境启动之后,

master和node都会将自身的信息存储到etcd数据库中 -

web服务的安装请求会首先被发送到master节点的apiServer组件

-

apiServer组件会调用scheduler组件来决定到底应该把这个服务安装到哪个node节点上

在此时,它会从

etcd中读取各个node节点的信息,然后按照一定的算法进行选择,并将结果告知apiServer -

apiServer调用controller-manager去调度Node节点安装web服务

-

kubelet接收到指令后,会通知docker,然后由docker来启动一个web服务的pod

-

如果需要访问web服务,就需要通过

kube-proxy来对pod产生访问的代理

1.4.3 K8S 的常用名词

-

Master:集群控制节点,每个集群需要至少一个master节点负责集群的管控

-

Node:工作负载节点,由master分配容器到这些node工作节点上,然后node节点上的

-

Pod:kubernetes的最小控制单元,容器都是运行在pod中的,一个pod中可以有1个或者多个容器

-

Controller:控制器,通过它来实现对pod的管理,比如启动pod、停止pod、伸缩pod的数量等等

-

Service:pod对外服务的统一入口,下面可以维护者同一类的多个pod

-

Label:标签,用于对pod进行分类,同一类pod会拥有相同的标签

-

NameSpace:命名空间,用来隔离pod的运行环境

1.4.4 k8S的分层架构

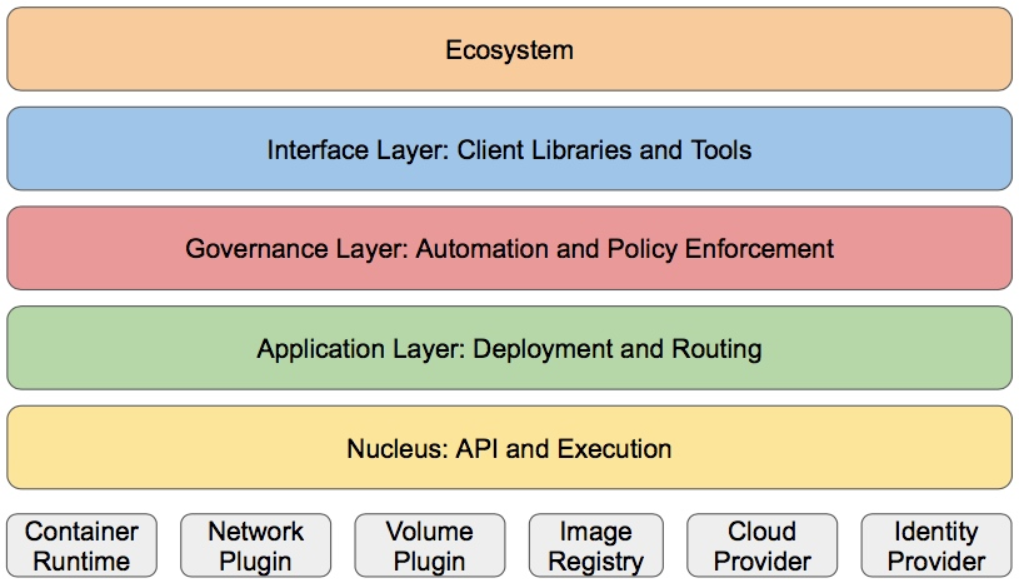

- 核心层:Kubernetes最核心的功能,对外提供API构建高层的应用,对内提供插件式应用执行环境

- 应用层:部署(无状态应用、有状态应用、批处理任务、集群应用等)和路由(服务发现、DNS解析等)

- 管理层:系统度量(如基础设施、容器和网络的度量),自动化(如自动扩展、动态Provision等)以及策略管理(RBAC、Quota、PSP、NetworkPolicy等)

- 接口层:kubectl命令行工具、客户端SDK以及集群联邦

- 生态系统:在接口层之上的庞大容器集群管理调度的生态系统,可以划分为两个范畴

- Kubernetes外部:日志、监控、配置管理、CI、CD、Workflow、FaaS、OTS应用、ChatOps等

- Kubernetes内部:CRI、CNI、CVI、镜像仓库、Cloud Provider、集群自身的配置和管理等

二 K8S集群环境搭建

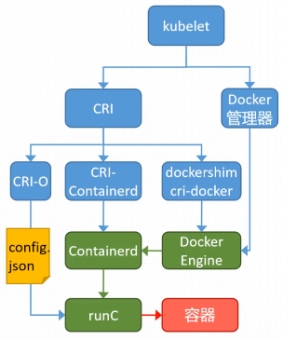

2.1 k8s中容器的管理方式

K8S 集群创建方式有3种:

centainerd

默认情况下,K8S在创建集群时使用的方式

docker

Docker使用的普记录最高,虽然K8S在1.24版本后已经费力了kubelet对docker的支持,但时可以借助cri-docker方式来实现集群创建

cri-o

CRI-O的方式是Kubernetes创建容器最直接的一种方式,在创建集群的时候,需要借助于cri-o插件的方式来实现Kubernetes集群的创建。

[!NOTE]

docker 和cri-o 这两种方式要对kubelet程序的启动参数进行设置

2.2 k8s 集群部署

1. 前置任务部署

- 全部主机都要设置

- 把swap给禁用掉

]# systemctl mask swap.target

]# swapoff -a

]#重启主机,无输出即可

#swapon -s]# vim /etc/fstab

#

# /etc/fstab

# Created by anaconda on Sun Feb 19 17:38:40 2023

#

# Accessible filesystems, by reference, are maintained under '/dev/disk'

# See man pages fstab(5), findfs(8), mount(8) and/or blkid(8) for more info

#

/dev/mapper/rhel-root / xfs defaults 0 0

UUID=ddb06c77-c9da-4e92-afd7-53cd76e6a94a /boot xfs defaults 0 0

#/dev/mapper/rhel-swap swap swap defaults 0 0

/dev/cdrom /media iso9660 defaults 0 0]# systemctl daemon-reload[root@k8s-master ~]# vim /etc/hosts

127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4::1 localhost localhost.localdomain localhost6 localhost6.localdomain6

192.168.147.10 K8s_slave1.zym.org

192.168.147.20 K8s_slave2.zym.org

192.168.147.100 K8s_master.zym.org

192.168.147.200 reg.zym.org

harbor配置

mkdir -p packages

cd packages

scp docker.tar.gz root@192.168.147.100:/root/packages

scp docker.tar.gz root@192.168.147.10:/root/packages

scp docker.tar.gz root@192.168.147.20:/root/packagestar zxf docker.tar.gz

dnf install *.rpm -yvim /lib/systemd/system/docker.service

ExecStart=/usr/bin/dockerd -H fd:// --containerd=/run/containerd/containerd.sock --iptables=true

#########################systemctl enable --now docker.service#安装harbor

tar zxf harbor-offline-installer-v2.5.4.tgz

mkdir -p /data/certscd /root/packages/harbor/

cp harbor.yml.tmpl harbor.ymlvim harbor.yml

hostname: reg.zym.org

certificate: /data/certs/zym.org.crt

private_key: /data/certs/zym.org.key

harbor_admin_password: 123456

######################################./install.sh --with-chartmuseum#证书

mkdir -p /data/certs

openssl req -newkey rsa:4096 \

> -nodes -sha256 -keyout /data/certs/zym.org.key \

> -addext "subjectAltName = DNS:reg.zym.org" \

> -x509 -days 365 -out /data/certs/zym.org.crtCountry Name (2 letter code) [XX]:CN

State or Province Name (full name) []:guangxi

Locality Name (eg, city) [Default City]:cenxi

Organization Name (eg, company) [Default Company Ltd]:youeryuan

Organizational Unit Name (eg, section) []:harbor

Common Name (eg, your name or your server's hostname) []:reg.zym.org

Email Address []:admin.zym@zym.org

K8s节点

#检测SELinux是否为该状态

[root@K8smaster ~]# getenforce

Disabledtar zxf docker.tar.gz

dnf install *.rpm -yvim /lib/systemd/system/docker.service

ExecStart=/usr/bin/dockerd -H fd:// --containerd=/run/containerd/containerd.sock --iptables=true

###########################在Harbor传输密钥

[root@Harbor ~]# for i in 100 10 20; do ssh -l root 192.168.147.$i mkdir -p /etc/docker/certs.d; scp /data/certs/zym.org.crt root@192.168.147.$i:/etc/docker/certs.d/ca.crt; done#继续配置节点

vim /etc/docker/daemon.json

{"registry-mirrors" : ["https://reg.zym.org"]

}

#指定的是Harbor仓库的主机地址systemctl enable --now docker.service

登录进Harbor仓库

[root@K8smaster ~]# cd /etc/docker/certs.d

[root@K8smaster certs.d]# mkdir -p reg.zym.org

[root@K8smaster certs.d]# mv ca.crt reg.zym.org/

[root@K8smaster certs.d]# ls

reg.zym.org

[root@K8smaster certs.d]# docker login reg.zym.org

Username: admin

Password:

WARNING! Your password will be stored unencrypted in /root/.docker/config.json.

Configure a credential helper to remove this warning. See

https://docs.docker.com/engine/reference/commandline/login/#credential-storesLogin Succeeded

2. 安装K8s

三台主机均安装

#此为源码安装

[root@K8smaster ~]# mkdir -p mnt

[root@K8smaster ~]# cd mnt/

[root@K8smaster mnt]# ls

cri-dockerd-0.3.14-3.el8.x86_64.rpm k8s-1.30.tar.gz libcgroup-0.41-19.el8.x86_64.rpm

[root@K8smaster mnt]# dnf install *.rpm -y[root@K8smaster ~]# vim /lib/systemd/system/cri-docker.service

#指定网络插件名称及基础容器镜像

ExecStart=/usr/bin/cri-dockerd --container-runtime-endpoint fd:// --network-plugin=cni --pod-infra-container-image=reg.zym.org/k8s/pause:3.9[root@K8smaster ~]# systemctl daemon-reload

[root@K8smaster ~]# systemctl enable --now cri-docker.service[root@K8smaster mnt]# tar zxf k8s-1.30.tar.gz

[root@K8smaster mnt]# dnf install *.rpm -y#设置kubectl命令补齐功能---仅需在主机上配置

[root@k8s-master ~]# dnf install bash-completion -y

[root@k8s-master ~]# echo "source <(kubectl completion bash)" >> ~/.bashrc

[root@k8s-master ~]# source ~/.bashrc

或者使用软件仓库安装

#部署软件仓库,添加K8S源

[root@k8s-master ~]# vim /etc/yum.repos.d/k8s.repo

[k8s]

name=k8s

baseurl=https://mirrors.aliyun.com/kubernetes-new/core/stable/v1.30/rpm

gpgcheck=0#安装软件

[root@k8s-master ~]# dnf install kubelet-1.30.0 kubeadm-1.30.0 kubectl-1.30.0 -y3. 在master节点拉取K8S所需镜像

[root@K8smaster mnt]# docker load -i k8s_docker_images-1.30.tardocker images | awk '/google/{print $1":"$2}' | awk -F / '{system("docker tag "$0" reg.zym.org/k8s/"$3)}'[root@K8smaster ~]# docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

reg.zym.org/k8s/kube-apiserver v1.30.0 c42f13656d0b 15 months ago 117MB

registry.aliyuncs.com/google_containers/kube-apiserver v1.30.0 c42f13656d0b 15 months ago 117MB

reg.zym.org/k8s/kube-controller-manager v1.30.0 c7aad43836fa 15 months ago 111MB

registry.aliyuncs.com/google_containers/kube-controller-manager v1.30.0 c7aad43836fa 15 months ago 111MB

reg.zym.org/k8s/kube-scheduler v1.30.0 259c8277fcbb 15 months ago 62MB

registry.aliyuncs.com/google_containers/kube-scheduler v1.30.0 259c8277fcbb 15 months ago 62MB

reg.zym.org/k8s/kube-proxy v1.30.0 a0bf559e280c 15 months ago 84.7MB

registry.aliyuncs.com/google_containers/kube-proxy v1.30.0 a0bf559e280c 15 months ago 84.7MB

reg.zym.org/k8s/etcd 3.5.12-0 3861cfcd7c04 18 months ago 149MB

registry.aliyuncs.com/google_containers/etcd 3.5.12-0 3861cfcd7c04 18 months ago 149MB

reg.zym.org/k8s/coredns v1.11.1 cbb01a7bd410 24 months ago 59.8MB

registry.aliyuncs.com/google_containers/coredns v1.11.1 cbb01a7bd410 24 months ago 59.8MB

reg.zym.org/k8s/pause 3.9 e6f181688397 2 years ago 744kB

registry.aliyuncs.com/google_containers/pause 3.9 e6f181688397 2 years ago 744kB#镜像上传

[root@K8smaster ~]# docker images | awk '/zym/{system("docker push " $1":"$2)}'

4. 集群初始化

#启动kubelet服务

[root@K8smaster ~]# systemctl enable --now kubelet.service[root@K8smaster ~]# kubeadm init --pod-network-cidr=10.244.0.0/16 --image-repository reg.zym.org/k8s --kubernetes-version v1.30.0 --cri-socket=unix:///var/run/cri-dockerd.sock#指定集群配置文件变量

[root@k8s-master ~]# echo "export KUBECONFIG=/etc/kubernetes/admin.conf" >> ~/.bash_profile

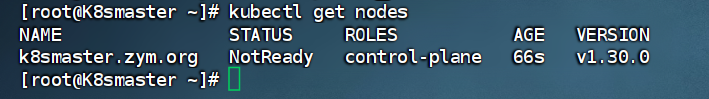

[root@K8smaster ~]# source ~/.bash_profile#当前节点没有就绪,因为还没有安装网络插件,容器没有运行

[root@K8smaster ~]# kubectl get nodes

NAME STATUS ROLES AGE VERSION

k8smaster.zym.org NotReady control-plane 66s v1.30.0

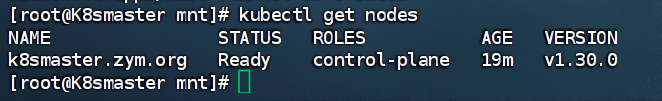

[root@K8smaster mnt]# docker load -i flannel-0.25.5.tag.gz

[root@K8smaster mnt]# docker tag flannel/flannel:v0.25.5 reg.zym.org/flannel/flannel:v0.25.5

#在Harbor仓库中创建flannel仓库,权限需为公开

[root@K8smaster mnt]# docker push reg.zym.org/flannel/flannel:v0.25.5[root@K8smaster mnt]# docker tag flannel/flannel-cni-plugin:v1.5.1-flannel1 reg.zym.org/flannel/flannel-cni-plugin:v1.5.1-flannel1

[root@K8smaster mnt]# docker push reg.zym.org/flannel/flannel-cni-plugin:v1.5.1-flannel1

查看仓库

[root@K8smaster mnt]# vim kube-flannel.yml146: image: flannel/flannel:v0.25.5

173: image: flannel/flannel-cni-plugin:v1.5.1-flannel1

184: image: flannel/flannel:v0.25.5[root@K8smaster mnt]# kubectl apply -f kube-flannel.yml

namespace/kube-flannel created

serviceaccount/flannel created

clusterrole.rbac.authorization.k8s.io/flannel created

clusterrolebinding.rbac.authorization.k8s.io/flannel created

configmap/kube-flannel-cfg created

daemonset.apps/kube-flannel-ds created[root@K8smaster mnt]# kubectl get nodes

NAME STATUS ROLES AGE VERSION

k8smaster.zym.org Ready control-plane 19m v1.30.0

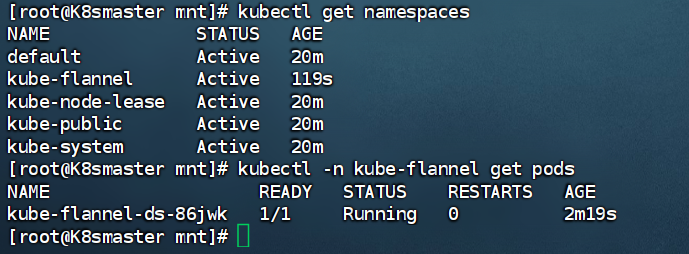

查看

kubectl get namespaces

5. 添加工作节点

[root@K8smaster mnt]# kubeadm token create --print-join-command

kubeadm join 192.168.147.100:6443 --token cqu5z7.42608w7amd9v3tyg --discovery-token-ca-cert-hash sha256:2fe2b3cdf1c4ee177ce102e6ce2d8ec54322f23609e2c506e62c0b2576bab069#在slave上运行该命令

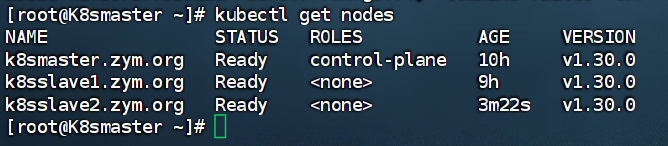

kubeadm join 192.168.147.100:6443 --token cqu5z7.42608w7amd9v3tyg --discovery-token-ca-cert-hash sha256:2fe2b3cdf1c4ee177ce102e6ce2d8ec54322f23609e2c506e62c0b2576bab069 --cri-socket=unix:///var/run/cri-dockerd.sock#在最后查看节点,状态均为Ready,安装成功

[root@K8smaster ~]# kubectl get nodes

一个为控制器节点,两个工作节点

6.镜像上传Harbor仓库

上传后,集群中可以获取镜像

#上传busyboxplus镜像

[root@Harbor docker-images]# docker load -i busyboxplus.tar.gz

[root@Harbor docker-images]# docker tag busyboxplus:latest reg.zym.org/library/busyboxplus:latest

[root@Harbor docker-images]# docker push reg.zym.org/library/busyboxplus:latest

二、K8s中的pod管理以及优化

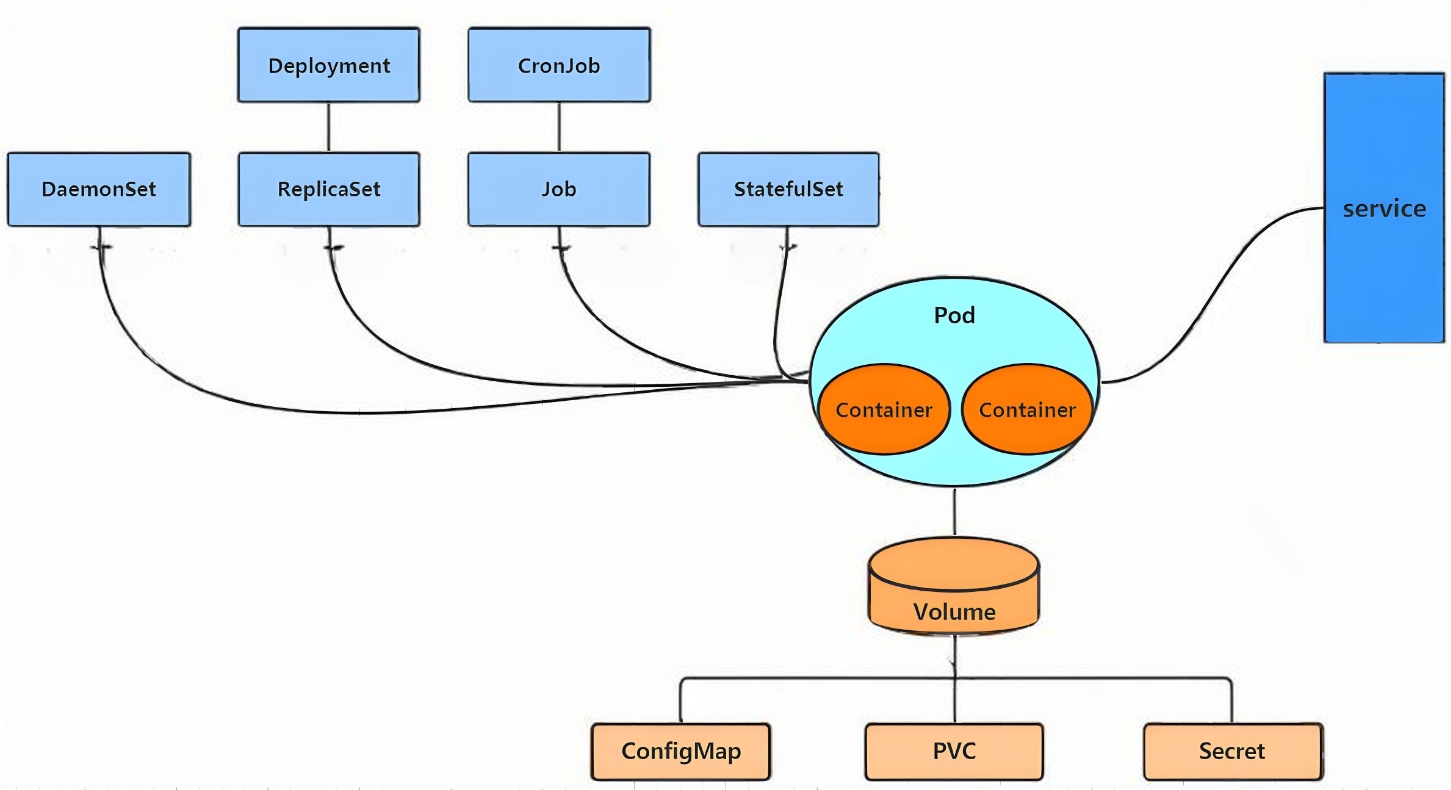

(一)K8s的资源

2.1 资源管理介绍

- K8s为一个集群系统,可以在集群中部署各种服务

- 在K8s中可以理解为资源,通过操作资源管理运行K8s

- 部署服务为,在集群中运行容器,将指定的程序在容器中运行

- pod为最小的管理单元,pod相当于进程,容器为线程;容器要在pod中运行

- 要通过pod控制器进行管理容器,服务的访问是由kubernetes提供的

Service资源来实现

2.2资源的运行方式

-

命令操作K8s资源—命令式对象管理

kubectl run nginx-pod --image=nginx:latest --port=80 -

apply命令和配置文件操作资源—声明式对象配置

kubectl apply -f nginx-pod.yaml -

命令配置和配置文件操作资源—命令式对象配置

- 创建之后,不可以覆盖更新

kubectl create/patch -f nginx-pod.yaml

各方式区别

| 类型 | 适用环境 | 优点 | 缺点 |

|---|---|---|---|

| 命令式对象管理 | 测试 | 简单 | 只能操作活动对象,无法审计、跟踪 |

| 命令式对象配置 | 开发 | 可以审计、跟踪 | 项目大时,配置文件多,操作麻烦 |

| 声明式对象配置 | 开发 | 支持目录操作 | 意外情况下难以调试 |

2.2.1 命令式对象管理

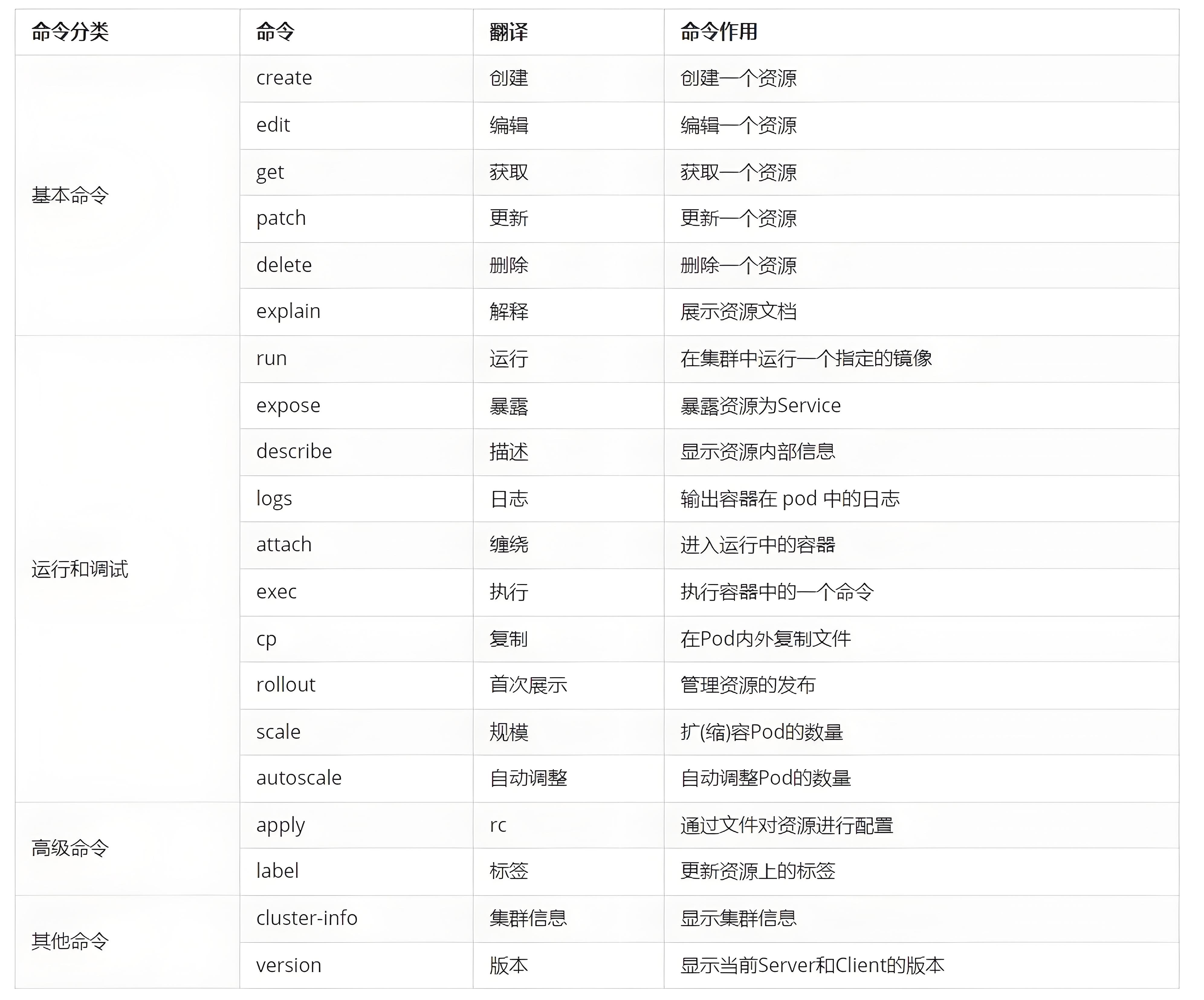

kubectl命令的语法如下:

kubectl [command] [type] [name] [flags]

comand:指定要对资源执行的操作,例如create、get、delete

type:指定资源类型,比如deployment、pod、service

name:指定资源的名称,名称大小写敏感

flags:指定额外的可选参数

# 查看所有pod

kubectl get pods# 查看某个pod

kubectl get pod <pod_name># 查看某个pod,以yaml格式展示结果

kubectl get pod <pod_name> -o yaml

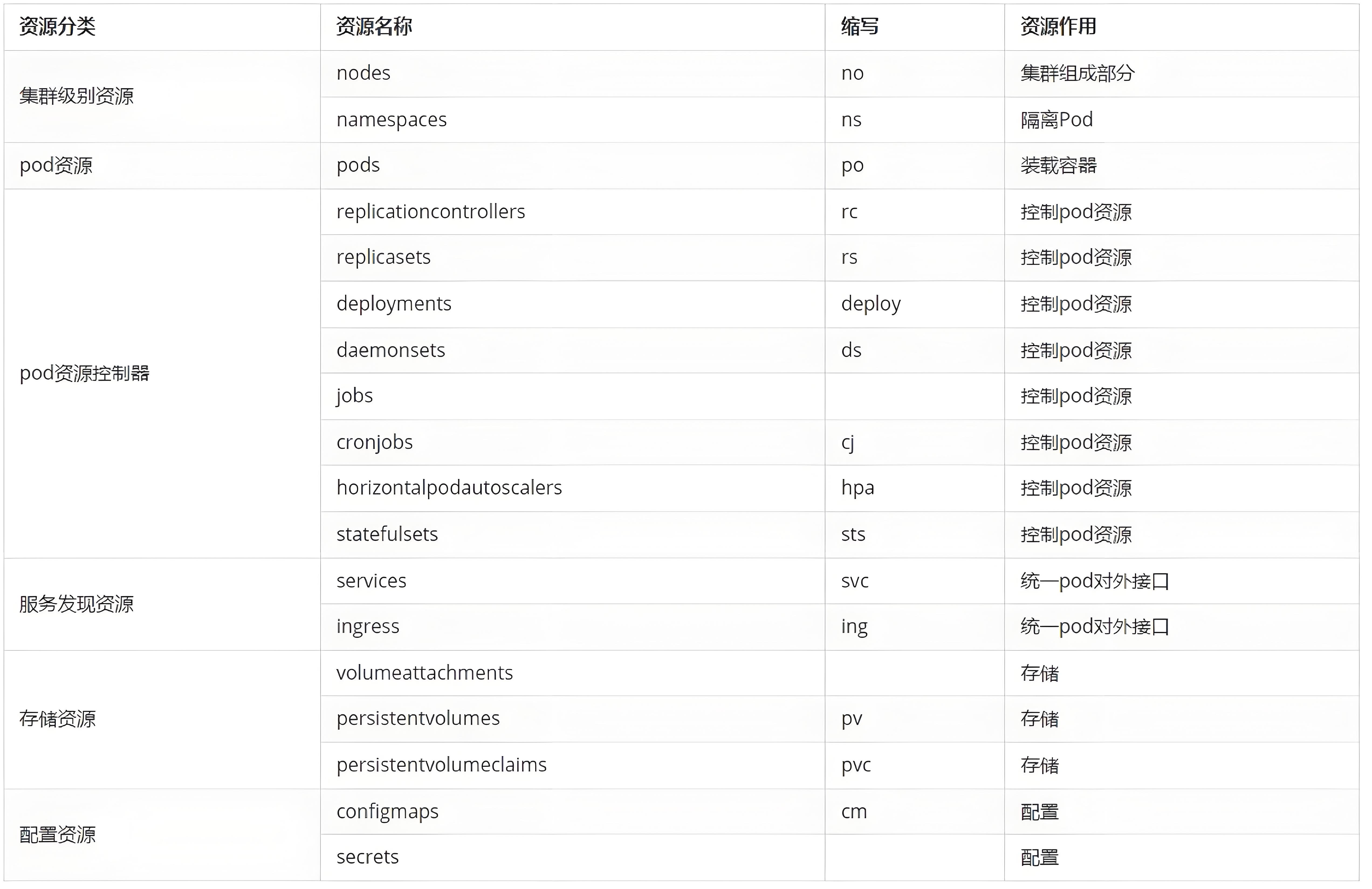

2.2.2 资源的类型

kubernetes中所有的内容都抽象为资源

kubectl api-resources

常用资源类型

kubect 常见命令操作

2.2.3 基本命令的示例

kubectl的官方详细说明:https://kubernetes.io/docs/reference/generated/kubectl/kubectl-commands

显示集群版本和信息

#显示集群版本

[root@k8s-master ~]# kubectl version

Client Version: v1.30.0

Kustomize Version: v5.0.4-0.20230601165947-6ce0bf390ce3

Server Version: v1.30.0#显示集群信息

[root@k8s-master ~]# kubectl cluster-info

Kubernetes control plane is running at https://172.25.254.100:6443

CoreDNS is running at https://172.25.254.100:6443/api/v1/namespaces/kube-system/services/kube-dns:dns/proxy

2.2.4 运行和调试命令示例

pod基本使用

#运行pod

[root@k8s-master ~]# kubectl run testpod --image nginx:1.23 #需要与仓库的版本一致,默认是为latest

pod/testpod created[root@k8s-master ~]# kubectl get pods

NAME READY STATUS RESTARTS AGE

testpod 1/1 Running 0 7s#进入pod

[root@K8smaster ~]# kubectl attach testpod -it#删除pod

[root@K8smaster ~]# kubectl delete pod liveness#查看pod详细信息

[root@k8s-master ~]# kubectl describe pods -o wide#删除多个pod

[root@k8s-master ~]# kubectl delete deployments.apps zym

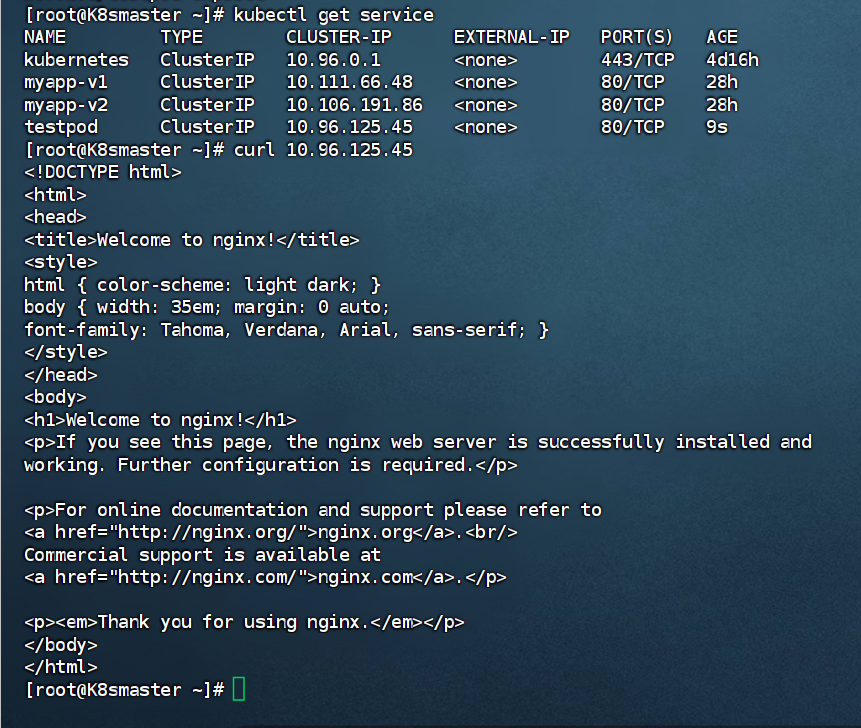

暴露端口,使得可以直接访问容器

#端口暴漏

[root@k8s-master ~]# kubectl get services

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kubernetes ClusterIP 10.96.0.1 <none> 443/TCP 2d14h[root@k8s-master ~]# kubectl expose pod testpod --port 80 --target-port 80

service/testpod exposed[root@k8s-master ~]# kubectl get services

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kubernetes ClusterIP 10.96.0.1 <none> 443/TCP 2d14h

testpod ClusterIP 10.106.78.42 <none> 80/TCP 18s

[root@k8s-master ~]# curl 10.106.78.42

<!DOCTYPE html>

<html>

<head>

<title>Welcome to nginx!</title>

结果截图:

*查看报错资源日志

#查看资源日志

[root@k8s-master ~]# kubectl logs pods/testpod#testpod为开启pod的名称

pod交互运行

#运行交互pod

[root@k8s-master ~]# kubectl run -it testpod --image busyboxIf you don't see a command prompt, try pressing enter.

/ #

/ # #ctrl+pq退出不停止pod#运行非交互pod

[root@k8s-master ~]# kubectl run nginx --image nginx

pod/nginx created#进入到已经运行的容器,且容器有交互环境

[root@k8s-master ~]# kubectl attach pods/testpod -it

If you don't see a command prompt, try pressing enter.

/ #

/ ##在已经运行的pod中运行指定命令

[root@k8s-master ~]# kubectl exec -it pods/nginx /bin/bash

kubectl exec [POD] [COMMAND] is DEPRECATED and will be removed in a future version. Use kubectl exec [POD] -- [COMMAND] instead.

root@nginx:/#

控制器创建

#创建一个webcluster控制器,控制器中pod数量为2

[root@k8s-master ~]# kubectl create deployment webcluseter --image nginx --replicas 2

#查看控制器

[root@k8s-master ~]# kubectl get deployments.apps

NAME READY UP-TO-DATE AVAILABLE AGE

web 3/3 3 3 69m

#编辑控制器配置

[root@k8s-master ~]# kubectl edit deployments.apps web

@@@@省略内容@@@@@@

spec:progressDeadlineSeconds: 600replicas: 2[root@k8s-master ~]# kubectl get deployments.apps

NAME READY UP-TO-DATE AVAILABLE AGE

web 2/2 2 2 73m

#利用补丁更改控制器配置

[root@k8s-master ~]# kubectl patch deployments.apps web -p '{"spec":{"replicas":4}}'

deployment.apps/web patched

[root@k8s-master ~]# kubectl get deployments.apps

NAME READY UP-TO-DATE AVAILABLE AGE

web 4/4 4 4 74m

*资源删除

#删除资源

[root@k8s-master ~]# kubectl delete deployments.apps web

deployment.apps "web" deleted

2.3 高级命令示例

#管理资源标签

[root@k8s-master ~]# kubectl run nginx --image nginx

[root@k8s-master ~]# kubectl get pods --show-labels

NAME READY STATUS RESTARTS AGE LABELS

nginx 1/1 Running 0 12s run=nginx[root@k8s-master ~]# kubectl label pods nginx app=lee

[root@k8s-master ~]# kubectl get pods --show-labels

NAME READY STATUS RESTARTS AGE LABELS

nginx 1/1 Running 0 57s app=lee,run=nginx#更改标签

[root@k8s-master ~]# kubectl label pods nginx app=webcluster --overwrite#删除标签

[root@k8s-master ~]# kubectl label pods nginx app-

pod/nginx unlabeled

[root@k8s-master ~]# kubectl get pods nginx --show-labels

NAME READY STATUS RESTARTS AGE LABELS

nginx 1/1 Running 0 7m56s run=nginx#标签时控制器识别pod示例的标识

[root@k8s-master ~]# kubectl get pods --show-labels

NAME READY STATUS RESTARTS AGE LABELS

nginx 1/1 Running 0 11m run=nginx

webcluster-7c584f774b-66zbd 1/1 Running 0 2m10s app=webcluster,pod-template-hash=7c584f774b

webcluster-7c584f774b-9x2x2 1/1 Running 0 35m app=webcluster,pod-template-hash=7c584f774b#删除pod上的标签

root@k8s-master ~]# kubectl label pods webcluster-7c584f774b-66zbd app-

pod/webcluster-7c584f774b-66zbd unlabeled#控制器会重新启动新pod

[root@k8s-master ~]# kubectl get pods --show-labels

NAME READY STATUS RESTARTS AGE LABELS

nginx 1/1 Running 0 11m run=nginx

webcluster-7c584f774b-66zbd 1/1 Running 0 2m39s pod-template-hash=7c584f774b

webcluster-7c584f774b-9x2x2 1/1 Running 0 36m app=webcluster,pod-template-hash=7c584f774b

webcluster-7c584f774b-hgprn 1/1 Running 0 2s app=webcluster,pod-template-hash=7c584f774b

(二)pod是什么?

- Pod是可以创建和管理Kubernetes计算的最小可部署单元

- 一个Pod代表着集群中运行的一个进程,每个pod都有一个唯一的ip

- 一个pod类似一个豌豆荚,包含一个或多个容器(通常是docker)

- 多个容器间共享IPC、Network和UTC namespace

2.1 创建自主式pod

在生产中不推荐

| 优点 | 缺点 |

|---|---|

| 灵活性高—可以精确控制 Pod 的各种配置参数,包括容器的镜像、资源限制、环境变量、命令和参数等,满足特定的应用需求 | 管理复杂—如果需要管理大量的 Pod,手动创建和维护会变得非常繁琐和耗时。难以实现自动化的扩缩容、故障恢复等操作 |

| 学习和调试方便—于学习 Kubernetes 的原理和机制非常有帮助,通过手动创建 Pod 可以深入了解 Pod 的结构和配置方式。在调试问题时,可以更直接地观察和调整 Pod 的设置 | 缺乏高级功能—无法自动享受 Kubernetes 提供的高级功能,如自动部署、滚动更新、服务发现等。这可能导致应用的部署和管理效率低下 |

| 适用于特殊场景—在一些特殊情况下,如进行一次性任务、快速验证概念或在资源受限的环境中进行特定配置时,手动创建 Pod 可能是一种有效的方式 | 可维护性差—动创建的 Pod 在更新应用版本或修改配置时需要手动干预,容易出现错误,并且难以保证一致性。相比之下,通过声明式配置或使用 Kubernetes 的部署工具可以更方便地进行应用的维护和更新 |

#查看所有pods

[root@k8s-master ~]# kubectl get pods

No resources found in default namespace.#建立一个名为zym的pod

[root@k8s-master ~]# kubectl run zym --image nginx

pod/timinglee created[root@k8s-master ~]# kubectl get pods

NAME READY STATUS RESTARTS AGE

zym 1/1 Running 0 6s#显示pod的较为详细的信息

[root@k8s-master ~]# kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

zym 1/1 Running 0 11s 10.244.1.17 k8s-node1.zym.org <none> <none>

2.2 利用控制器管理pod(推荐)

高可用性和可靠性:

- 自动故障恢复:如果一个 Pod 失败或被删除,控制器会自动创建新的 Pod 来维持期望的副本数量。确保应用始终处于可用状态,减少因单个 Pod 故障导致的服务中断。

- 健康检查和自愈:可以配置控制器对 Pod 进行健康检查(如存活探针和就绪探针)。如果 Pod 不健康,控制器会采取适当的行动,如重启 Pod 或删除并重新创建它,以保证应用的正常运行。

可扩展性:

- 轻松扩缩容:可以通过简单的命令或配置更改来增加或减少 Pod 的数量,以满足不同的工作负载需求。例如,在高流量期间可以快速扩展以处理更多请求,在低流量期间可以缩容以节省资源。

- 水平自动扩缩容(HPA):可以基于自定义指标(如 CPU 利用率、内存使用情况或应用特定的指标)自动调整 Pod 的数量,实现动态的资源分配和成本优化

版本管理和更新:

- 滚动更新:对于 Deployment 等控制器,可以执行滚动更新来逐步替换旧版本的 Pod 为新版本,确保应用在更新过程中始终保持可用。可以控制更新的速率和策略,以减少对用户的影响

- 回滚:如果更新出现问题,可以轻松回滚到上一个稳定版本,保证应用的稳定性和可靠性

声明式配置:

- 简洁的配置方式:使用 YAML 或 JSON 格式的声明式配置文件来定义应用的部署需求。这种方式使得配置易于理解、维护和版本控制,同时也方便团队协作

- 期望状态管理:只需要定义应用的期望状态(如副本数量、容器镜像等),控制器会自动调整实际状态与期望状态保持一致。无需手动管理每个 Pod 的创建和删除,提高了管理效率

服务发现和负载均衡:

- 自动注册和发现:Kubernetes 中的服务(Service)可以自动发现由控制器管理的 Pod,并将流量路由到它们。这使得应用的服务发现和负载均衡变得简单和可靠,无需手动配置负载均衡器

- 流量分发:可以根据不同的策略(如轮询、随机等)将请求分发到不同的 Pod,提高应用的性能和可用性

多环境一致性:

- 一致的部署方式:在不同的环境(如开发、测试、生产)中,可以使用相同的控制器和配置来部署应用,确保应用在不同环境中的行为一致。这有助于减少部署差异和错误,提高开发和运维效率

示例:

#建立控制器并自动运行pod

[root@k8s-master ~]# kubectl create deployment timinglee --image nginx

[root@k8s-master ~]# kubectl get pods

NAME READY STATUS RESTARTS AGE

timinglee-859fbf84d6-mrjvx 1/1 Running 0 37m#为pod扩容

[root@k8s-master ~]# kubectl scale deployment timinglee --replicas 6

deployment.apps/timinglee scaled[root@k8s-master ~]# kubectl get pods

NAME READY STATUS RESTARTS AGE

timinglee-859fbf84d6-8rgkz 0/1 ContainerCreating 0 1s

timinglee-859fbf84d6-ddndl 0/1 ContainerCreating 0 1s

timinglee-859fbf84d6-m4r9l 0/1 ContainerCreating 0 1s

timinglee-859fbf84d6-mrjvx 1/1 Running 0 37m

timinglee-859fbf84d6-tsn97 1/1 Running 0 20s

timinglee-859fbf84d6-xgskk 0/1 ContainerCreating 0 1s#为timinglee缩容

root@k8s-master ~]# kubectl scale deployment timinglee --replicas 2

deployment.apps/timinglee scaled[root@k8s-master ~]# kubectl get pods

NAME READY STATUS RESTARTS AGE

timinglee-859fbf84d6-mrjvx 1/1 Running 0 38m

timinglee-859fbf84d6-tsn97 1/1 Running 0 73s

2.3 应用版本的更新

#利用控制器建立pod

[root@k8s-master ~]# kubectl create deployment timinglee --image myapp:v1 --replicas 2

deployment.apps/timinglee created#暴漏端口

[root@k8s-master ~]# kubectl expose deployment timinglee --port 80 --target-port 80

service/timinglee exposed

[root@k8s-master ~]# kubectl get services

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kubernetes ClusterIP 10.96.0.1 <none> 443/TCP 2d17h

timinglee ClusterIP 10.110.195.120 <none> 80/TCP 8s#访问服务

[root@k8s-master ~]# curl 10.110.195.120

Hello MyApp | Version: v1 | <a href="hostname.html">Pod Name</a>

[root@k8s-master ~]# curl 10.110.195.120

Hello MyApp | Version: v1 | <a href="hostname.html">Pod Name</a>

[root@k8s-master ~]# curl 10.110.195.120#查看历史版本

[root@k8s-master ~]# kubectl rollout history deployment timinglee

deployment.apps/timinglee

REVISION CHANGE-CAUSE

1 <none>#更新控制器镜像版本

[root@k8s-master ~]# kubectl set image deployments/timinglee myapp=myapp:v2

deployment.apps/timinglee image updated#查看历史版本

[root@k8s-master ~]# kubectl rollout history deployment timinglee

deployment.apps/timinglee

REVISION CHANGE-CAUSE

1 <none>

2 <none>#访问内容测试

[root@k8s-master ~]# curl 10.110.195.120

Hello MyApp | Version: v2 | <a href="hostname.html">Pod Name</a>

[root@k8s-master ~]# curl 10.110.195.120#版本回滚

[root@k8s-master ~]# kubectl rollout undo deployment timinglee --to-revision 1

deployment.apps/timinglee rolled back

[root@k8s-master ~]# curl 10.110.195.120

Hello MyApp | Version: v1 | <a href="hostname.html">Pod Name</a>

2.4 用yaml文件部署应用

yaml文件优点

| 优点 | 声明式的配置 | 灵活性和可扩展性 | 能与工具集成 |

|---|---|---|---|

| 清晰表达期望状态 | 丰富的配置选项 | 与 CI/CD 流程集成 | |

| 可重复性和版本控制 | 组合和扩展 | 命令行工具支持 |

- 声明式配置

- 以声明式的方式描述应用的部署需求,包括副本数量、容器配置、网络设置等,得配置易于理解和维护

- 配置文件可以被版本控制,确保在不同环境中的部署一致性,也可以回滚到之前版本

2.4.1 配置参数说明

| 参数名称 | 类型 | 参数说明 |

|---|---|---|

| version | String | 这里是指的是K8S API的版本,目前基本上是v1,可以用kubectl api-versions命令查询 |

| kind | String | 这里指的是yaml文件定义的资源类型和角色,比如:Pod |

| metadata | Object | 元数据对象,固定值就写metadata |

| metadata.name | String | 元数据对象的名字,这里由我们编写,比如命名Pod的名字 |

| metadata.namespace | String | 元数据对象的命名空间,由我们自身定义 |

| Spec | Object | 详细定义对象,固定值写Spec |

参数名称 类型 参数说明

Spec #Object #详细定义对象,固定值就写Specspec.containers[] #list #这里是Spec对象的容器列表定义,是个列表spec.containers[].name #String #这里定义容器的名字spec.containers[].image #string #这里定义要用到的镜像名称spec.containers[].imagePullPolicy #String #定义镜像拉取策略,有三个值可选:#a.Always: 每次都尝试重新#b. IfNotPresent:如果本地有镜像就使用本地镜像#c.Never:表示仅使用本地镜像spec.containers[].command[] #list #指定容器运行时启动的命令,若未指定则运行容器打包时指定的命令 |spec.containers[].args[] #list #指定容器运行参数,可以指定多个spec.containers[].workingDir#String #指定容器工作目录

spec.containers[].volumeMounts[]#list #指定容器内部的存储卷配置

spec.containers[].volumeMounts[].name#String #指定可以被容器挂载的存储卷的名称

spec.containers[].volumeMounts[].mountPath#String #指定可以被容器挂载的存储卷的路径

spec.containers[].volumeMounts[].readOnly#String #设置存储卷路径的读写模式,ture或false,默认为读写模式

spec.containers[].ports[]#list #指定容器需要用到的端口列表

spec.containers[].ports[].name#String #指定端口名称

spec.containers[].ports[].containerPort#String #指定容器需要监听的端口号

spec.containers[] ports[].hostPort#String #指定容器所在主机需要监听的端口号,默认跟上面containerPort相同,注意设置了hostPort同一台主机无法启动该容器的相同副本(因为主机的端口号不能相同,这样会冲突)| spec.containers[].ports[].protocol | String | 指定端口协议,支持TCP和UDP,默认值为TCP

| spec.containers[].env[] | list | 指定容器运行前需设置的环境变量列表

| spec.containers[].env[].name | String | 指定环境变量名称

| spec.containers[].env[].value | String | 指定环境变量值

| spec.containers[].resources | Object | 指定资源限制和资源请求的值(这里开始就是设置容器的资源上限)

| spec.containers[].resources.limits | Object | 指定设置容器运行时资源的运行上限

| spec.containers[].resources.limits.cpu | String | 指定CPU的限制,单位为核心数,1=1000m

| spec.containers[].resources.limits.memory | String | 指定MEM内存的限制,单位为MIB、GiB

| spec.containers[].resources.requests | Object | 指定容器启动和调度时的限制设置

| spec.containers[].resources.requests.cpu | String | CPU请求,单位为core数,容器启动时初始化可用数量

| spec.containers[].resources.requests.memory | String | 内存请求,单位为MIB、GIB,容器启动的初始化可用数量| spec.restartPolicy | string | 定义Pod的重启策略,默认值为Always.(1)Always: Pod-旦终止运行,无论容器是如何 终止的,kubelet服务都将重启它 (2)OnFailure: 只有Pod以非零退出码终止时,kubelet才会重启该容器。如果容器正常结束(退出码为0),则kubelet将不会重启它(3) Never: Pod终止后,kubelet将退出码报告给Master,不会重启该

spec.nodeSelector | Object | 定义Node的Label过滤标签,以key:value格式指定spec.imagePullSecrets | Object | 定义pull镜像时使用secret名称,以name:secretkey格式指定

pec.hostNetwork | Boolean | 定义是否使用主机网络模式,默认值为false。设置true表示使用宿主机网络,不使用docker网桥,同时设置了true将无法在同一台宿主机 上启动第二个副本

2.5 yaml编写示例

用命令获取yaml模板,以下均编写yaml配置文件

kubectl run zym --image myapp:v1 --dry-run=client -o yaml > pod.yml

示例1:运行简单的单个容器pod

apiVersion: v1

kind: Pod

metadata:labels:run: timing #pod标签name: timinglee #pod名称

spec:containers:- image: myapp:v1 #pod镜像name: timinglee #容器名称

示例2:运行多个容器pod

!注意:如果多个容器运行在一个pod中,资源共享的同时在使用相同资源时也会干扰,比如端口占用

apiVersion: v1

kind: Pod

metadata:labels:run: timingname: timinglee

spec:containers:- image: nginx:latestname: web1- image: nginx:latestname: web2

[root@k8s-master ~]# kubectl apply -f pod.yml

pod/timinglee created#有一台启动失败

[root@k8s-master ~]# kubectl get pods

NAME READY STATUS RESTARTS AGE

timinglee 1/2 Error 1 (14s ago) 18s

#查看日志

[root@k8s-master ~]# kubectl logs timinglee web2

2024/08/31 12:43:20 [emerg] 1#1: bind() to [::]:80 failed (98: Address already in use)

nginx: [emerg] bind() to [::]:80 failed (98: Address already in use)

2024/08/31 12:43:20 [notice] 1#1: try again to bind() after 500ms

2024/08/31 12:43:20 [emerg] 1#1: still could not bind()

nginx: [emerg] still could not bind()

[!NOTE]

在一个pod中开启多个容器时一定要确保容器彼此不能互相干扰

apiVersion: v1

kind: Pod

metadata:labels:run: timingname: timinglee

spec:containers:- image: nginx:latestname: web1- image: busybox:latestname: busyboxcommand: ["/bin/sh","-c","sleep 1000000"][root@k8s-master ~]# kubectl get pods

NAME READY STATUS RESTARTS AGE

timinglee 2/2 Running 0 19s

示例3:端口映射

apiVersion: v1

kind: Pod

metadata:labels:run: timingleename: test

spec:containers:- image: myapp:v1name: myapp1ports:- name: httpcontainerPort: 80 #映射端口hostPort: 80protocol: TCP#测试

[root@k8s-master ~]# kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

test 1/1 Running 0 12s 10.244.1.2 k8s-node1.zym.org <none> <none>

示例4:设定环境变量

apiVersion: v1

kind: Pod

metadata:labels:run: timingleename: test

spec:containers:- image: busybox:latestname: busyboxcommand: ["/bin/sh","-c","echo $NAME;sleep 3000000"]env:- name: NAMEvalue: timinglee #环境变量设定[root@k8s-master ~]# kubectl logs pods/test busybox

timinglee

示例5:资源限制

!注意

资源限制会影响pod的Qos Class资源优先级,资源优先级分为Guaranteed > Burstable > BestEffort

QoS(Quality of Service)即服务质量

资源设定 优先级类型 资源限定未设定 BestEffort 资源限定设定且最大和最小不一致 Burstable-次敏感型 资源限定设定且最大和最小一致,内存和CPU均要设定 Guaranteed-敏感型

apiVersion: v1

kind: Pod

metadata:labels:run: timingleename: test

spec:containers:- image: myapp:v1name: myappresources:limits: #pod使用资源的最高限制 cpu: 500mmemory: 100Mrequests: #pod期望使用资源量,不能大于limitscpu: 500mmemory: 100M

root@k8s-master ~]# kubectl apply -f pod.yml

pod/test created[root@k8s-master ~]# kubectl get pods

NAME READY STATUS RESTARTS AGE

test 1/1 Running 0 3s[root@k8s-master ~]# kubectl describe pods testLimits:cpu: 500mmemory: 100MRequests:cpu: 500mmemory: 100M

QoS Class: Guaranteed

示例6:容器启动管理

apiVersion: v1

kind: Pod

metadata:labels:run: timingleename: test

spec:restartPolicy: Always #启动管理containers:- image: myapp:v1name: myapp

Always: 要确保运行,掉了要重新运行

Never:不管该Pod还能否运行

示例7:选择运行节点

apiVersion: v1

kind: Pod

metadata:labels:run: timingleename: test

spec:nodeSelector:kubernetes.io/hostname: k8s-node1 #选择运行节点restartPolicy: Alwayscontainers:- image: myapp:v1name: myapp

示例8:共享宿主机网络

[root@k8s-master ~]# vim pod.yml

apiVersion: v1

kind: Pod

metadata:labels:run: timingleename: test

spec:hostNetwork: truerestartPolicy: Alwayscontainers:- image: busybox:latestname: busyboxcommand: ["/bin/sh","-c","sleep 100000"][root@k8s-master ~]# kubectl apply -f pod.yml

pod/test created[root@k8s-master ~]# kubectl exec -it pods/test -c busybox -- /bin/sh

/ #ipconfig

三、K8S的管理

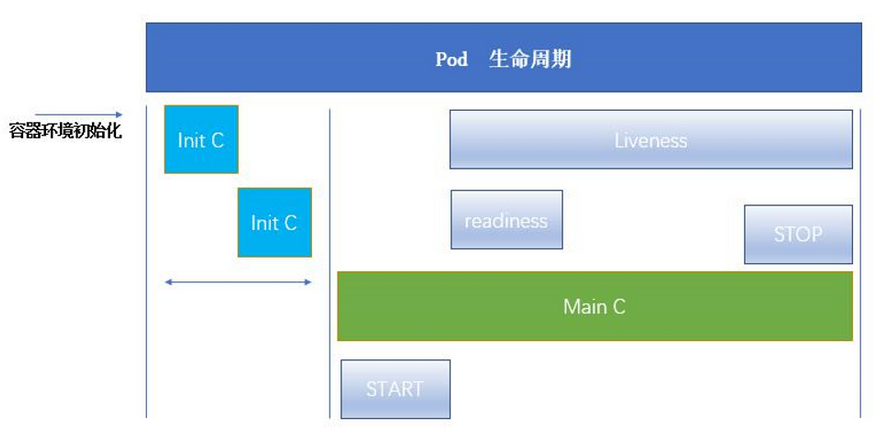

(一)POD的生命周期

3.1 init容器

- pod中是先于应用容器的启动

- 与普通容器区别

- 每个均要运行到完成

- 不支持

Readiness,init容器需要在pod容器运行之前运行完成 - 每一个容器需要运行成功后,再运行下一个

- 如果pod里的init容器启动失败,k8s会不断进行重启,直到init容器启动成功

3.1.1 容器的功能

- Init 容器可以包含安装过程中应用容器中不存在的实用工具或个性化代码

- Init 容器可以安全地运行这些工具,避免这些工具导致应用镜像的安全性降低

- 应用镜像的创建者和部署者可以各自独立工作

- Init 容器能以不同于Pod内应用容器的文件系统视图运行;init容器可具有访问 Secrets 的权限,而应用容器不能够访问

- 由于 Init 容器必须在应用容器启动之前运行完成;因此 Init 容器提供了一种机制来阻塞或延迟应用容器的启动,直到满足了一组先决条件。一旦前置条件满足,Pod内的所有的应用容器会并行启动

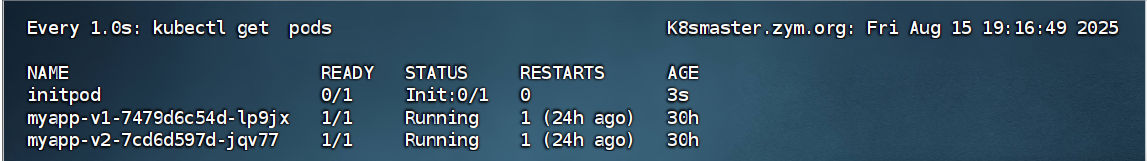

3.1.2 INIT 容器示例

[root@k8s-master ~]# vim pod.yml

apiVersion: v1

kind: Pod

metadata:labels:name: initpodname: initpod

spec:containers:- image: myapp:v1name: myappinitContainers:- name: init-myserviceimage: busyboxcommand: ["sh","-c","until test -e /testfile;do echo wating for myservice; sleep 2;done"] #检测/testfile下的test文件是否存在#测试

[root@k8s-master ~]# kubectl apply -f pod.yml

pod/initpod created

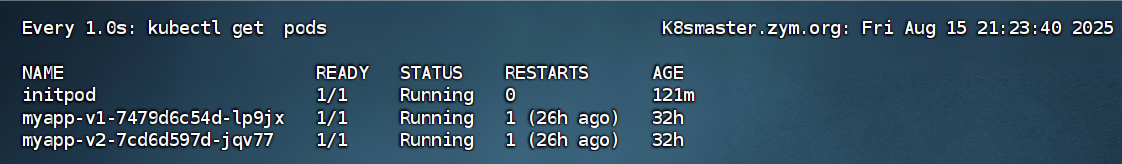

[root@k8s-master ~]# kubectl get pods

显示init容器正在运行中,因为该容器中没有目标文件,会处于该状态

#每两秒刷新启动

[root@k8s-master ~]# kubectl logs pods/initpod init-myservice

wating for myservice

wating for myservice

wating for myservice

wating for myservice

wating for myservice

wating for myservice#添加所需的目标文件

[root@k8s-master ~]# kubectl exec pods/initpod -c init-myservice -- /bin/sh -c "touch /testfile"[root@k8s-master ~]# kubectl get pods NAME READY STATUS RESTARTS AGE

initpod 1/1 Running 0 62s

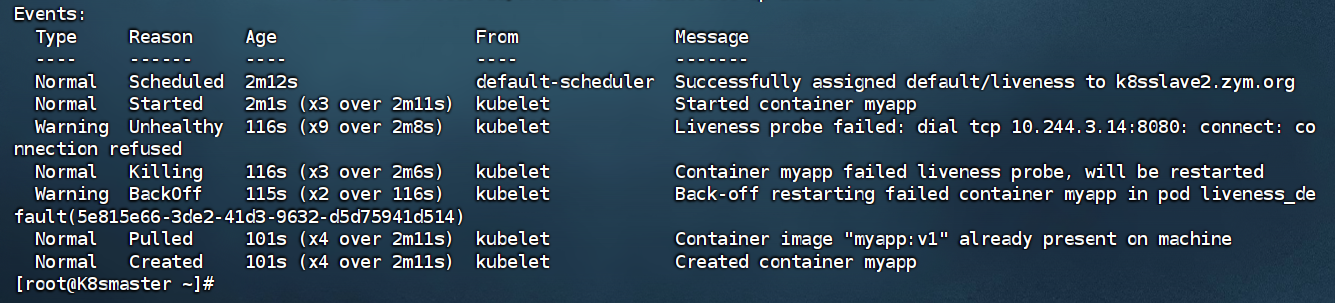

3.2 三种探针

选择执行在容器上运行的三种探针执行

-

存活探针–livenessProbe:会持续检测该容器是否正常运行,启动不了的话,会把之前启动的给删了,然后受到重启策略影响,重新开一个新的容器

如果容器不设定存活探针话,会默认状态为success

-

就绪探针–readinessProbe:容器是否准备好服务请求,就绪探测失败,端点控制器将从与 Pod 匹配的所有 Service 的端点中删除该 Pod 的 IP 地址。初始延迟之前的就绪状态默认为失败

-

启动探针–startupProbe:容器中的应用是否已经启动,提供了启动探测(startup probe),则禁用所有其他探测,直到它成功为止;启动探测失败的话,会将容器删除,重新启动容器

ReadinessProbe 与 LivenessProbe 的区别

- 当检测失败后,将 Pod 的

IP:Port从对应的 EndPoint 列表中删除 - 当检测失败后,将杀死容器并根据

Pod 的重启策略来决定作出对应的措施

StartupProbe 与 ReadinessProbe、LivenessProbe 的区别

- 当三个探针同时存在,

先执行 StartupProbe 探针,其他两个探针将会被暂时禁用,直到 pod满足启动探针配置的条件,其他 2 个探针启动;不满足按照规则重启容器。 - 另外两种探针在容器启动后,会按照配置,直到容器消亡才停止探测,而 StartupProbe 探针只是在容器启动后按照配置满足一次后,不在进行后续的探测。

3.2.1 探针示例

[root@k8s-master ~]# vim pod.yml

apiVersion: v1

kind: Pod

metadata:labels:name: livenessname: liveness

spec:containers:- image: myapp:v1name: myapplivenessProbe:tcpSocket: #检测端口存在性port: 8080initialDelaySeconds: 3 #容器启动后要等待多少秒后就探针开始工作,默认是 0speriodSeconds: 1 #执行探测的时间间隔,默认为 10stimeoutSeconds: 1 #探针执行检测请求后,等待响应的超时时间,默认为 1s#测试:

[root@k8s-master ~]# kubectl apply -f pod.yml

pod/liveness created

[root@k8s-master ~]# kubectl get pods

NAME READY STATUS RESTARTS AGE

liveness 0/1 CrashLoopBackOff 2 (7s ago) 22s[root@k8s-master ~]# kubectl describe pods

可以看到因为无法连接该8080端口,在持续的删除重启

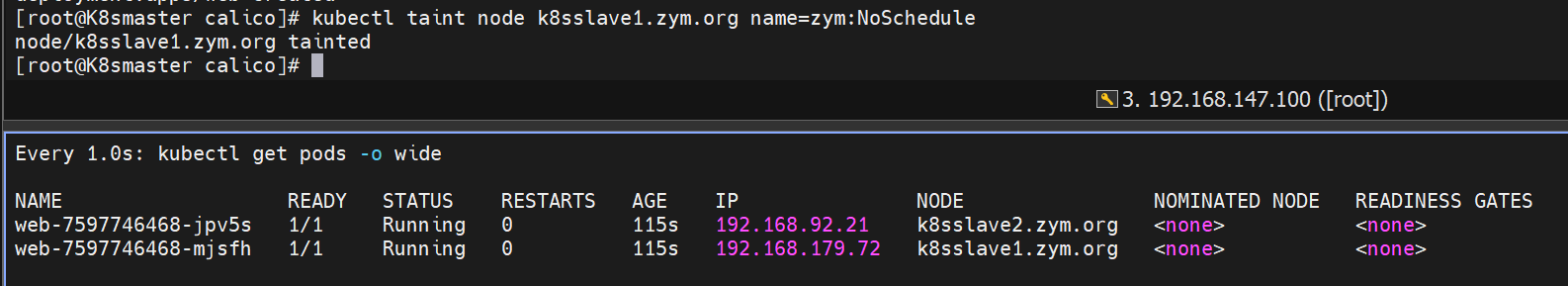

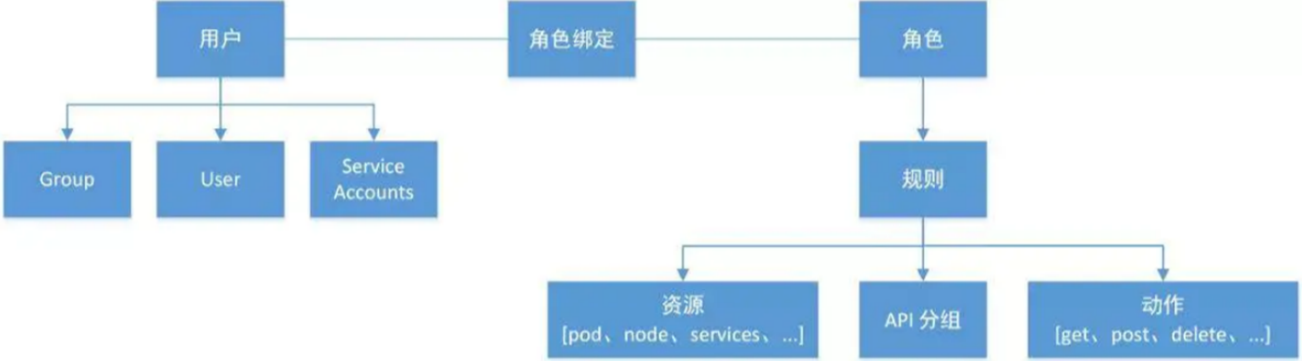

四、k8s中的控制器

(一)控制器的说明

控制器是管理pod的一种手段

- 自主Pod—pod退出或意外关闭后不会被重新创建

- 控制器管理的Pod—在控制器的生命周期里,始终维持 Pod 的副本数目

Pod控制器是管理pod的中间层,使用Pod控制器之后,只需要告诉Pod控制器,想要多少个什么样的Pod就可以了,它会创建出满足条件的Pod并确保每一个Pod资源处于用户期望的目标状态。如果Pod资源在运行中出现故障,它会基于指定策略重新编排Pod

当建立控制器后,会把期望值写入etcd,k8s中的apiserver检索etcd中我们保存的期望状态,并对比pod的当前状态,如果出现差异代码自驱动立即恢复

(二)常用控制器的类型

| 控制器名称 | 控制器用途 |

|---|---|

| ReplicaSet | ReplicaSet 确保任何时间都有指定数量的 Pod 副本在运行 |

| Deployment | 一个 Deployment 为 Pod 和 ReplicaSet 提供声明式的更新能力 |

| DaemonSet | DaemonSet 确保全指定节点上运行一个 Pod 的副本 |

| StatefulSet | StatefulSet 是用来管理有状态应用的工作负载 API 对象。 |

| Job | 执行批处理任务,仅执行一次任务,保证任务的一个或多个Pod成功结束 |

| CronJob | Cron Job 创建基于时间调度的 Jobs。 |

| HPA全称Horizontal Pod Autoscaler | 根据资源利用率自动调整service中Pod数量,实现Pod水平自动缩放 |

(三)replicaset控制器

replicaset功能

- ReplicaSet 确保任何时间都有指定数量的 Pod 副本在运行

- 协助Deployments 用作协调 Pod 创建、删除和更新的机制

replicaset解释

apiVersion: apps/v1

kind: ReplicaSet

metadata:name: replicaset #指定pod名称,一定小写,如果出现大写报错

spec:replicas: 2 #指定维护pod数量为2selector: #指定检测匹配方式matchLabels: #指定匹配方式为匹配标签app: myapp #指定匹配的标签为app=myapptemplate: #模板,当副本数量不足时,会根据下面的模板创建pod副本metadata:labels:app: myappspec:containers:- image: myapp:v1name: myapp

replicaset 示例

创建测试容器

#生成yml文件

[root@k8s-master ~]# kubectl create deployment replicaset --image myapp:v1 --dry-run=client -o yaml > replicaset.yml[root@k8s-master ~]# vim replicaset.yml

apiVersion: apps/v1

kind: ReplicaSet

metadata:name: replicaset #指定pod名称,一定小写,如果出现大写报错

spec:replicas: 2 #指定维护pod数量为2selector: #指定检测匹配方式matchLabels: #指定匹配方式为匹配标签app: myapp #指定匹配的标签为app=myapptemplate: #模板,当副本数量不足时,会根据下面的模板创建pod副本metadata:labels:app: myappspec:containers:- image: myapp:v1name: myapp[root@k8s-master ~]# kubectl apply -f replicaset.yml

replicaset.apps/replicaset created

测试:通过标签匹配pod,标签不同,会重新启动一个标签相同的容器

[root@k8s-master ~]# kubectl label pod replicaset-l4xnr app=timinglee --overwrite

pod/replicaset-l4xnr labeled

[root@k8s-master ~]# kubectl get pods --show-labels

NAME READY STATUS RESTARTS AGE LABELS

replicaset-gd5fh 1/1 Running 0 2s app=myapp #会开启新的pod

replicaset-l4xnr 1/1 Running 0 3m19s app=timinglee

replicaset-t2s5p 1/1 Running 0 3m19s app=myapp

测试:控制容器的数量

#删除其中一个pod,会自动重新生成新的pod,保证数量

[root@k8s-master ~]# kubectl delete pods replicaset-t2s5p

pod "replicaset-t2s5p" deleted[root@k8s-master ~]# kubectl get pods --show-labels

NAME READY STATUS RESTARTS AGE LABELS

replicaset-l4xnr 1/1 Running 0 5m43s app=myapp

replicaset-nxmr9 1/1 Running 0 15s app=myapp

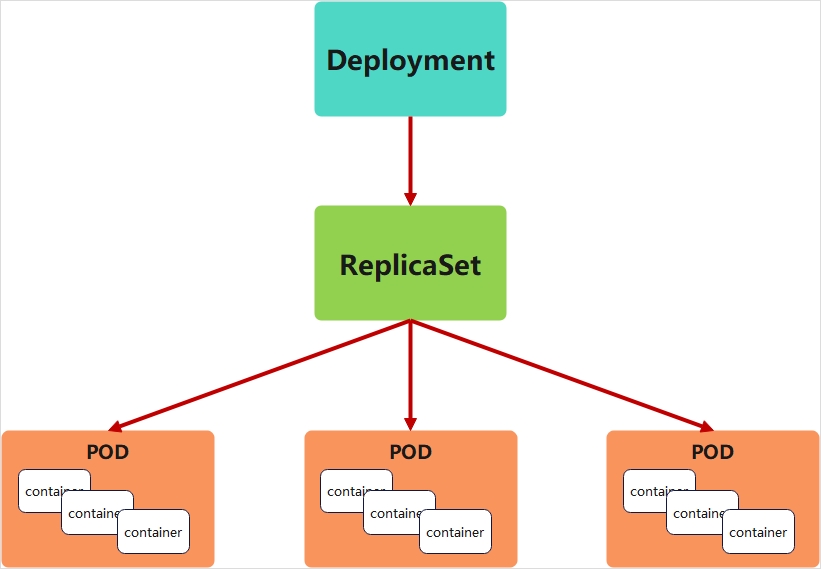

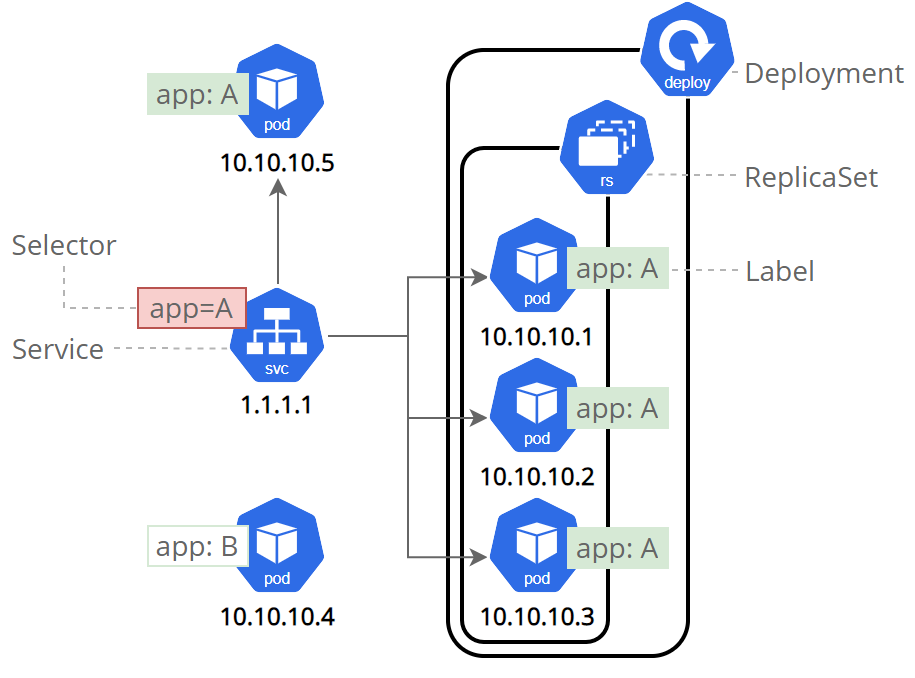

(四)deployment 控制器

4.1 deployment控制器说明

- Deployment控制器并不直接管理pod,而是通过管理ReplicaSet来间接管理Pod

- Deployment管理ReplicaSet,ReplicaSet管理Pod

- Deployment 为 Pod 和 ReplicaSet 提供了一个申明式的定义方法

- 在Deployment中ReplicaSet相当于一个版本

典型的应用场景:

- 用来创建Pod和ReplicaSet

- 滚动更新和回滚

- 扩容和缩容

- 暂停与恢复

pod控制器—deployment

kubectl create deployment webcluster --imagge myapp:v1 - replicas 4#deployment---为实时和系统进行命令的对比,查看是否符合命令操作

#replicas---为期望,设定期望pod开启的数量为4个

4.2 deployment控制器示例

#生成yaml文件

[root@k8s-master ~]# kubectl create deployment deployment --image myapp:v1 --dry-run=client -o yaml > deployment.yml[root@k8s-master ~]# vim deployment.yml

apiVersion: apps/v1

kind: Deployment

metadata:name: deployment

spec:replicas: 4selector:matchLabels:app: myapptemplate:metadata:labels:app: myappspec:containers:- image: myapp:v1name: myapp

#建立pod

root@k8s-master ~]# kubectl apply -f deployment.yml

deployment.apps/deployment created#查看pod信息

[root@k8s-master ~]# kubectl get pods --show-labels

NAME READY STATUS RESTARTS AGE LABELS

deployment-5d886954d4-2ckqw 1/1 Running 0 23s app=myapp,pod-template-hash=5d886954d4

deployment-5d886954d4-m8gpd 1/1 Running 0 23s app=myapp,pod-template-hash=5d886954d4

deployment-5d886954d4-s7pws 1/1 Running 0 23s app=myapp,pod-template-hash=5d886954d4

deployment-5d886954d4-wqnvv 1/1 Running 0 23s app=myapp,pod-template-hash=5d886954d4

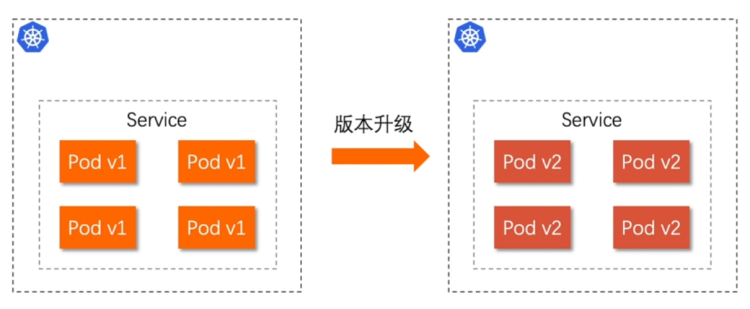

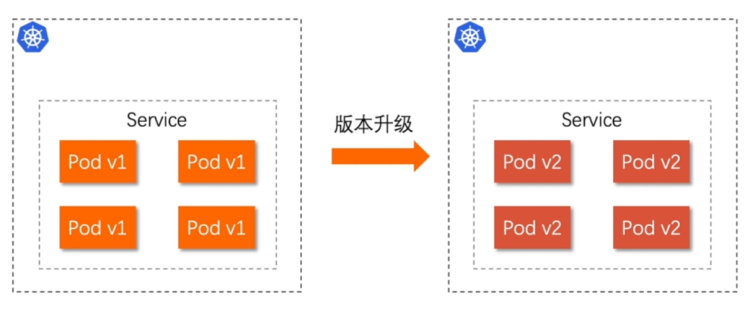

4.2.1 版本迭代

[root@k8s-master ~]# kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

deployment-5d886954d4-2ckqw 1/1 Running 0 2m40s 10.244.2.14 k8s-node2 <none> <none>

deployment-5d886954d4-m8gpd 1/1 Running 0 2m40s 10.244.1.17 k8s-node1 <none> <none>

deployment-5d886954d4-s7pws 1/1 Running 0 2m40s 10.244.1.16 k8s-node1 <none> <none>

deployment-5d886954d4-wqnvv 1/1 Running 0 2m40s 10.244.2.15 k8s-node2 <none> <none>#pod运行容器版本为v1

[root@k8s-master ~]# curl 10.244.2.14

Hello MyApp | Version: v1 | <a href="hostname.html">Pod Name</a>[root@k8s-master ~]# kubectl describe deployments.apps deployment

Name: deployment

Namespace: default

CreationTimestamp: Sun, 01 Sep 2024 23:19:10 +0800

Labels: <none>

Annotations: deployment.kubernetes.io/revision: 1

Selector: app=myapp

Replicas: 4 desired | 4 updated | 4 total | 4 available | 0 unavailable

StrategyType: RollingUpdate

MinReadySeconds: 0

RollingUpdateStrategy: 25% max unavailable, 25% max surge #默认每次更新25%#更新容器运行版本

[root@k8s-master ~]# vim deployment.yml

apiVersion: apps/v1

kind: Deployment

metadata:name: deployment

spec:minReadySeconds: 5 #最小就绪时间5秒replicas: 4selector:matchLabels:app: myapptemplate:metadata:labels:app: myappspec:containers:- image: myapp:v2 #更新为版本2name: myapp[root@k8s2 pod]# kubectl apply -f deployment-example.yaml#更新过程

[root@k8s-master ~]# watch - n1 kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE

deployment-5d886954d4-8kb28 1/1 Running 0 48s

deployment-5d886954d4-8s4h8 1/1 Running 0 49s

deployment-5d886954d4-rclkp 1/1 Running 0 50s

deployment-5d886954d4-tt2hz 1/1 Running 0 50s

deployment-7f4786db9c-g796x 0/1 Pending 0 0s#测试更新效果

[root@k8s-master ~]# kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

deployment-7f4786db9c-967fk 1/1 Running 0 10s 10.244.1.26 k8s-node1 <none> <none>

deployment-7f4786db9c-cvb9k 1/1 Running 0 10s 10.244.2.24 k8s-node2 <none> <none>

deployment-7f4786db9c-kgss4 1/1 Running 0 9s 10.244.1.27 k8s-node1 <none> <none>

deployment-7f4786db9c-qts8c 1/1 Running 0 9s 10.244.2.25 k8s-node2 <none> <none>[root@k8s-master ~]# curl 10.244.1.26

Hello MyApp | Version: v2 | <a href="hostname.html">Pod Name</a>

[!NOTE]

更新的过程是重新建立一个版本的RS,新版本的RS会把pod 重建,然后把老版本的RS回收

4.2.2 版本回滚

[root@k8s-master ~]# vim deployment.yml

apiVersion: apps/v1

kind: Deployment

metadata:name: deployment

spec:replicas: 4selector:matchLabels:app: myapptemplate:metadata:labels:app: myappspec:containers:- image: myapp:v1 #回滚到之前版本name: myapp[root@k8s-master ~]# kubectl apply -f deployment.yml

deployment.apps/deployment configured#测试回滚效果

[root@k8s-master ~]# kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

deployment-5d886954d4-dr74h 1/1 Running 0 8s 10.244.2.26 k8s-node2 <none> <none>

deployment-5d886954d4-thpf9 1/1 Running 0 7s 10.244.1.29 k8s-node1 <none> <none>

deployment-5d886954d4-vmwl9 1/1 Running 0 8s 10.244.1.28 k8s-node1 <none> <none>

deployment-5d886954d4-wprpd 1/1 Running 0 6s 10.244.2.27 k8s-node2 <none> <none>[root@k8s-master ~]# curl 10.244.2.26

Hello MyApp | Version: v1 | <a href="hostname.html">Pod Name</a>

4.2.3 滚动更新策略

[root@k8s-master ~]# vim deployment.yml

apiVersion: apps/v1

kind: Deployment

metadata:name: deployment

spec:minReadySeconds: 5 #最小就绪时间,指定pod每隔多久更新一次replicas: 4strategy: #指定更新策略rollingUpdate:maxSurge: 1 #比定义pod数量多几个maxUnavailable: 0 #比定义pod个数少几个selector:matchLabels:app: myapptemplate:metadata:labels:app: myappspec:containers:- image: myapp:v1name: myapp

[root@k8s2 pod]# kubectl apply -f deployment-example.yaml

4.2.4 暂停及恢复

在实际生产环境中我们做的变更可能不止一处,当修改了一处后,如果执行变更就直接触发了

我们期望的触发时当我们把所有修改都搞定后一次触发

暂停,避免触发不必要的线上更新

[root@k8s2 pod]# kubectl rollout pause deployment deployment-example[root@k8s2 pod]# vim deployment-example.yaml

apiVersion: apps/v1

kind: Deployment

metadata:name: deployment-example

spec:minReadySeconds: 5strategy:rollingUpdate:maxSurge: 1maxUnavailable: 0replicas: 6 selector:matchLabels:app: myapptemplate:metadata:labels:app: myappspec:containers:- name: myappimage: nginxresources:limits:cpu: 0.5memory: 200Mirequests:cpu: 0.5memory: 200Mi[root@k8s2 pod]# kubectl apply -f deployment-example.yaml#调整副本数,不受影响

[root@k8s-master ~]# kubectl describe pods deployment-7f4786db9c-8jw22

Name: deployment-7f4786db9c-8jw22

Namespace: default

Priority: 0

Service Account: default

Node: k8s-node1/172.25.254.10

Start Time: Mon, 02 Sep 2024 00:27:20 +0800

Labels: app=myapppod-template-hash=7f4786db9c

Annotations: <none>

Status: Running

IP: 10.244.1.31

IPs:IP: 10.244.1.31

Controlled By: ReplicaSet/deployment-7f4786db9c

Containers:myapp:Container ID: docker://01ad7216e0a8c2674bf17adcc9b071e9bfb951eb294cafa2b8482bb8b4940c1dImage: myapp:v2Image ID: docker-pullable://myapp@sha256:5f4afc8302ade316fc47c99ee1d41f8ba94dbe7e3e7747dd87215a15429b9102Port: <none>Host Port: <none>State: RunningStarted: Mon, 02 Sep 2024 00:27:21 +0800Ready: TrueRestart Count: 0Environment: <none>Mounts:/var/run/secrets/kubernetes.io/serviceaccount from kube-api-access-mfjjp (ro)

Conditions:Type StatusPodReadyToStartContainers TrueInitialized TrueReady TrueContainersReady TruePodScheduled True

Volumes:kube-api-access-mfjjp:Type: Projected (a volume that contains injected data from multiple sources)TokenExpirationSeconds: 3607ConfigMapName: kube-root-ca.crtConfigMapOptional: <nil>DownwardAPI: true

QoS Class: BestEffort

Node-Selectors: <none>

Tolerations: node.kubernetes.io/not-ready:NoExecute op=Exists for 300snode.kubernetes.io/unreachable:NoExecute op=Exists for 300s

Events:Type Reason Age From Message---- ------ ---- ---- -------Normal Scheduled 6m22s default-scheduler Successfully assigned default/deployment-7f4786db9c-8jw22 to k8s-node1Normal Pulled 6m22s kubelet Container image "myapp:v2" already present on machineNormal Created 6m21s kubelet Created container myappNormal Started 6m21s kubelet Started container myapp#但是更新镜像和修改资源并没有触发更新

[root@k8s2 pod]# kubectl rollout history deployment deployment-example

deployment.apps/deployment-example

REVISION CHANGE-CAUSE

3 <none>

4 <none>#恢复后开始触发更新

[root@k8s2 pod]# kubectl rollout resume deployment deployment-example[root@k8s2 pod]# kubectl rollout history deployment deployment-example

deployment.apps/deployment-example

REVISION CHANGE-CAUSE

3 <none>

4 <none>

5 <none>#回收

[root@k8s2 pod]# kubectl delete -f deployment-example.yaml

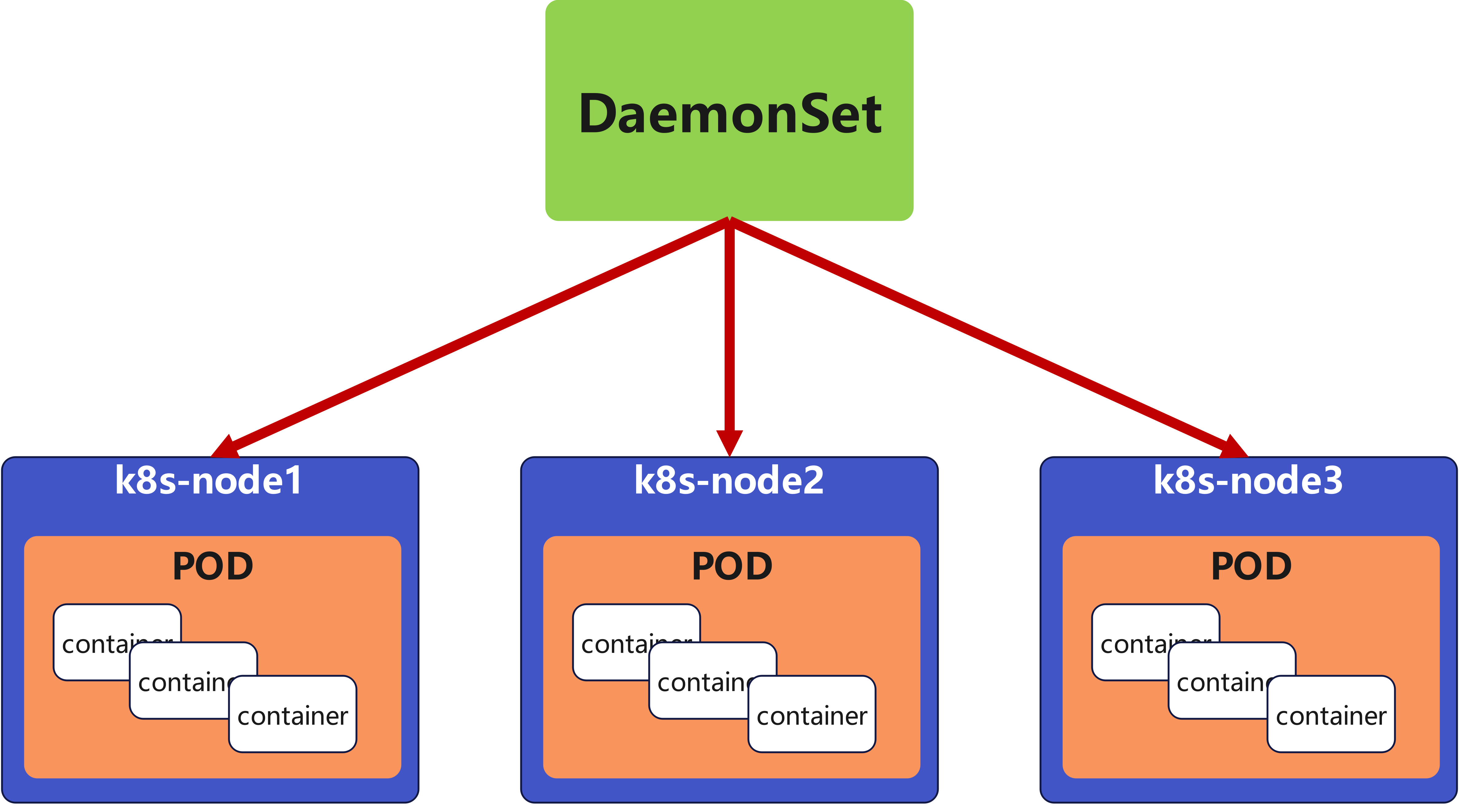

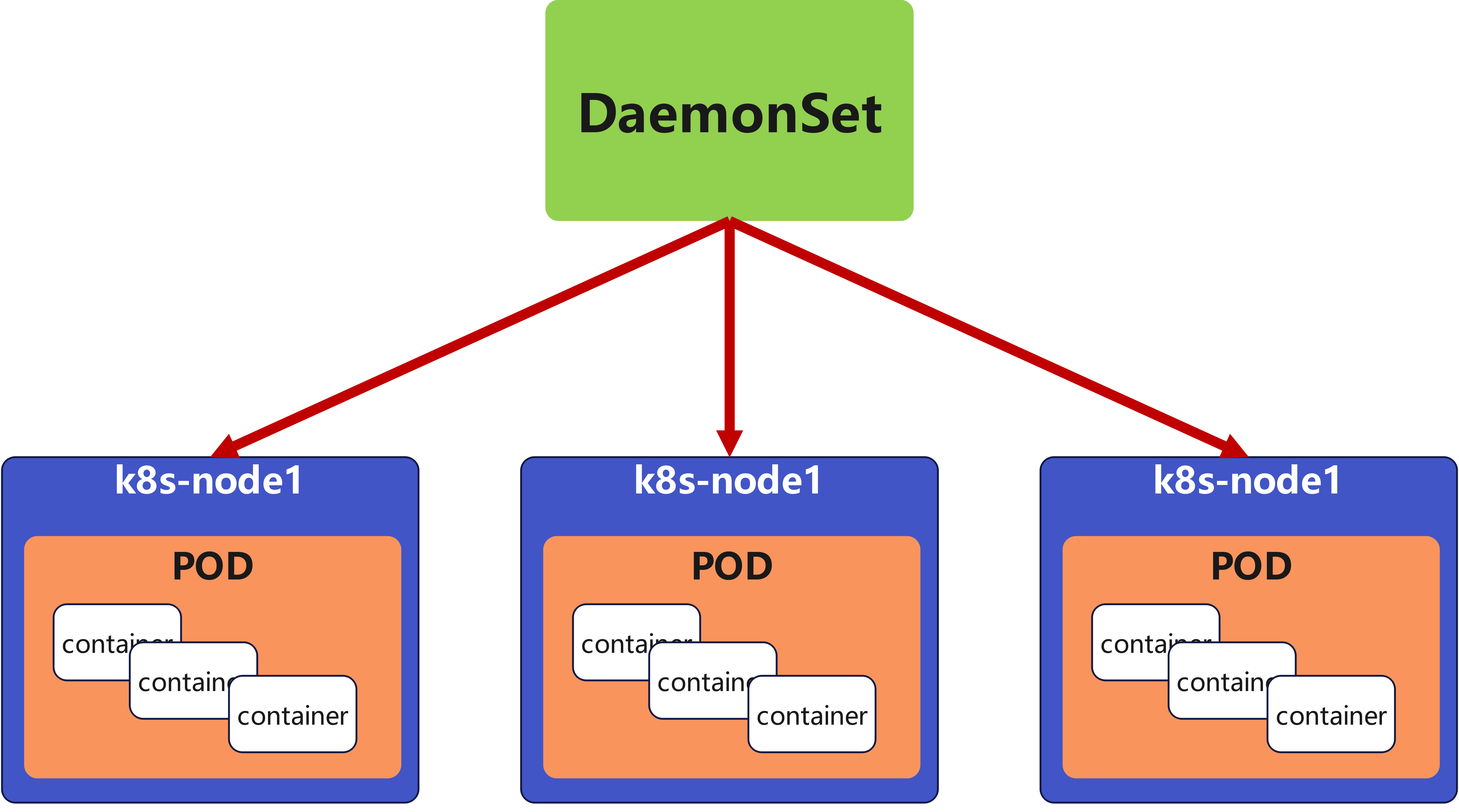

(五) daemonset控制器

5.1 daemonset功能

DaemonSet 确保全部(或者某些)节点上运行一个 Pod 的副本。当有节点加入集群时, 也会为他们新增一个 Pod ,当有节点从集群移除时,这些 Pod 也会被回收。删除 DaemonSet 将会删除它创建的所有 Pod

DaemonSet 的典型用法:

- 在每个节点上运行集群存储 DaemonSet,例如 glusterd、ceph。

- 在每个节点上运行日志收集 DaemonSet,例如 fluentd、logstash。

- 在每个节点上运行监控 DaemonSet,例如 Prometheus Node Exporter、zabbix agent等

- 一个简单的用法是在所有的节点上都启动一个 DaemonSet,将被作为每种类型的 daemon 使用

- 一个稍微复杂的用法是单独对每种 daemon 类型使用多个 DaemonSet,但具有不同的标志, 并且对不同硬件类型具有不同的内存、CPU 要求

5.2 daemonset 示例

[root@k8s2 pod]# cat daemonset-example.yml

apiVersion: apps/v1

kind: DaemonSet

metadata:name: daemonset-example

spec:selector:matchLabels:app: nginxtemplate:metadata:labels:app: nginxspec:tolerations: #对于污点节点的容忍- effect: NoScheduleoperator: Existscontainers:- name: nginximage: nginx[root@k8s-master ~]# kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

daemonset-87h6s 1/1 Running 0 47s 10.244.0.8 k8s-master <none> <none>

daemonset-n4vs4 1/1 Running 0 47s 10.244.2.38 k8s-node2 <none> <none>

daemonset-vhxmq 1/1 Running 0 47s 10.244.1.40 k8s-node1 <none> <none>#回收

[root@k8s2 pod]# kubectl delete -f daemonset-example.yml

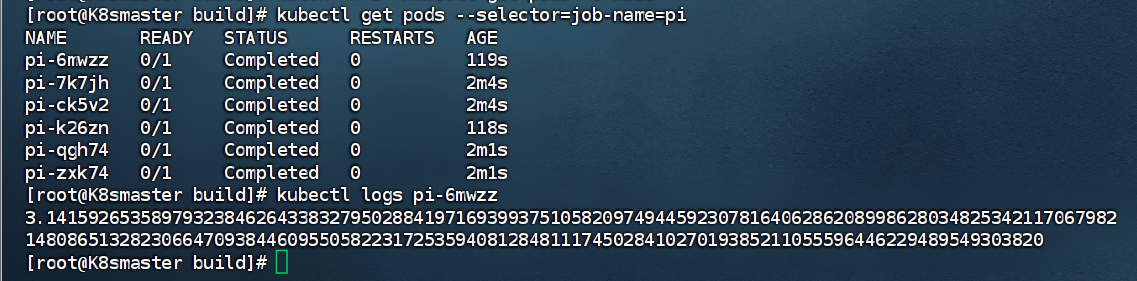

(六)job 控制器

6.1 job控制器说明

- 可以进行批量处理的短暂一次运行

[root@k8s2 pod]# vim job.yml

apiVersion: batch/v1

kind: Job

metadata:name: pi

spec:completions: 6 #一共完成任务数为6 parallelism: 2 #每次并行完成2个backoffLimit: 4 #尝试运行失败4次后重新运行template:spec:containers:- name: piimage: perl:5.34.0command: ["perl", "-Mbignum=bpi", "-wle", "print bpi(2000)"] #计算圆周率3.14的后2000位restartPolicy: Never #关闭后不自动重启[root@k8s2 pod]# kubectl apply -f job.yml#监控

[root@K8smaster ~]# watch -n 1 "kubectl get pods -o wide"

#删除

[root@K8smaster build]# kubectl delete jobs.batch pi

[!NOTE]

关于重启策略**

restartPolicy**设置的说明:

如果指定为OnFailure,则job会在pod出现故障时重启容器

而不是创建pod,failed次数不变

如果指定为Never,则job会在pod出现故障时创建新的pod

并且故障pod不会消失,也不会重启,failed次数加1

如果指定为Always的话,就意味着一直重启,意味着job任务会重复去执行了

结果查看:可以看到状态为completed状态

(七)cronjob控制器

7.1 cronjob说明

- Cron Job 创建基于时间调度的 Jobs

- CronJob控制器以Job控制器资源为其管控对象,并借助它管理pod资源对象

- CronJob可以进行周期性任务作业,控制其运行时间点及重复运行的方式

- CronJob可以在特定的时间点(反复的)去运行job任务

7.2 cronjob示例

[root@k8s2 pod]# vim cronjob.yml

apiVersion: batch/v1

kind: CronJob

metadata:name: hello

spec:schedule: "* * * * *"jobTemplate:spec:template:spec:containers:- name: helloimage: busyboximagePullPolicy: IfNotPresentcommand:- /bin/sh- -c- date; echo Hello from the Kubernetes clusterrestartPolicy: OnFailure #当失败后,重新启动pod,但不记录失败次数[root@k8s2 pod]# kubectl apply -f cronjob.yml

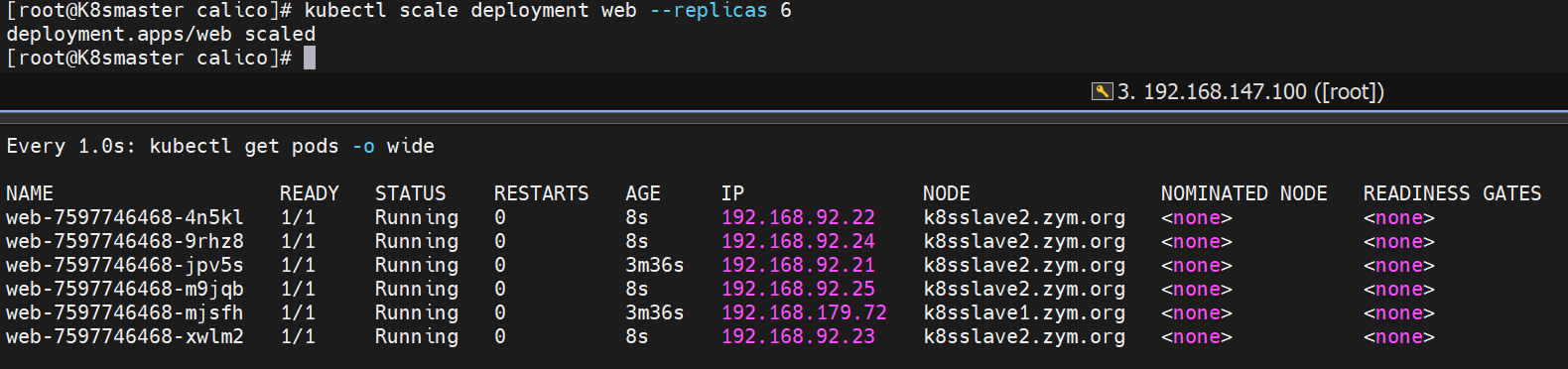

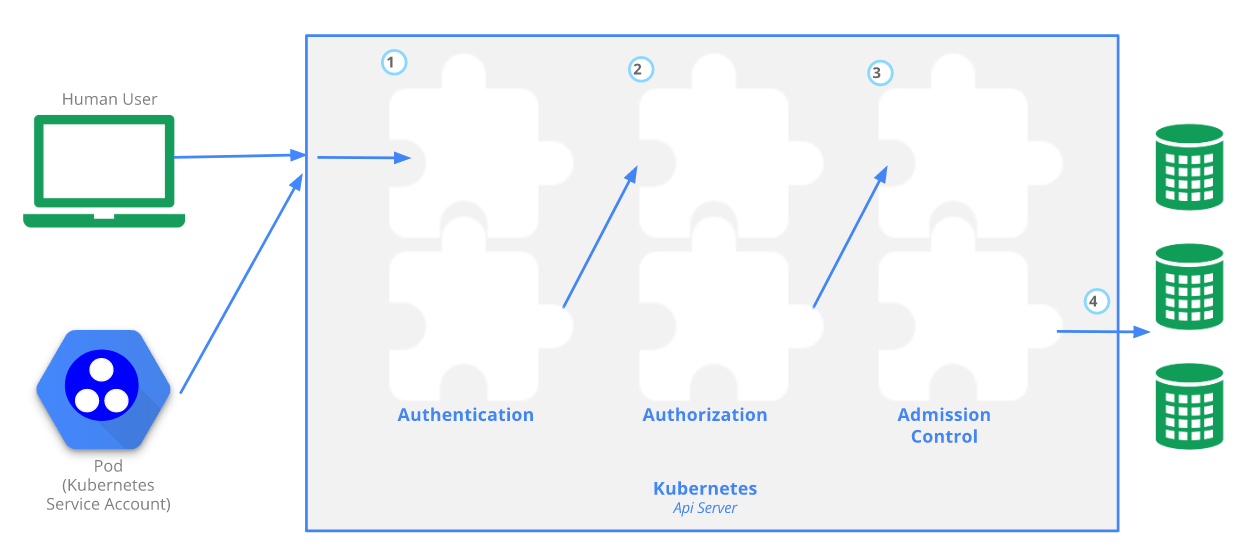

五、微服务

微服务相当于主机中的网卡,实现服务发现

编写配置文件时,需要注意格式,保证配置正常运行

- Service是一组提供相同服务的Pod对外开放的接口

- service默认只支持4层负载均衡能力,没有7层功能(可以通过Ingress实现)

结构图:

(一)微服务的类型

| 微服务类型 | 作用描述 |

|---|---|

| ClusterIP | 默认值,k8s系统给service自动分配的虚拟IP,只能在集群内部访问 |

| NodePort | 将Service通过指定的Node上的端口暴露给外部,访问任意一个NodeIP:nodePort都将路由到ClusterIP |

| LoadBalancer | 在NodePort的基础上,借助cloud provider创建一个外部的负载均衡器,并将请求转发到 NodeIP:NodePort,此模式只能在云服务器上使用 |

| ExternalName | 将服务通过 DNS CNAME 记录方式转发到指定的域名(通过 spec.externlName 进行设定) |

前三个类型都是,集群外部访问到集群内部;另一个是,集群内访问集群外部

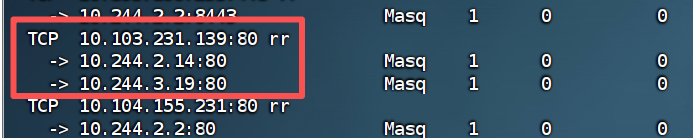

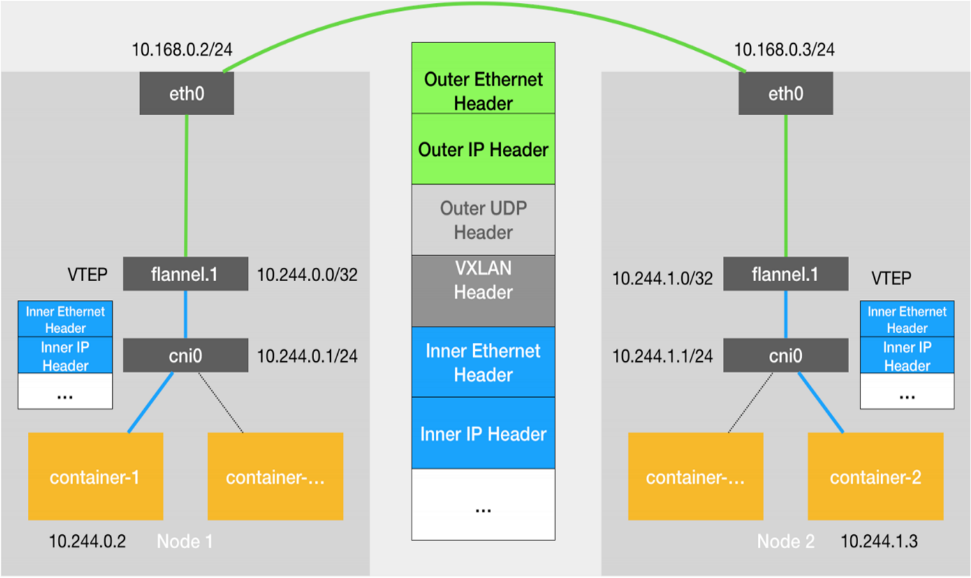

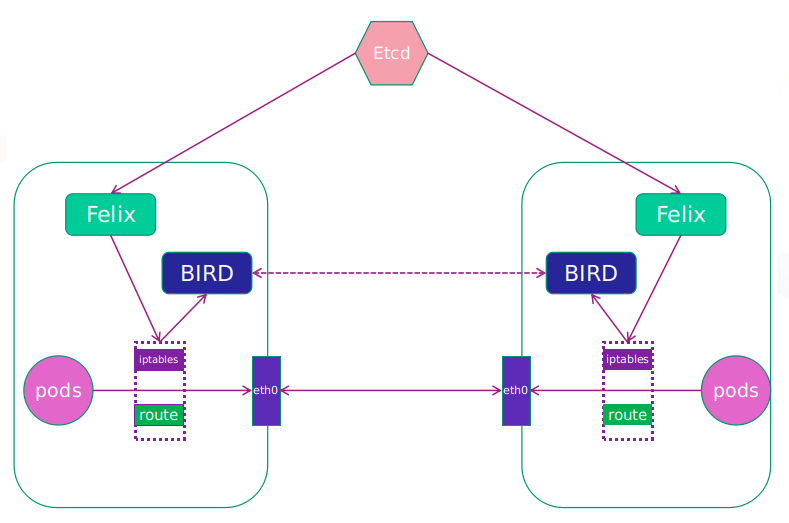

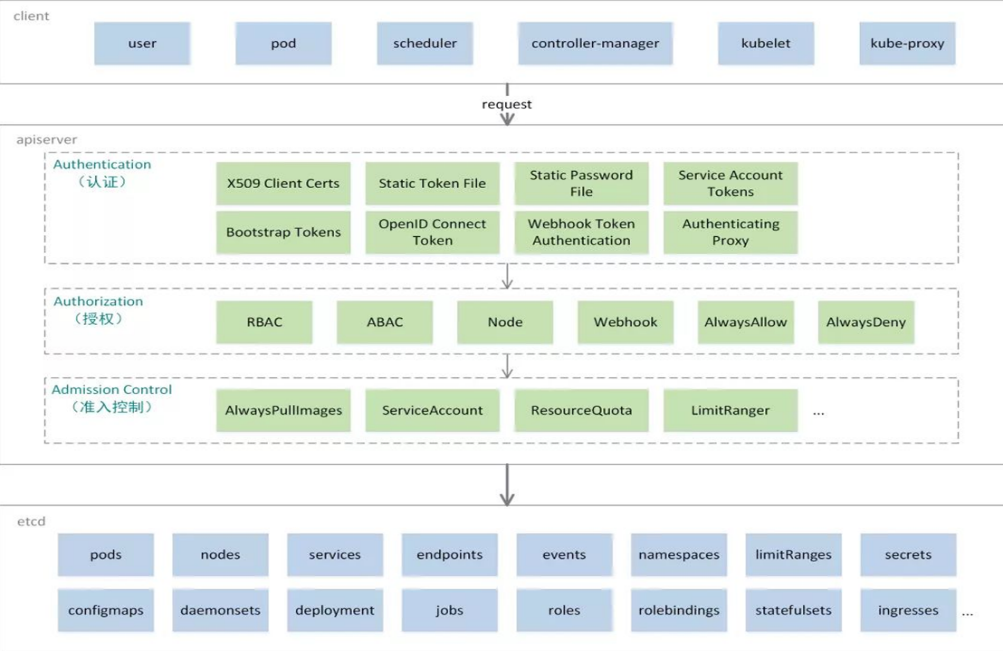

(二)IPVS模式

- Service 是由 kube-proxy 组件,加上 iptables 来共同实现的

- kube-proxy 通过 iptables 处理 Service 的过程,需要在宿主机上设置相当多的 iptables 规则,如果宿主机有大量的Pod,不断刷新iptables规则,会消耗大量的CPU资源

- IPVS模式的service,可以使K8s集群支持更多量级的Pod

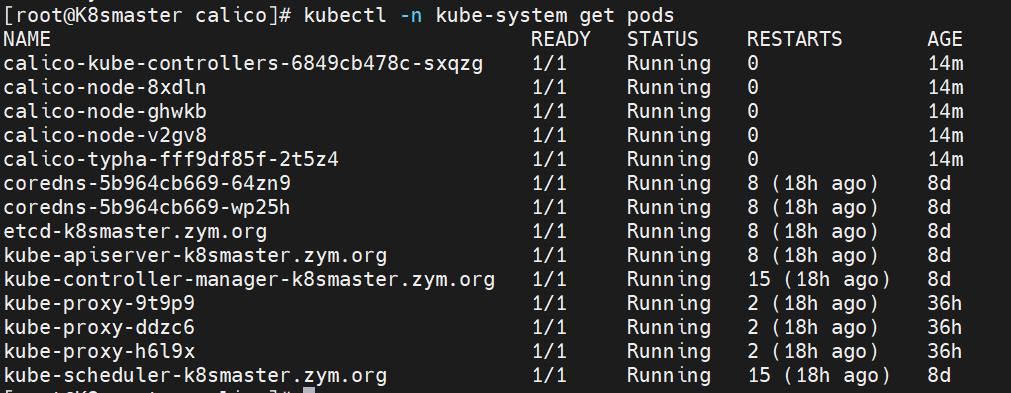

3.1 ipvs模式配置方式

- 在所有节点中安装ipvsadm

[root@k8s-所有节点 pod]dnf install ipvsadm –y

- 修改master节点的代理配置

[root@k8s-master ~]# kubectl -n kube-system edit cm kube-proxymetricsBindAddress: ""mode: "ipvs" #设置kube-proxy使用ipvs模式nftables:

- 配置yml文件

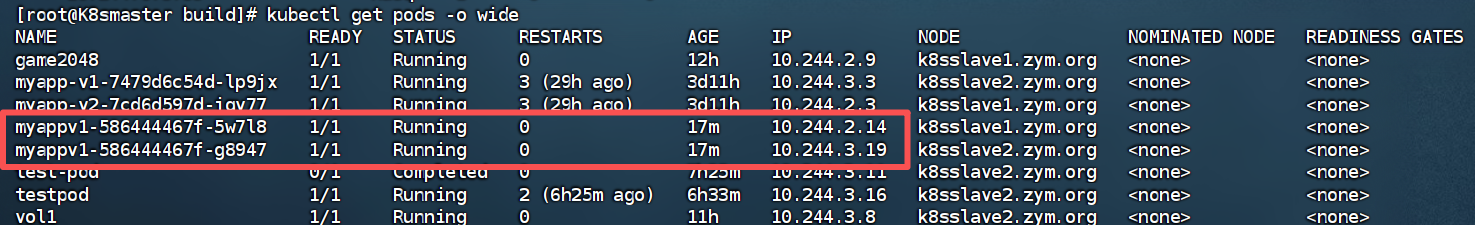

[root@K8smaster build]# vim myappv1.yml

apiVersion: apps/v1

kind: Deployment

metadata:labels:app: myappv1name: myappv1

spec:replicas: 2selector:matchLabels:app: myappv1template:metadata:labels:app: myappv1spec:containers:- image: myapp:v1name: myapp

---

apiVersion: v1

kind: Service

metadata:labels:app: myappv1name: myappv1

spec:ports:- port: 80protocol: TCPtargetPort: 80selector:app: myappv1type: ClusterIP

- 需重启pod,才能生效

[root@k8s-master ~]# kubectl -n kube-system get pods | awk '/kube-proxy/{system("kubectl -n kube-system delete pods "$1)}'[root@k8s-master ~]# ipvsadm -Ln

注意:

当切换ipvs模式后,kube-proxy会在宿主机上添加一个虚拟网卡:kube-ipvs0,并分配所有service IP

(三)微服务类型详情

3.1 ClusterIP

- 用于在集群的内部暴露控制器的,在集群内访问,并对集群内的pod提供健康检测和自动发现功能

对于微服务的域名解析

#service创建后集群DNS提供解析[root@K8smaster build]# dig myappv1.default.svc.cluster.local @10.96.0.10; <<>> DiG 9.16.23-RH <<>> myappv1.default.svc.cluster.local @10.96.0.10

;; global options: +cmd

;; Got answer:

;; WARNING: .local is reserved for Multicast DNS

;; You are currently testing what happens when an mDNS query is leaked to DNS

;; ->>HEADER<<- opcode: QUERY, status: NOERROR, id: 28306

;; flags: qr aa rd; QUERY: 1, ANSWER: 1, AUTHORITY: 0, ADDITIONAL: 1

;; WARNING: recursion requested but not available;; OPT PSEUDOSECTION:

; EDNS: version: 0, flags:; udp: 4096

; COOKIE: fa143f2b1d9b817f (echoed)

;; QUESTION SECTION:

;myappv1.default.svc.cluster.local. IN A;; ANSWER SECTION:

myappv1.default.svc.cluster.local. 30 IN A 10.103.231.139;; Query time: 0 msec

;; SERVER: 10.96.0.10#53(10.96.0.10)

;; WHEN: Mon Aug 18 00:03:33 CST 2025

;; MSG SIZE rcvd: 123

3.2 ClusterIP中的特殊模式headless

headless(无头服务)

对于无头 Services 并不会分配 Cluster IP,kube-proxy不会处理它们, 而且平台也不会为它们进行负载均衡和路由,集群访问通过dns解析直接指向到业务pod上的IP,所有的调度由 dns 单独完成

[root@K8smaster build]# vim myappv1.yml

---

apiVersion: v1

kind: Service

metadata:labels:app: myappv1name: myappv1

spec:ports:- port: 80protocol: TCPtargetPort: 80selector:app: myappv1type: ClusterIPclusterIP: "None" #添加此代码

进行域名的解析可以看到

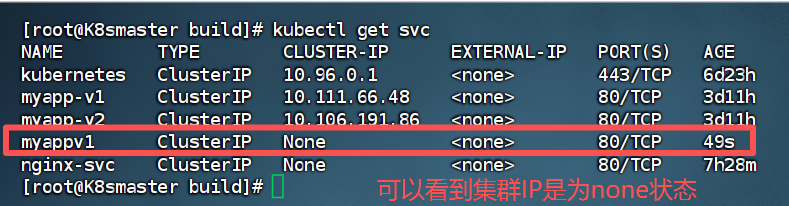

3.3 nodeport

通过ipvs暴漏端口从而使外部主机通过master节点的对外ip,来访问pod业务

- 其访问过程为:

---

apiVersion: v1

kind: Service

metadata:labels:app: myappv1name: myappv1

spec:ports:- port: 80protocol: TCPtargetPort: 80selector:app: myappv1type: NodePoort #改为NodePort模式

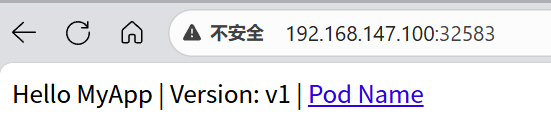

可以看到会生成一个对外的访问端口—32583

[root@K8smaster build]# kubectl get service myappv1

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

myappv1 NodePort 10.104.59.217 <none> 80:32583/TCP 22s

通过访问主机的IP+端口就可以访问到pod上

!注意

nodeport默认端口

nodeport默认端口是30000-32767,超出会报错

3.3.1 端口的固定优化

---

apiVersion: v1

kind: Service

metadata:labels:app: myappv1name: myappv1

spec:ports:- port: 80protocol: TCPtargetPort: 80nodePort: 36666 #设置固定的对外端口selector:app: myappv1type: NodePoort

如果需要使用这个范围以外的端口就需要特殊设定

root@k8s-master ~]# vim /etc/kubernetes/manifests/kube-apiserver.yaml- --service-node-port-range=30000-40000

[!NOTE]

添加“–service-node-port-range=“ 参数,端口范围可以自定义

修改后api-server会自动重启,等apiserver正常启动后才能操作集群

集群重启自动完成在修改完参数后全程不需要人为干预

3.4 loadbalancer

云平台会为我们分配vip并实现访问,如果是裸金属主机那么需要metallb来实现ip的分配

[root@k8s-master ~]# vim myappv1.yaml---

apiVersion: v1

kind: Service

metadata:labels:app: myappv1name: myappv1

spec:ports:- port: 80protocol: TCPtargetPort: 80selector:app: myappv1type: LoadBalancer[root@k8s2 service]# kubectl apply -f myappv1.yml默认无法分配外部访问IP

[root@k8s2 service]# kubectl get svc

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kubernetes ClusterIP 10.96.0.1 <none> 443/TCP 4d1h

myappv1 LoadBalancer 10.107.23.134 <pending> 80:32537/TCP 4s

LoadBalancer模式适用云平台,裸金属环境需要安装metallb提供支持

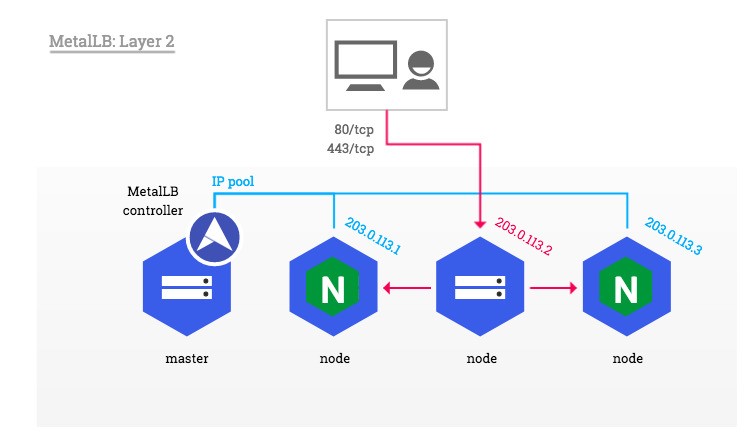

3.5 metalLB

相当于网络中的DHCP,为LoadBalancer分配vip

官网:https://metallb.universe.tf/installation/

部署方式

1.设置ipvs模式

[root@k8s-master ~]# kubectl edit cm -n kube-system kube-proxy

apiVersion: kubeproxy.config.k8s.io/v1alpha1

kind: KubeProxyConfiguration

mode: "ipvs"

ipvs:strictARP: true[root@k8s-master ~]# kubectl -n kube-system get pods | awk '/kube-proxy/{system("kubectl -n kube-system delete pods "$1)}'2.下载部署文件

[root@k8s2 metallb]# wget https://raw.githubusercontent.com/metallb/metallb/v0.13.12/config/manifests/metallb-native.yaml3.修改文件中镜像地址,与harbor仓库路径保持一致

[root@k8s-master ~]# vim metallb-native.yaml

...

image: metallb/controller:v0.14.8

image: metallb/speaker:v0.14.84.上传镜像到harbor

[root@k8s-master ~]# docker pull quay.io/metallb/controller:v0.14.8

[root@k8s-master ~]# docker pull quay.io/metallb/speaker:v0.14.8[root@k8s-master ~]# docker tag quay.io/metallb/speaker:v0.14.8 reg.timinglee.org/metallb/speaker:v0.14.8

[root@k8s-master ~]# docker tag quay.io/metallb/controller:v0.14.8 reg.timinglee.org/metallb/controller:v0.14.8[root@k8s-master ~]# docker push reg.timinglee.org/metallb/speaker:v0.14.8

[root@k8s-master ~]# docker push reg.timinglee.org/metallb/controller:v0.14.8部署服务

[root@k8s2 metallb]# kubectl apply -f metallb-native.yaml

[root@k8s-master ~]# kubectl -n metallb-system get pods

NAME READY STATUS RESTARTS AGE

controller-65957f77c8-25nrw 1/1 Running 0 30s

speaker-p94xq 1/1 Running 0 29s

speaker-qmpct 1/1 Running 0 29s

speaker-xh4zh 1/1 Running 0 30s配置分配地址段

[root@k8s-master ~]# vim configmap.yml

apiVersion: metallb.io/v1beta1

kind: IPAddressPool

metadata:name: first-pool #地址池名称namespace: metallb-system

spec:addresses:- 172.25.254.50-172.25.254.99 #修改为自己本地地址段--- #两个不同的kind中间必须加分割

apiVersion: metallb.io/v1beta1

kind: L2Advertisement

metadata:name: examplenamespace: metallb-system

spec:ipAddressPools:- first-pool #使用地址池 [root@k8s-master ~]# kubectl apply -f configmap.yml

ipaddresspool.metallb.io/first-pool created

l2advertisement.metallb.io/example created[root@k8s-master ~]# kubectl get services

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kubernetes ClusterIP 10.96.0.1 <none> 443/TCP 21h

timinglee-service LoadBalancer 10.109.36.123 172.25.254.50 80:31595/TCP 9m9s#通过分配地址从集群外访问服务

[root@reg ~]# curl 172.25.254.50

Hello MyApp | Version: v1 | <a href="hostname.html">Pod Name</a>4.6 externalname

- 开启services后,不会被分配IP,而是用dns解析CNAME固定域名来解决ip变化问题

- 一般应用于外部业务和pod沟通或外部业务迁移到pod内时

- 在应用向集群迁移过程中,externalname在过度阶段就可以起作用了。

- 集群外的资源迁移到集群时,在迁移的过程中ip可能会变化,但是域名+dns解析能完美解决此问题

示例:

[root@k8s-master ~]# vim timinglee.yaml

---

apiVersion: v1

kind: Service

metadata:labels:app: timinglee-servicename: timinglee-service

spec:selector:app: timingleetype: ExternalNameexternalName: www.timinglee.org[root@k8s-master ~]# kubectl apply -f timinglee.yaml[root@k8s-master ~]# kubectl get services timinglee-service

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

timinglee-service ExternalName <none> www.timinglee.org <none> 2m58s#测试:

[root@master service]# kubectl run test --image busyboxplus -it

If you don't see a command prompt, try pressing enter./# ping [root@master service]# kubectl run test --image busyboxplus -it

If you don't see a command prompt, try pressing enter./# ping ext-service.default.svc.cluster.local

PING ext-service.default.svc.cluster.local (103.235.46.115): 56 data bytes64 bytes from 103.235.46.115:seq=0 tt1=127 time=331.212 ms

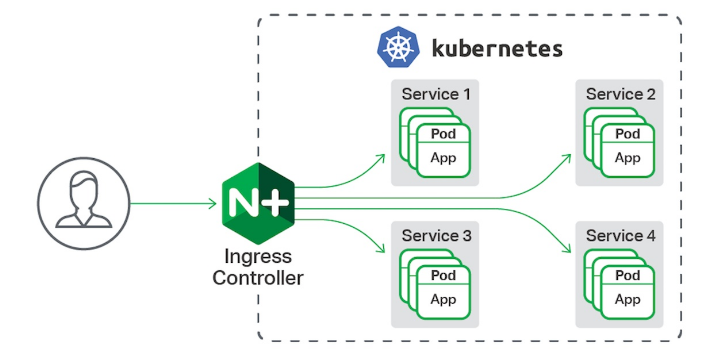

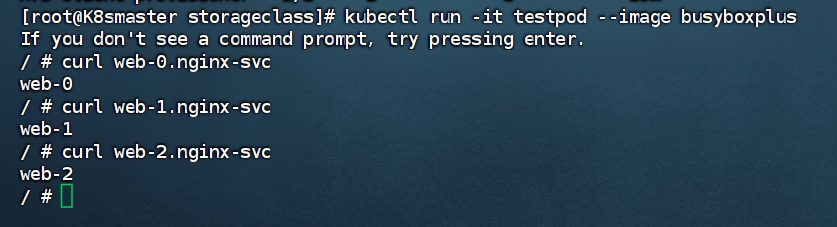

(五)ingress-nginx

5.1 部署ingress

ingress-nginx功能

- 一种全局的、为了代理不同后端 Service 而设置的负载均衡服务,支持7层

- Ingress由两部分组成:Ingress controller和Ingress服务

- Ingress Controller 会根据你定义的 Ingress 对象,提供对应的代理能力

- 业界常用的各种反向代理项目,比如 Nginx、HAProxy、Envoy、Traefik 等,都已经为Kubernetes 专门维护了对应的 Ingress Controller

5.1.1 下载部署文件

在Harbor中创建项目ingress-nginx

#在Harbor仓库上传所需镜像

docker tag registry.k8s.io/ingress-nginx/controller:v1.13.1 reg.zym.org/ingress-nginx/controller:v1.13.1docker tag registry.k8s.io/ingress-nginx/kube-webhook-certgen:v1.6.1 reg.zym.org/ingress-nginx/kube-webhook-certgen:v1.6.1docker push reg.zym.org/ingress-nginx/kube-webhook-certgen:v1.6.1

docker push reg.zym.org/ingress-nginx/controller:v1.13.1

5.1.2 安装ingress

[root@k8s-master ~]# vim deploy.yaml

image: ingress-nginx/controller:v1.13.1

image: ingress-nginx/kube-webhook-certgen:v1.6.1

image: ingress-nginx/kube-webhook-certgen:v1.6.1[root@k8s-master ~]# kubectl -n ingress-nginx get pods

NAME READY STATUS RESTARTS AGE

ingress-nginx-admission-create-ggqm6 0/1 Completed 0 82s

ingress-nginx-admission-patch-q4wp2 0/1 Completed 0 82s

ingress-nginx-controller-7bf698f798-bkxq2 1/1 Running 0 82s[root@K8smaster build]# kubectl -n ingress-nginx get svc

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

ingress-nginx-controller LoadBalancer 10.104.155.231 172.25.254.50 80:31247/TCP,443:31269/TCP 4h33m

ingress-nginx-controller-admission ClusterIP 10.103.168.235 <none> 443/TCP

提示:

EXTERNAL-IP为对外开放的ip地址

5.1.3 测试ingress

#生成yaml文件

[root@k8s-master ~]# kubectl create ingress webcluster --rule '*/=timinglee-svc:80' --dry-run=client -o yaml > timinglee-ingress.yml

kubectl create ingress

- create表示创建资源,ingress指定要创建的资源类型是 Ingress

webcluster

- 创建的 Ingress 资源的名称,它在所属的命名空间内必须是唯一

--rule '*/=timinglee-svc:80'

-

–rule:参数用于定义 Ingress 的路由规则

*/=timinglee-svc:80表示: -

*:匹配所有的主机名

-

/:匹配所有的 URL 路径,即所有的 HTTP 请求路径都会被这个规则处理

timinglee-svc

- 指定后端要转发流量的 Service 名称

--dry-run=client

- 该参数表示以客户端模拟运行的方式执行命令,不会真正在集群中创建 Ingress 资源,仅在本地对命令进行语法检查,并按照命令执行后的结果生成相应的数据结构

-o yaml

- -o是–output的缩写,用于指定输出格式,yaml表示将命令执行后的结果以 YAML 格式输出

timinglee-ingress.yml

- 这是将命令输出的 YAML 内容重定向到名为timinglee-ingress.yml的文件中,后续可以通过编辑该文件,对 Ingress 配置进行调整

[root@k8s-master ~]# vim timinglee-ingress.yml

aapiVersion: networking.k8s.io/v1

kind: Ingress

metadata:name: test-ingress

spec:ingressClassName: nginxrules:- http:paths:- backend:service:name: timinglee-svcport:number: 80path: /pathType: Prefix #Exact(精确匹配),ImplementationSpecific(特定实现),Prefix(前缀匹配),Regular expression(正则表达式匹配)

#建立ingress控制器

[root@k8s-master ~]# kubectl apply -f timinglee-ingress.yml

ingress.networking.k8s.io/webserver created[root@k8s-master ~]# kubectl get ingress

NAME CLASS HOSTS ADDRESS PORTS AGE

test-ingress nginx * 172.25.254.10 80 8m30s

5.2 ingress高级用法

5.2.1 基于路径进行访问

A. 测试配置yaml编写

[root@k8s-master app]# kubectl create deployment myapp-v1 --image myapp:v1 --dry-run=client -o yaml > myapp-v1.yaml[root@k8s-master app]# kubectl create deployment myapp-v2 --image myapp:v2 --dry-run=client -o yaml > myapp-v2.yaml[root@k8s-master app]# vim myapp-v1.yaml

apiVersion: apps/v1

kind: Deployment

metadata:labels:app: myapp-v1name: myapp-v1

spec:replicas: 1selector:matchLabels:app: myapp-v1strategy: {}template:metadata:labels:app: myapp-v1spec:containers:- image: myapp:v1name: myapp---apiVersion: v1

kind: Service

metadata:labels:app: myapp-v1name: myapp-v1

spec:ports:- port: 80protocol: TCPtargetPort: 80selector:app: myapp-v1[root@k8s-master app]# vim myapp-v2.yaml

apiVersion: apps/v1

kind: Deployment

metadata:labels:app: myapp-v2name: myapp-v2

spec:replicas: 1selector:matchLabels:app: myapp-v2template:metadata:labels:app: myapp-v2spec:containers:- image: myapp:v2name: myapp

---

apiVersion: v1

kind: Service

metadata:labels:app: myapp-v2name: myapp-v2

spec:ports:- port: 80protocol: TCPtargetPort: 80selector:app: myapp-v2

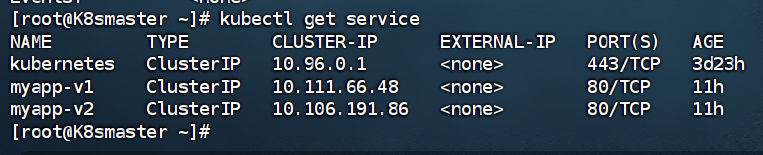

#将端口写到容器内

[root@k8s-master app]# kubectl expose deployment myapp-v1 --port 80 --target-port 80 --dry-run=client -o yaml >> myapp-v1.yaml[root@k8s-master app]# kubectl expose deployment myapp-v2 --port 80 --target-port 80 --dry-run=client -o yaml >> myapp-v1.yaml

查看services

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kubernetes ClusterIP 10.96.0.1 <none> 443/TCP 3d23h

myapp-v1 ClusterIP 10.111.66.48 <none> 80/TCP 11h

myapp-v2 ClusterIP 10.106.191.86 <none> 80/TCP 11h

B. 编写建立ingress的yaml文件

#vim ingress1.yml

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:annotations:nginx.ingress.kubernetes.io/rewrite-target: /name: ingress1

spec:ingressClassName: nginxrules:- host: www.timinglee.orghttp:paths:- backend:service:name: myapp-v1port:number: 80path: /v1pathType: Prefix- backend:service:name: myapp-v2port:number: 80path: /v2pathType: Prefix

C. 效果测试:

#测试:

[root@reg ~]# echo 172.25.254.50 www.timinglee.org >> /etc/hosts[root@reg ~]# curl www.timinglee.org/v1

Hello MyApp | Version: v1 | <a href="hostname.html">Pod Name</a>

[root@reg ~]# curl www.timinglee.org/v2

Hello MyApp | Version: v2 | <a href="hostname.html">Pod Name</a>#nginx.ingress.kubernetes.io/rewrite-target: / 功能实现

[root@reg ~]# curl www.timinglee.org/v2/aaaa

Hello MyApp | Version: v2 | <a href="hostname.html">Pod Name</a>

5.2.4 建立auth认证

#建立认证文件

[root@k8s-master app]# dnf install httpd-tools -y

[root@k8s-master app]# htpasswd -cm auth lee

New password:

Re-type new password:

Adding password for user lee

[root@k8s-master app]# cat auth

lee:$apr1$BohBRkkI$hZzRDfpdtNzue98bFgcU10#建立认证类型资源

[root@k8s-master app]# kubectl create secret generic auth-web --from-file auth

root@k8s-master app]# kubectl describe secrets auth-web

Name: auth-web

Namespace: default

Labels: <none>

Annotations: <none>Type: OpaqueData

====

auth: 42 bytes

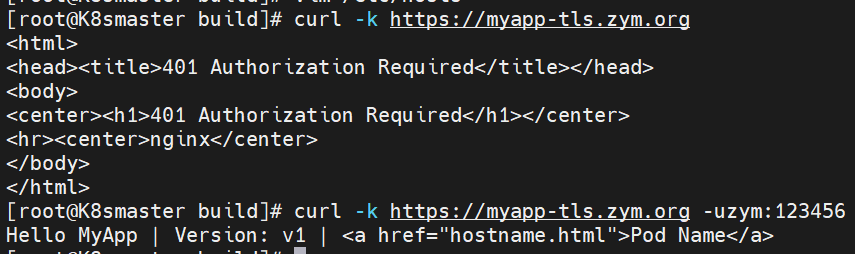

#建立ingress4基于用户认证的yaml文件

[root@k8s-master app]# vim ingress4.yml

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:annotations:nginx.ingress.kubernetes.io/auth-type: basicnginx.ingress.kubernetes.io/auth-secret: auth-webnginx.ingress.kubernetes.io/auth-realm: "Please input username and password"name: ingress4

spec:tls:- hosts:- myapp-tls.timinglee.orgsecretName: web-tls-secretingressClassName: nginxrules:- host: myapp-tls.timinglee.orghttp:paths:- backend:service:name: myapp-v1port:number: 80path: /pathType: Prefix#建立ingress4

[root@k8s-master app]# kubectl apply -f ingress4.yml

ingress.networking.k8s.io/ingress4 created

[root@k8s-master app]# kubectl describe ingress ingress4

Name: ingress4

Labels: <none>

Namespace: default

Address:

Ingress Class: nginx

Default backend: <default>

TLS:web-tls-secret terminates myapp-tls.timinglee.org

Rules:Host Path Backends---- ---- --------myapp-tls.timinglee.org/ myapp-v1:80 (10.244.2.31:80)

Annotations: nginx.ingress.kubernetes.io/auth-realm: Please input username and passwordnginx.ingress.kubernetes.io/auth-secret: auth-webnginx.ingress.kubernetes.io/auth-type: basic

Events:Type Reason Age From Message---- ------ ---- ---- -------Normal Sync 14s nginx-ingress-controller Scheduled for sync

结果测试:测试前需要解析主机名

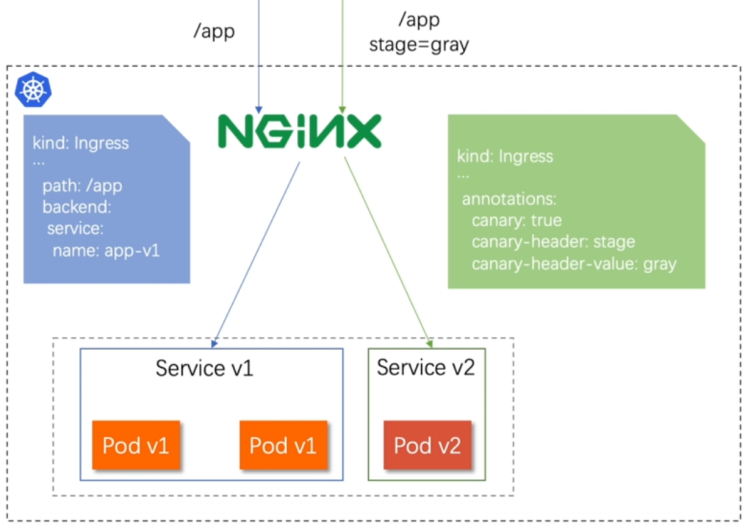

(六)Canary金丝雀发布

6.1 金丝雀发布介绍

金丝雀发布(Canary Release)也称为灰度发布,是一种软件发布策略。

主要目的是在将新版本的软件全面推广到生产环境之前,先在一小部分用户或服务器上进行测试和验证,以降低因新版本引入重大问题而对整个系统造成的影响。

是一种Pod的发布方式。金丝雀发布采取先添加、再删除的方式,保证Pod的总量不低于期望值。并且在更新部分Pod后,暂停更新,当确认新Pod版本运行正常后再进行其他版本的Pod的更新。

6.2 Canary发布方式

其中header和weiht中的最多

6.2.1 基于header(http包头)灰度

- 通过Annotaion扩展

- 创建灰度ingress,配置灰度头部key以及value

- 灰度流量验证完毕后,切换正式ingress到新版本

- 之前我们在做升级时可以通过控制器做滚动更新,默认25%利用header可以使升级更为平滑,通过key 和vule 测试新的业务体系是否有问题。

配置示例:

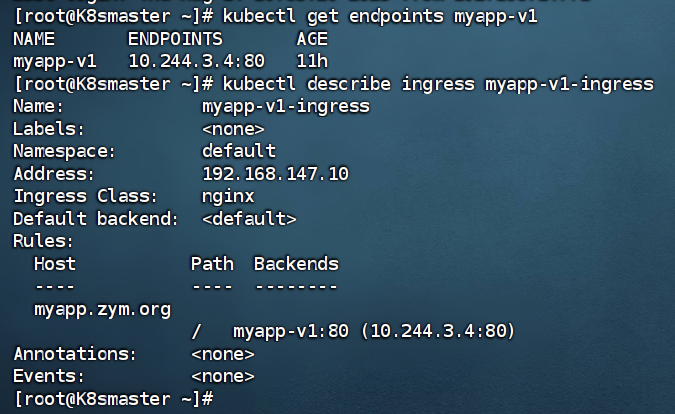

#建立版本1的ingress

[root@k8s-master app]# vim ingress7.yml

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:annotations:name: myapp-v1-ingress

spec:ingressClassName: nginxrules:- host: myapp.zym.orghttp:paths:- backend:service:name: myapp-v1port:number: 80path: /pathType: Prefix[root@k8s-master app]# kubectl apply -f ingress7.yml

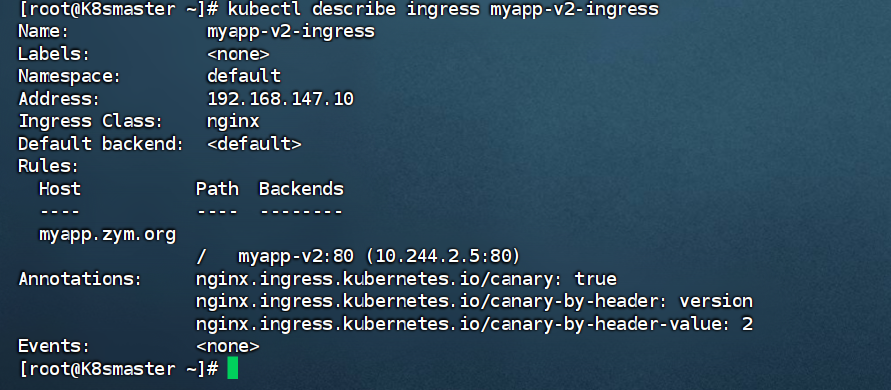

如图配置查看

#建立基于版本2的ingress

[root@k8s-master app]# vim ingress8.yml

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:annotations:nginx.ingress.kubernetes.io/canary: "true"nginx.ingress.kubernetes.io/canary-by-header: versionnginx.ingress.kubernetes.io/canary-by-header-value: "2"name: myapp-v2-ingress

spec:ingressClassName: nginxrules:- host: myapp.zym.orghttp:paths:- backend:service:name: myapp-v2port:number: 80path: /pathType: Prefix[root@k8s-master app]# kubectl apply -f ingress8.yml

ingress.networking.k8s.io/myapp-v2-ingress created

#测试:

[root@K8smaster build]# curl myapp.zym.org

Hello MyApp | Version: v1 | <a href="hostname.html">Pod Name</a>

[root@K8smaster build]# curl -H "version: 2" myapp.zym.org

Hello MyApp | Version: v2 | <a href="hostname.html">Pod Name</a>

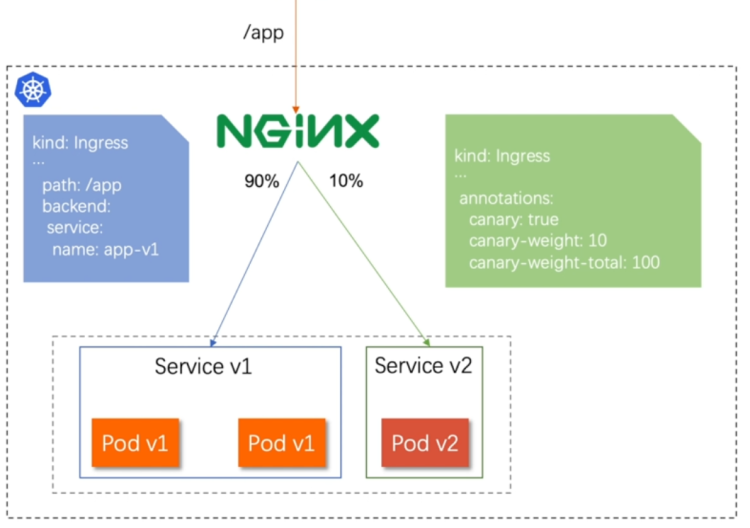

6.2.2 基于权重的灰度发布

- 通过Annotaion拓展

- 创建灰度ingress,配置灰度权重以及总权重

- 灰度流量验证完毕后,切换正式ingress到新版本

配置示例

#基于权重的灰度发布

[root@k8s-master app]# vim ingress8.yml

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:annotations:nginx.ingress.kubernetes.io/canary: "true"nginx.ingress.kubernetes.io/canary-weight: "10" #更改权重值nginx.ingress.kubernetes.io/canary-weight-total: "100"name: myapp-v2-ingress

spec:ingressClassName: nginxrules:- host: myapp.timinglee.orghttp:paths:- backend:service:name: myapp-v2port:number: 80path: /pathType: Prefix[root@k8s-master app]# kubectl apply -f ingress8.yml

ingress.networking.k8s.io/myapp-v2-ingress created#测试:

[root@reg ~]# vim check_ingress.sh

#!/bin/bash

v1=0

v2=0for (( i=0; i<100; i++))

doresponse=`curl -s myapp.timinglee.org |grep -c v1`v1=`expr $v1 + $response`v2=`expr $v2 + 1 - $response`done

echo "v1:$v1, v2:$v2"[root@reg ~]# sh check_ingress.sh

v1:90, v2:10#更改完毕权重后继续测试可观察变化

六、K8s储存管理

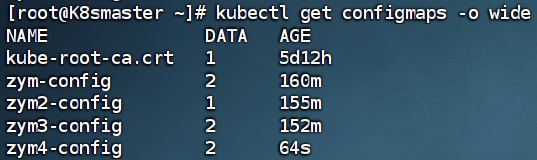

(一)configmap

1.1 configmap的功能

用于存储非敏感的配置数据,以键值对的形式存在,使得应用程序可以在不修改镜像的情况下读取不同的配置信息,进行pod的配置

- configMap用于保存配置数据,以键值对形式存储

- configMap 资源提供了向 Pod 注入配置数据的方法

- 镜像和配置文件解耦,以便实现镜像的可移植性和可复用性

- etcd限制了文件大小不能超过1M

1.2 configmap的使用场景

- 填充环境变量的值

- 设置容器内的命令行参数

- 填充卷的配置文件

1.3 configmap创建方式

1.3.1 字面值的创建

[root@K8smaster ~]# kubectl create cm zym-config --from-literal fname=liubailiushiliu --from-literal name=zym

configmap/zym-config created

[root@K8smaster ~]# kubectl describe cm zym-config

Name: zym-config

Namespace: default

Labels: <none>

Annotations: <none>Data

====

fname:

----

liubailiushiliu

name:

----

zymBinaryData

====Events: <none>

1.3.2 通过文件创建

[root@K8smaster ~]# kubectl create cm zym2-config --from-file /etc/resolv.conf

configmap/zym2-config created

[root@K8smaster ~]# kubectl describe cm zym2-config

Name: zym2-config

Namespace: default

Labels: <none>

Annotations: <none>Data

====

resolv.conf:

----

# Generated by NetworkManager

search zym.org

nameserver 8.8.8.8BinaryData

====Events: <none>

1.3.3 通过目录创建

[root@K8smaster ~]# kubectl create cm zym3-config --from-file zymconfig/

configmap/zym3-config created

[root@K8smaster ~]# kubectl describe cm zym3-config

Name: zym3-config

Namespace: default

Labels: <none>

Annotations: <none>Data

====

fstab:

----#

# /etc/fstab

# Created by anaconda on Fri Jul 11 02:10:59 2025

#

# Accessible filesystems, by reference, are maintained under '/dev/disk/'.

# See man pages fstab(5), findfs(8), mount(8) and/or blkid(8) for more info.

#

# After editing this file, run 'systemctl daemon-reload' to update systemd

# units generated from this file.

#

UUID=c37e3bfa-0b77-4e9a-9b23-880e9bd2dfab / xfs defaults 0 0

UUID=c2a71f8f-02fb-407f-94f0-91e81b201c49 /boot xfs defaults 0 0

#UUID=1d85bab1-7292-44e0-8c9f-cc996a24a9a2 none swap defaults 0 0rc.local:

----

#!/bin/bash

# THIS FILE IS ADDED FOR COMPATIBILITY PURPOSES

#

# It is highly advisable to create own systemd services or udev rules

# to run scripts during boot instead of using this file.

#

# In contrast to previous versions due to parallel execution during boot

# this script will NOT be run after all other services.

#

# Please note that you must run 'chmod +x /etc/rc.d/rc.local' to ensure

# that this script will be executed during boot.touch /var/lock/subsys/local

mount /dev/cdrom /rhel9/

mount /dev/cdrom /rhel9/BinaryData

====Events: <none>

1.3.4 通过yaml文件创建

[root@K8smaster ~]# kubectl create cm zym4-config --from-literal db_host=192.168.147.100 --from-literal db_port=3306 --dry-run=client -o yaml > zym-config.yamlapiVersion: v1

data:db_host: 192.168.147.100db_port: "3306"

kind: ConfigMap

metadata:name: zym4-config#生成configmap

[root@K8smaster ~]# kubectl apply -f zym-config.yaml

[root@K8smaster ~]# kubectl describe cm zym4-config

Name: zym4-config

Namespace: default

Labels: <none>

Annotations: <none>Data

====

db_host:

----

192.168.147.100

db_port:

----

3306BinaryData

====Events: <none>

1.4 configmap使用方式

- 通过环境变量的方式直接传递,挂载到pod中

- 通过pod的命令行运行方式

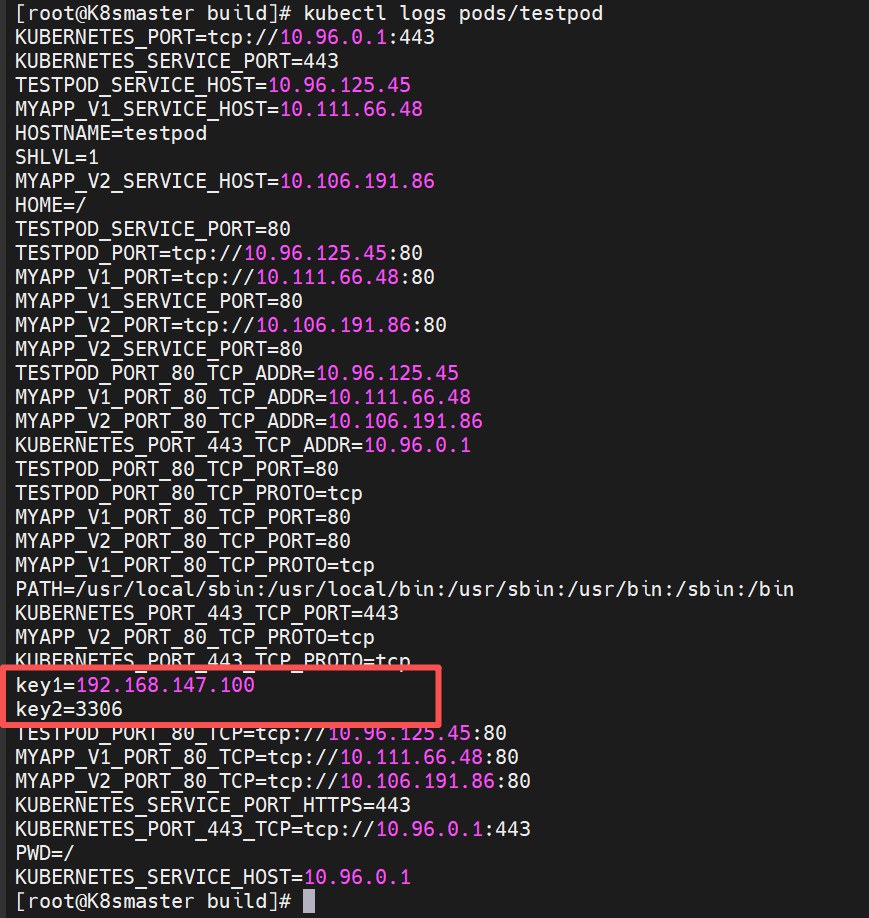

1.4.1 使用configmap填充环境变量

注意:Kubectl apply只能在正在运行中的pod进行打补丁

#把cm中的内容映射为指定变量

[root@k8s-master ~]# vim testpod1.yml

apiVersion: v1

kind: Pod

metadata:labels:run: testpodname: testpod

spec:containers:- image: busyboxplus:latestname: testpodcommand:- /bin/sh- -c- envenv:- name: key1valueFrom:configMapKeyRef:name: zym4-configkey: db_host- name: key2valueFrom:configMapKeyRef:name: zym4-configkey: db_portrestartPolicy: Never[root@k8s-master ~]# kubectl apply -f testpod.yml

pod/testpod created

#把cm中的值直接映射为变量

[root@k8s-master ~]# vim testpod2.yml

apiVersion: v1

kind: Pod

metadata:labels:run: testpodname: testpod

spec:containers:- image: busyboxplus:latestname: testpodcommand:- /bin/sh- -c- envenvFrom:- configMapRef:name: lee4-configrestartPolicy: Never#查看日志

[root@k8s-master ~]# kubectl logs pods/testpod

#在pod命令行中使用变量

[root@k8s-master ~]# vim testpod3.yml

apiVersion: v1

kind: Pod

metadata:labels:run: testpodname: testpod

spec:containers:- image: busyboxplus:latestname: testpodcommand:- /bin/sh- -c- echo ${db_host} ${db_port} #变量调用需envFrom:- configMapRef:name: lee4-configrestartPolicy: Never#查看日志

[root@k8s-master ~]# kubectl logs pods/testpod

172.25.254.100 3306

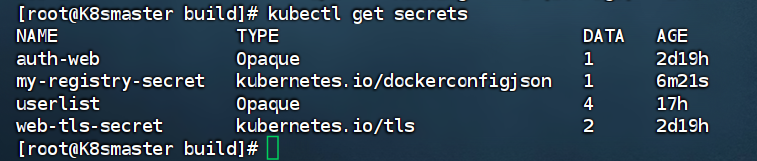

(二)secrets配置管理

2.1 功能介绍

在公有和私有的仓库中,均需要密钥信息才可以被使用

-

敏感信息放在 secret 中比放在 Pod 的定义或者容器镜像中来说更加安全和灵活

-

Pod 可以用两种方式使用 secret:

- 作为 volume 中的文件被挂载到 pod 中的一个或者多个容器里

-

当 kubelet 为 pod 拉取镜像时使用

2.2 secret创建方法

[root@K8smaster ~]# mkdir -p secrets

[root@K8smaster ~]# echo -n zym > username.txt

[root@K8smaster ~]# echo -n 123456 > password.txt[root@K8smaster ~]# kubectl create secret generic userlist --from-file username.txt --from-file password.txt

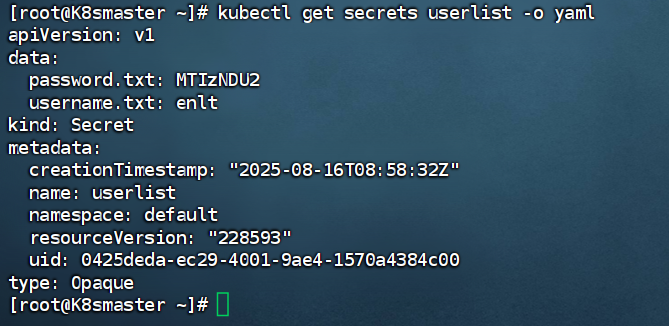

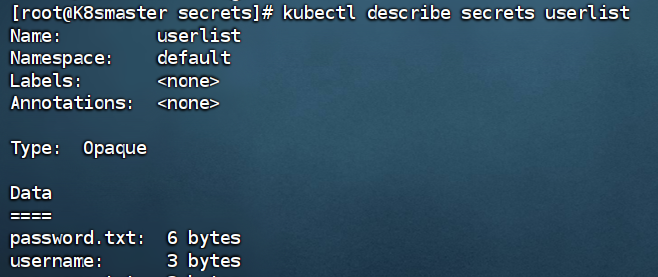

查看信息:

#查看密码编码

[root@K8smaster ~]# echo -n zym | base64

enlt

[root@K8smaster ~]# echo -n 123456 | base64

MTIzNDU2[root@k8s-master secrets]# kubectl create secret generic userlist --dry-run=client -o yaml > userlist.yml

编写yaml

apiVersion: v1

kind: Secret

metadata:creationTimestamp: nullname: userlist

type: Opaque

data:username: enlt #用户名password: MTIzNDU2 #密码

查看:

[root@K8smaster secrets]# kubectl apply -f userlist.yml

2.3 Secretss使用方法

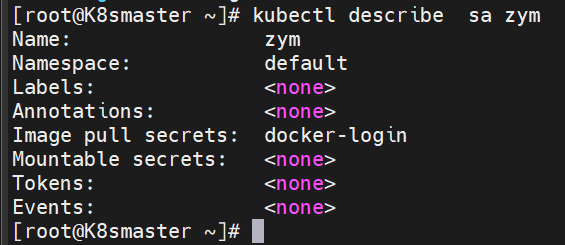

2.3.4 存储docker registry的认证信息

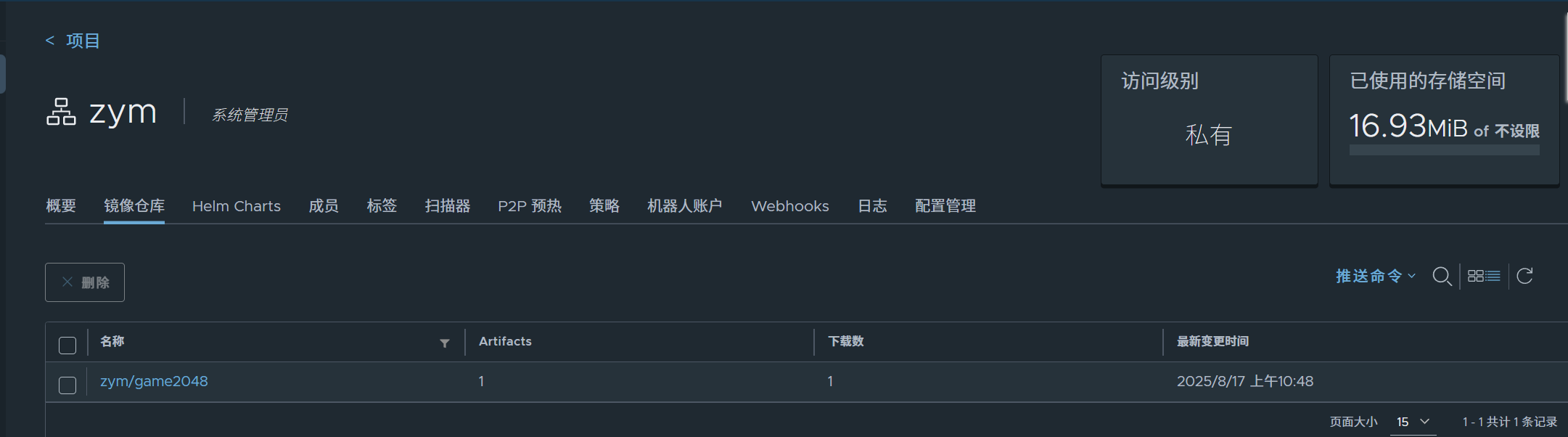

建立私有仓库并上传镜像

成功上传,如上图所示

[root@Harbor packages]# docker load -i game2048.tar.gz

Loaded image: timinglee/game2048:latest[root@Harbor packages]# docker tag timinglee/game2048:latest reg.zym.org/zym/game2048:latest[root@Harbor packages]# docker push reg.zym.org/zym/game2048

创建Docker认证的secret

[root@K8smaster build]# kubectl create secret docker-registry my-registry-secret --docker-server=reg.zym.org --docker-username=admin --docker-password=123456

编写yaml文件

apiVersion: v1

kind: Pod

metadata:labels:name: game2048name: game2048

spec:imagePullSecrets: #镜像拉取密钥- name: my-registry-secret #密钥名称containers:- image: reg.zym.org/zym/game2048:latestname: game2048

运行:

[root@K8smaster build]# kubectl apply -f pod3.yml

pod/game2048 created

[root@K8smaster build]# kubectl get pods

NAME READY STATUS RESTARTS AGE

game2048 1/1 Running 0 12s

(三) volumes卷配置管理

卷的两点重要性

- 数据的持久化

- 共享存储

存储卷的区别

| 存储类型 | 生命周期 | 数据持久性 | 适用场景 |

|---|---|---|---|

| emptyDir | 与 Pod 绑定 | 临时(Pod 删除丢失) | 容器间临时共享数据 |

| hostPath | 与节点绑定 | 节点本地持久化 | 单节点测试(不适合生产) |

| PersistentVolume | 集群级独立生命周期 | 跨 Pod / 节点持久化 | 生产环境数据存储(如数据库) |

3.1 emptyDir卷

emptyDir 是 Kubernetes 中一种简单的临时存储卷,它的核心特点是生命周期与 Pod 绑定,主要用于 Pod 内部容器之间共享数据,或存储临时数据

- 无法进行数据的持久化

emptyDir 的使用场景:

- 缓存空间,例如基于磁盘的归并排序

- 耗时较长的计算任务提供检查点,以便任务能方便地从崩溃前状态恢复执行

- 在 Web 服务器容器服务数据时,保存内容管理器容器获取的文件

示例配置:

[root@k8s-master volumes]# vim pod1.yml

apiVersion: v1

kind: Pod

metadata:name: vol1

spec:containers:- image: busyboxplus:latestname: vm1command:- /bin/sh- -c- sleep 30000000volumeMounts:- mountPath: /cachename: cache-vol- image: nginx:latestname: vm2volumeMounts:- mountPath: /usr/share/nginx/htmlname: cache-volvolumes:- name: cache-volemptyDir:medium: MemorysizeLimit: 100Mi[root@k8s-master volumes]# kubectl apply -f pod1.yml#查看pod中卷的使用情况

[root@k8s-master volumes]# kubectl describe pods vol1#测试效果[root@k8s-master volumes]# kubectl exec -it pods/vol1 -c vm1 -- /bin/sh

/ # cd /cache/

/cache # ls

/cache # curl localhost

<html>

<head><title>403 Forbidden</title></head>

<body>

<center><h1>403 Forbidden</h1></center>

<hr><center>nginx/1.27.1</center>

</body>

</html>

/cache # echo timinglee > index.html

/cache # curl localhost

timinglee

/cache # dd if=/dev/zero of=bigfile bs=1M count=101

dd: writing 'bigfile': No space left on device

101+0 records in

99+1 records out

3.2 hostpath卷

在 Kubernetes 中,hostPath卷的核心功能是将节点(Node)的本地文件系统路径挂载到 Pod 的容器中,实现 Pod 与所在节点之间的文件共享

- 可以进行数据持久化保存

示例配置:

apiVersion: v1

kind: Pod

metadata:name: vol1

spec:containers:- image: nginx:1.23name: vm1volumeMounts:- mountPath: /usr/share/nginx/htmlname: cache-volvolumes:- name: cache-volhostPath:path: /datatype: DirectoryOrCreate #当/data目录不存在时自动建立

测试:

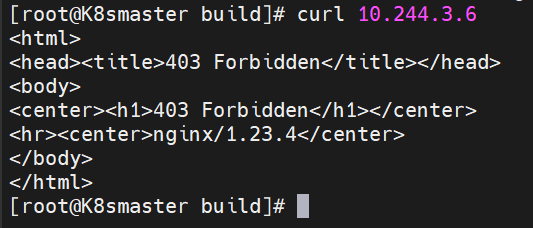

[root@K8smaster build]# kubectl get pod -o wide

NAME READY STATUS RESTARTS AGE IP NODE

vol1 1/1 Running 0 5m33s 10.244.3.6 k8sslave2.zym.org

在node节点上

[root@k8s-node2 ~]# echo liubailiu > /data/index.html

[root@k8s-master volumes]# curl 10.244.3.6s

liubailiu#当pod被删除后hostPath不会被清理

[root@k8s-master volumes]# kubectl delete -f pod2.yml

pod "vol1" deleted

[root@k8s-node2 ~]# ls /data/

index.html

3.4 nfs卷

-

NFS 卷允许将一个现有的 NFS 服务器上的目录挂载到 Kubernetes 中的 Pod 中,意思是:在集群以外创建一个NFS的服务器,pod挂载在NFS卷上,实现数据的持久化

-

如果有多个容器需要访问相同的数据集,或者需要将容器中的数据持久保存到外部存储,NFS 卷可以提供一种方便的解决方案

3.4.1部署一台nfs共享主机

#举例用Harbor仓库作为nfs共享主机

[root@Harbor packages]# dnf install nfs-utils -y[root@Harbor ~]# vim /etc/exports

/nfsdata *(rw,sync,no_root_squash)[root@Harbor ~]# mkdir -p /nfsdata

[root@Harbor ~]# exportfs -rv

exporting *:/nfsdata[root@Harbor ~]# showmount -e

Export list for Harbor.zym.org:

/nfsdata *

K8s集群上的所有节点均需安装nfs-utils

[root@k8s-master & node1 & node2 ~]# dnf install nfs-utils -y

3.4.2 部署nfs卷

配置yaml文件–pod3.yml

apiVersion: v1

kind: Pod

metadata:name: vol1

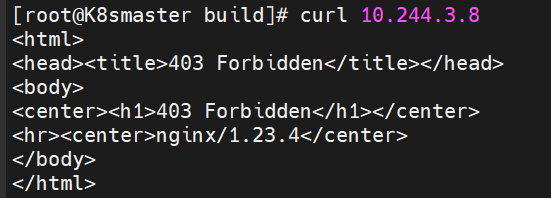

spec:containers:- image: nginx:1.23name: vm1volumeMounts:- mountPath: /usr/share/nginx/htmlname: cache-volvolumes:- name: cache-volnfs:server: 192.168.147.200path: /nfsdata[root@K8smaster build]# kubectl apply -f pod3.yml

pod/vol1 created[root@K8smaster build]# kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE

vol1 1/1 Running 0 20s 10.244.3.8 k8sslave2.zym.org

#访问该IP

curl 10.244.3.8

测试:

在nfs主机上创建内容文件

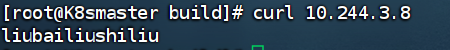

[root@Harbor ~]# echo liubailiushiliu > /nfsdata/index.html

集群中访问查看

3.5 PersistentVolume持久卷

PV 的核心是将存储资源(如 NFS、本地磁盘、云存储等)抽象为集群中的一种 “资源”,供 Pod 通过 PersistentVolumeClaim(PVC)申请使用,解决了 Pod 生命周期与数据持久化的矛盾(Pod 删除后,PV 中的数据仍可保留)

- pv和pod是相互独立的

- pv是集群中的一种资源,是一种Volume的插件

- pv的提供方式有两种方式:

- 静态PV:集群管理员创建多个PV,它们携带着真实存储的详细信息,它们存在于Kubernetes API中,并可用于存储使用

- 动态PV:当管理员创建的静态PV都不匹配用户的PVC时,集群可能会尝试专门地供给volume给PVC。这种供给基于StorageClass;当pod要使用资源的时候,会调用一个class自动创建pv存储分配器,去到nfs主机中读取数据

PersistentVolumeClaim(持久卷声明,简称PVC)

-

是用户的一种存储请求

-

它和Pod类似,Pod消耗Node资源,而PVC消耗PV资源

-

Pod能够请求特定的资源(如CPU和内存)。PVC能够请求指定的大小和访问的模式持久卷配置

-

PVC与PV的绑定是一对一的映射。没找到匹配的PV,那么PVC会无限期得处于unbound未绑定状态

volumes

-

容量(capacity):指定存储大小(如 10Gi)

-

访问模式(accessModes)

:支持的访问方式,包括:

ReadWriteOnce(RWO):仅允许单个节点读写ReadOnlyMany(ROX):允许多个节点只读ReadWriteMany(RWX):允许多个节点读写(需存储类型支持)

-

回收策略(persistentVolumeReclaimPolicy)

:PVC 释放后 PV 的处理方式:

Retain:保留数据,需手动清理(默认)Delete:自动删除 PV 及关联存储(适合云存储)Recycle:清空数据后可被重新申请(已废弃,推荐用 Retain)

-

存储类(storageClassName):关联到特定存储类(StorageClass),实现动态 PV 创建

注意:

[!NOTE]

只有NFS和HostPath支持回收利用

AWS EBS,GCE PD,Azure Disk,or OpenStack Cinder卷支持删除操作

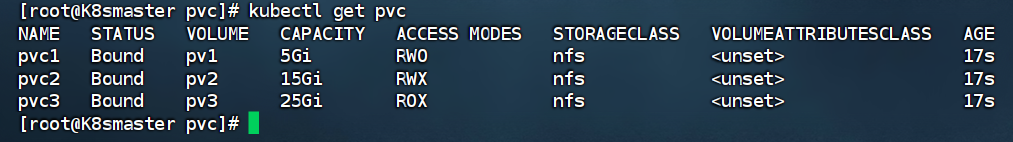

静态PV实例

#在nfs主机中建立实验目录

[root@reg ~]# mkdir /nfsdata/pv{1..3}

#编写创建pv的yml文件,pv是集群资源,不在任何namespace中

[root@k8s-master pvc]# vim pv.yml

apiVersion: v1

kind: PersistentVolume

metadata:name: pv1