研究背景与意义

研究背景与意义

随着城市化进程的加快,路边广告牌作为重要的商业宣传媒介,越来越多地出现在城市的各个角落。它们不仅承担着信息传播的功能,还对城市的视觉环境产生了深远的影响。然而,随着广告牌数量的激增,如何有效地管理和分析这些广告牌,成为了城市管理者和广告商面临的一大挑战。传统的人工监测和管理方式效率低下,难以满足日益增长的需求。因此,开发一种基于计算机视觉的自动化实例分割系统,能够精准识别和分析路边广告牌,显得尤为重要。

本研究旨在基于改进的YOLOv11模型,构建一个高效的路边广告牌实例分割系统。YOLO(You Only Look Once)系列模型因其实时性和高精度而广泛应用于目标检测领域。通过对YOLOv11进行改进,我们期望在提高检测精度的同时,提升模型对复杂场景的适应能力。为此,我们将利用一个包含2100张图像的多类别数据集,该数据集包含三类广告牌(T1、T2、T3),并已进行YOLO格式的标注。这一数据集的构建为模型的训练和验证提供了坚实的基础。

此外,实例分割技术的应用将使得广告牌的边界更加清晰,能够有效区分不同类别的广告牌,从而为后续的分析和决策提供更为准确的数据支持。通过对广告牌的自动识别与分类,城市管理者可以实时掌握广告牌的分布情况,优化广告资源的配置,提升城市的整体形象。同时,广告商也能借助这一系统,分析广告牌的投放效果,制定更为精准的市场策略。

综上所述,基于改进YOLOv11的路边广告牌实例分割系统,不仅具有重要的学术价值,还有着广泛的应用前景,能够为城市管理和商业决策提供有力支持。

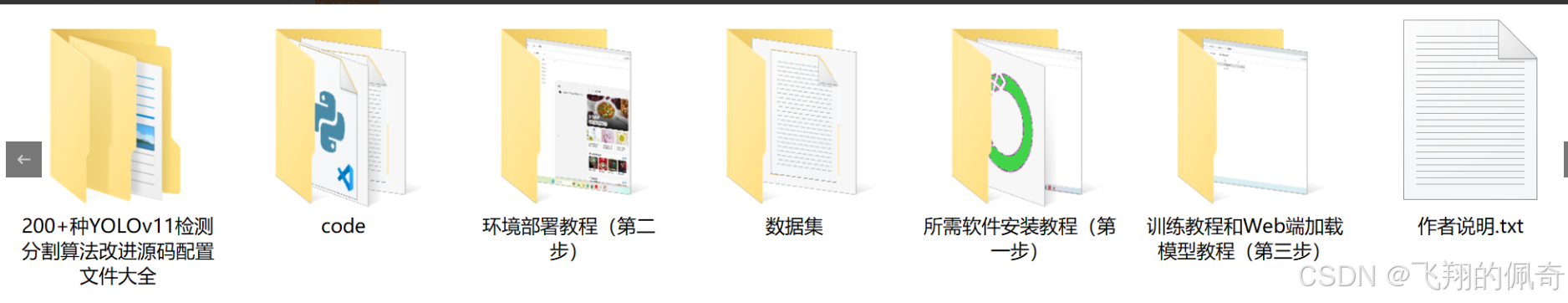

图片演示

数据集信息展示

本项目数据集信息介绍

本项目旨在改进YOLOv11的路边广告牌实例分割系统,所使用的数据集专注于“Sign”主题,涵盖了与路边广告牌相关的多种实例。该数据集包含三种主要类别,分别为T1、T2和T3,这些类别代表了不同类型的广告牌和标识,能够有效地为模型的训练提供多样化的样本。这种多样性不仅有助于提高模型的泛化能力,还能增强其在实际应用中的表现。

在数据集的构建过程中,我们注重了样本的多样性和代表性,确保涵盖了各种不同的环境和光照条件下的广告牌实例。这些实例包括城市街道、乡村道路以及商业区等多种场景,力求在训练过程中模拟真实世界中的各种情况。此外,为了提高数据集的实用性,我们还进行了数据增强处理,包括旋转、缩放、裁剪等操作,以生成更多的训练样本,从而提升模型的鲁棒性。

数据集的标注工作也经过严格的审核,确保每个实例的类别标注准确无误。通过精确的标注,模型能够更好地学习到不同类别广告牌的特征,从而在实例分割任务中实现更高的准确率和召回率。我们相信,凭借这一高质量的数据集,改进后的YOLOv11模型将在路边广告牌的检测和分割任务中展现出卓越的性能,为智能交通和城市管理等领域提供有力的技术支持。

项目核心源码讲解(再也不用担心看不懂代码逻辑)

以下是保留的核心代码部分,并附上详细的中文注释:

import torch

import torch.nn as nn

from einops import rearrange

class LayerNorm2d(nn.Module):

“”“自定义的二维层归一化模块”“”

def __init__(self, normalized_shape, eps=1e-6, elementwise_affine=True):super().__init__()# 使用 PyTorch 的 LayerNorm 进行归一化self.norm = nn.LayerNorm(normalized_shape, eps, elementwise_affine)def forward(self, x):# 将输入的形状从 (B, C, H, W) 转换为 (B, H, W, C)x = rearrange(x, 'b c h w -> b h w c').contiguous()# 进行归一化x = self.norm(x)# 将形状转换回 (B, C, H, W)x = rearrange(x, 'b h w c -> b c h w').contiguous()return x

class CrossScan(torch.autograd.Function):

“”“交叉扫描操作的自定义函数”“”

@staticmethod

def forward(ctx, x: torch.Tensor):B, C, H, W = x.shapectx.shape = (B, C, H, W)# 创建一个新的张量,用于存储交叉扫描的结果xs = x.new_empty((B, 4, C, H * W))# 第一部分:直接展平xs[:, 0] = x.flatten(2, 3)# 第二部分:转置后展平xs[:, 1] = x.transpose(dim0=2, dim1=3).flatten(2, 3)# 第三和第四部分:翻转前两部分xs[:, 2:4] = torch.flip(xs[:, 0:2], dims=[-1])return xs@staticmethod

def backward(ctx, ys: torch.Tensor):B, C, H, W = ctx.shapeL = H * W# 反向传播时,合并计算梯度ys = ys[:, 0:2] + ys[:, 2:4].flip(dims=[-1]).view(B, 2, -1, L)y = ys[:, 0] + ys[:, 1].view(B, -1, W, H).transpose(dim0=2, dim1=3).contiguous().view(B, -1, L)return y.view(B, -1, H, W)

class SS2D(nn.Module):

“”“自定义的二维选择性扫描模块”“”

def __init__(self, d_model=96, d_state=16, ssm_ratio=2.0, dropout=0.0):super().__init__()self.in_proj = nn.Conv2d(d_model, d_model * ssm_ratio, kernel_size=1) # 输入投影self.out_proj = nn.Conv2d(d_model * ssm_ratio, d_model, kernel_size=1) # 输出投影self.dropout = nn.Dropout(dropout) # Dropout 层def forward(self, x: torch.Tensor):x = self.in_proj(x) # 进行输入投影# 这里可以插入选择性扫描的逻辑x = self.dropout(x) # 应用 Dropoutx = self.out_proj(x) # 进行输出投影return x

class VSSBlock_YOLO(nn.Module):

“”“YOLO中的自定义块”“”

def __init__(self, in_channels: int, hidden_dim: int, drop_path: float = 0):super().__init__()self.proj_conv = nn.Conv2d(in_channels, hidden_dim, kernel_size=1) # 投影卷积self.ss2d = SS2D(d_model=hidden_dim) # 选择性扫描模块self.drop_path = nn.Dropout(drop_path) # DropPath 层def forward(self, input: torch.Tensor):input = self.proj_conv(input) # 进行投影x = self.ss2d(input) # 进行选择性扫描x = self.drop_path(x) # 应用 DropPathreturn x

代码注释说明:

LayerNorm2d: 自定义的二维层归一化模块,主要用于对输入的特征图进行归一化处理,以提高模型的训练稳定性。

CrossScan: 自定义的交叉扫描操作,包含前向和反向传播的实现。前向传播中对输入进行展平和转置操作,反向传播中计算梯度。

SS2D: 自定义的二维选择性扫描模块,包含输入和输出的卷积投影,以及 Dropout 层,用于防止过拟合。

VSSBlock_YOLO: YOLO网络中的自定义块,包含输入的投影卷积和选择性扫描模块的组合,最后应用 DropPath。

这些核心部分是实现选择性扫描和特征处理的基础,能够有效地进行特征提取和信息融合。

这个程序文件 mamba_yolo.py 实现了一个基于深度学习的模型,主要用于计算机视觉任务,特别是目标检测。文件中包含多个类和函数,主要功能是构建一个复杂的神经网络架构。以下是对代码的详细说明。

首先,导入了一些必要的库,包括 torch 和 torch.nn,这些是构建深度学习模型的基础库。还使用了 einops 库来进行张量的重排和重复操作,以及 timm 库中的 DropPath 层用于实现随机深度的特性。

接下来,定义了一个 LayerNorm2d 类,这是一个二维层归一化的实现,适用于图像数据。它通过调整输入的维度顺序来应用 LayerNorm,确保在通道维度上进行归一化。

autopad 函数用于自动计算卷积操作的填充,以确保输出的形状与输入相同,方便后续的层连接。

接下来定义了几个重要的自定义操作,包括 CrossScan 和 CrossMerge,它们实现了特定的张量操作,主要用于在网络中进行信息的交叉扫描和合并。这些操作通过 PyTorch 的自定义 autograd 功能实现,能够在前向和反向传播中高效计算。

SelectiveScanCore 类实现了选择性扫描的核心功能,允许在特定条件下对输入进行选择性处理。这个类的前向和反向方法都使用了 CUDA 加速,以提高计算效率。

cross_selective_scan 函数是一个高层次的接口,结合了前面定义的操作,处理输入张量并应用选择性扫描,返回处理后的输出。

接下来是 SS2D 类,它实现了一个基于选择性扫描的二维神经网络模块。这个模块包括输入投影、卷积层、选择性扫描操作和输出投影。它的设计允许在不同的配置下灵活使用,支持多种前向传播方式。

RGBlock 和 LSBlock 类实现了特定的块结构,分别用于处理输入特征并进行非线性变换。它们通过卷积层和激活函数组合,形成深度学习中的基本构建块。

XSSBlock 和 VSSBlock_YOLO 类是更复杂的模块,结合了前面定义的所有组件,形成了一个完整的网络层。它们支持多种配置选项,允许用户根据需求调整模型的结构和参数。

SimpleStem 类是网络的起始部分,负责将输入图像转换为适合后续处理的特征表示。它通过一系列卷积和归一化层来实现。

最后,VisionClueMerge 类用于合并特征图,通常在多尺度特征融合的场景中使用。

整体来看,这个文件实现了一个复杂的深度学习模型,具有高度的模块化和灵活性,适合用于计算机视觉任务,尤其是目标检测。通过使用选择性扫描和自定义的张量操作,模型能够有效地处理输入数据并提取有用的特征。

10.4 afpn.py

以下是经过简化和注释的核心代码部分,主要保留了模型的结构和关键功能。

import torch

import torch.nn as nn

import torch.nn.functional as F

from …modules.conv import Conv

定义基本的卷积块

class BasicBlock(nn.Module):

def init(self, filter_in, filter_out):

super(BasicBlock, self).init()

# 两个卷积层

self.conv1 = Conv(filter_in, filter_out, 3)

self.conv2 = Conv(filter_out, filter_out, 3, act=False)

def forward(self, x):residual = x # 保存输入用于残差连接out = self.conv1(x) # 第一个卷积out = self.conv2(out) # 第二个卷积out += residual # 残差连接return self.conv1.act(out) # 返回激活后的输出

定义上采样模块

class Upsample(nn.Module):

def init(self, in_channels, out_channels, scale_factor=2):

super(Upsample, self).init()

# 使用1x1卷积和双线性插值进行上采样

self.upsample = nn.Sequential(

Conv(in_channels, out_channels, 1),

nn.Upsample(scale_factor=scale_factor, mode=‘bilinear’)

)

def forward(self, x):return self.upsample(x) # 执行上采样

定义下采样模块

class Downsample_x2(nn.Module):

def init(self, in_channels, out_channels):

super(Downsample_x2, self).init()

# 使用2x2卷积进行下采样

self.downsample = Conv(in_channels, out_channels, 2, 2, 0)

def forward(self, x):return self.downsample(x) # 执行下采样

自适应特征融合模块

class ASFF_2(nn.Module):

def init(self, inter_dim=512):

super(ASFF_2, self).init()

compress_c = 8 # 压缩通道数

# 定义权重卷积层

self.weight_level_1 = Conv(inter_dim, compress_c, 1)

self.weight_level_2 = Conv(inter_dim, compress_c, 1)

self.weight_levels = nn.Conv2d(compress_c * 2, 2, kernel_size=1) # 计算融合权重

self.conv = Conv(inter_dim, inter_dim, 3) # 最后的卷积层

def forward(self, input1, input2):# 计算每个输入的权重level_1_weight_v = self.weight_level_1(input1)level_2_weight_v = self.weight_level_2(input2)levels_weight_v = torch.cat((level_1_weight_v, level_2_weight_v), 1) # 拼接权重levels_weight = self.weight_levels(levels_weight_v) # 计算最终权重levels_weight = F.softmax(levels_weight, dim=1) # 归一化权重# 根据权重融合输入fused_out_reduced = input1 * levels_weight[:, 0:1, :, :] + input2 * levels_weight[:, 1:2, :, :]out = self.conv(fused_out_reduced) # 最后的卷积return out

定义特征金字塔网络(FPN)模块

class AFPN_P345(nn.Module):

def init(self, in_channels=[256, 512, 1024], out_channels=256, factor=4):

super(AFPN_P345, self).init()

# 输入通道的卷积层

self.conv0 = Conv(in_channels[0], in_channels[0] // factor, 1)

self.conv1 = Conv(in_channels[1], in_channels[1] // factor, 1)

self.conv2 = Conv(in_channels[2], in_channels[2] // factor, 1)

# 定义特征融合的主体self.body = BlockBody_P345([in_channels[0] // factor, in_channels[1] // factor, in_channels[2] // factor])# 输出通道的卷积层self.conv00 = Conv(in_channels[0] // factor, out_channels, 1)self.conv11 = Conv(in_channels[1] // factor, out_channels, 1)self.conv22 = Conv(in_channels[2] // factor, out_channels, 1)def forward(self, x):x0, x1, x2 = x # 输入特征图x0 = self.conv0(x0) # 卷积处理x1 = self.conv1(x1)x2 = self.conv2(x2)out0, out1, out2 = self.body([x0, x1, x2]) # 特征融合out0 = self.conv00(out0) # 输出处理out1 = self.conv11(out1)out2 = self.conv22(out2)return [out0, out1, out2] # 返回输出特征图

代码注释说明

BasicBlock: 定义了一个基本的卷积块,包含两个卷积层和残差连接。

Upsample/Downsample: 定义了上采样和下采样模块,分别使用卷积和插值方法调整特征图的尺寸。

ASFF_2: 自适应特征融合模块,通过计算输入特征的权重进行融合。

AFPN_P345: 特征金字塔网络的核心模块,处理输入特征图并输出融合后的特征图。

这些模块可以组合成更复杂的网络结构,适用于图像处理和计算机视觉任务。

这个程序文件afpn.py实现了一种特征金字塔网络(AFPN),用于计算机视觉任务中的特征提取和融合。该文件主要包含多个类,每个类实现了特定的功能,整体上构成了一个复杂的神经网络结构。

首先,文件引入了一些必要的库,包括torch和torch.nn,这些是PyTorch框架的核心模块,用于构建和训练神经网络。OrderedDict用于有序字典的操作,可能在某些模块中使用。

接下来,定义了多个类,其中BasicBlock类实现了一个基本的卷积块,包含两个卷积层和残差连接。Upsample和Downsample_x2等类用于实现上采样和下采样操作,分别通过卷积和插值方法调整特征图的尺寸。

ASFF_2、ASFF_3和ASFF_4类实现了自适应特征融合模块,能够根据输入特征图的权重进行加权融合。这些模块的设计允许网络在不同尺度上灵活地整合特征,从而提高特征表达能力。

BlockBody_P345和BlockBody_P2345类是网络的主体部分,分别处理不同数量的输入特征图。它们通过多层卷积块和自适应特征融合模块构建了一个深度网络结构。每个块都包含多个卷积层和下采样、上采样操作,以便在不同尺度上提取和融合特征。

AFPN_P345和AFPN_P2345类是特征金字塔网络的具体实现,分别接收3个和4个输入通道的特征图。它们通过初始化卷积层和主体块,将输入特征图进行处理,最终输出经过处理的特征图。AFPN_P345_Custom和AFPN_P2345_Custom类则允许用户自定义块的类型,以便在特定任务中使用不同的网络结构。

最后,文件中还包含了对卷积层和批归一化层的权重初始化,以确保网络在训练初期的稳定性和收敛速度。

总体而言,这个文件实现了一个灵活且强大的特征金字塔网络,适用于各种计算机视觉任务,如目标检测和图像分割等。通过不同的模块组合和自适应特征融合,网络能够有效地提取和利用多尺度特征信息。

源码文件

源码获取

欢迎大家点赞、收藏、关注、评论啦 、查看👇🏻获取联系方式👇🏻

)

)

)

(二十一)——unordered_set和unordered_map)