快速回顾

有更多第三方可以提供免费的大模型体验服务,比如硅基流动/火山方舟,通过选择指定模型,生成模型id和自己的API-KEY这两个信息,可以在第三方集成ai工具,如cherry studio上使用;

参考来源

来自阮一峰科技周刊中的一篇文章

https://www.ruanyifeng.com/blog/2025/02/weekly-issue-337.html

火山引擎 DeepSeek API 介绍

笔记软件Obsidian如何接入DeepSeek API

练习实践–关于deepseek的使用环境搭建回顾–火山方舟

问题一:从哪里获得可用的DeepSeek模型?(渠道)

DeepSeek 是现在最热门的模型,但是你不一定要使用官方 API,完全可以用第三方 API 替代。

因为 DeepSeek 是开源模型,任何人都可以架设,第三方 API 其实跟官方的效果完全一样。

问题二:在各种可用的路径之中选择哪个,(判断和偏好)?

我用的就是第三方 DeepSeek API,服务商是火山引擎,今天就来说说怎么用

火山引擎是字节旗下的云服务部门,实力和可靠性都有保证。除了自家的豆包大模型,它也提供其他大模型。

相比官方 API,它有一些显著的优点。

(1)免费额度高,50万的免费 token 额度,用完才收费。

(2)成本低。现在是五折优惠,R1 模型的百万 token 的输入价格为2元人民币,输出8元,比 DeepSeek 官方价格都要低。

(3)流量大。每分钟 token 限额(TPM)是500万,每日 token 限额(TPD)是50亿,都是全网最高,不用担心超过限额。

(4)延迟低。它在国内有多个机房,不管哪里连接,响应时间都在几十毫秒、甚至十几毫秒。

(5)联网搜索能力。它允许 DeepSeek 模型联网搜索,并且还允许用户定制联网能力(内容源、引用条数等)。

问题三:火山方舟的DeepSeek模型怎么搭建?(此路径下的实现步骤)

下面就是它的 DeepSeek API 的接入教程,很简单。

首先,火山方舟登录链接 ,提供服务需要提供实名认证,登录它的大模型开发平台"火山方舟",选择左侧菜单的**“在线推理**”,然后点击"创建推理接入点"(下图)。

接着,填写接口名称和选择模型,建议选择"DeepSeek-V3"(下图)。

问题四:搭建DeepSeek模型后有哪些需要注意的信息(模型ID和自己的API KEY–这两个信息)

接口开通成功后,系统会分配一个模型名称(比如,下图的 ep-2025021318563-***),这个名称要记下。

另外就是有个接入的api-key信息,这个也需要记下,在查看API KEY中,可以直接复制,这个在客户端接入时也需要用到;

问题五:怎么确认搭建模型成功 ?(标志/里程碑事件)

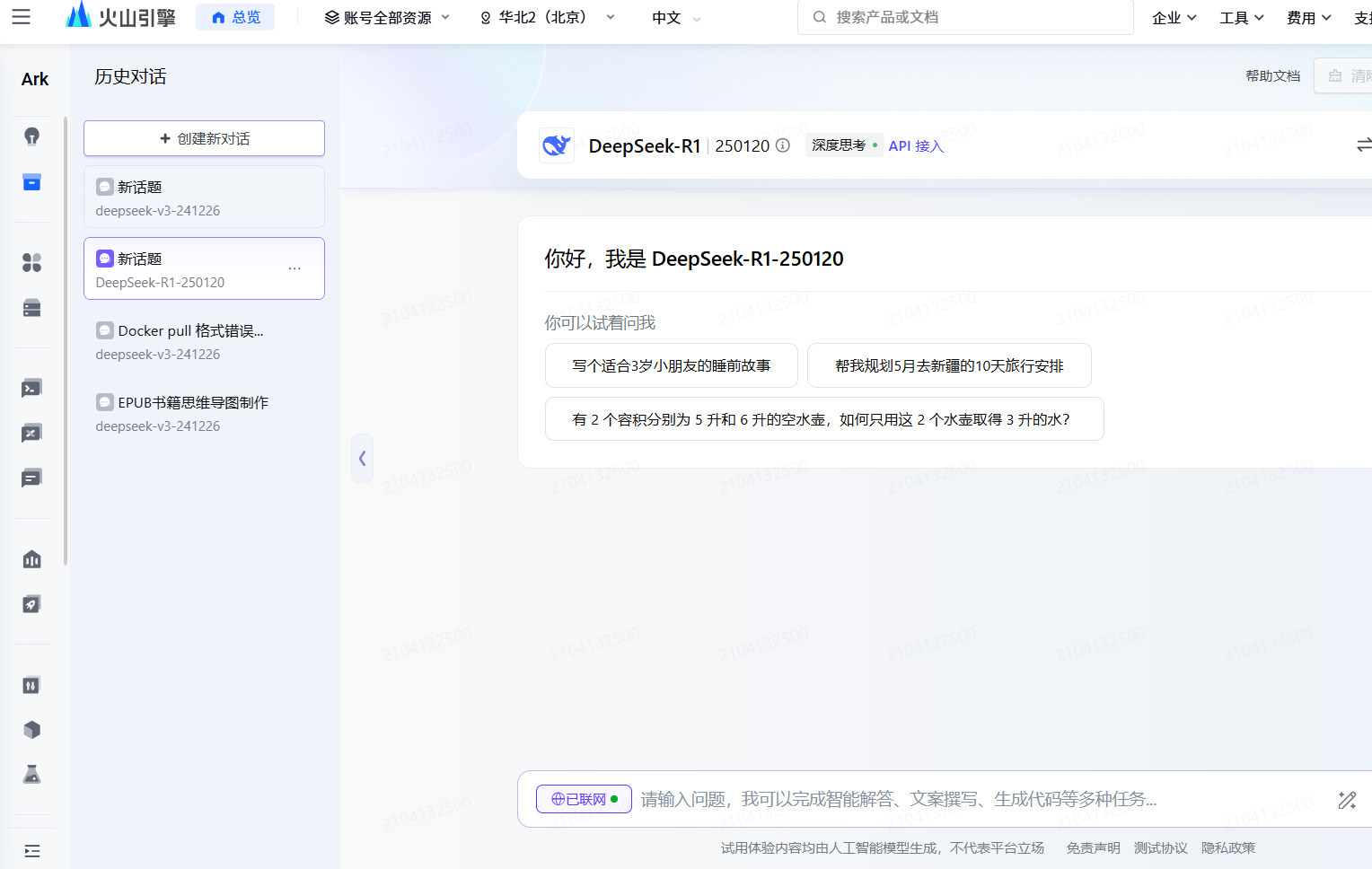

在对于接人点名称创建之后,有个体验的功能,这里可以直接网页访问,进行交互体验

问题六:在集成ai的模型客户端工具上如何使用,如cherry studio上使用基于火山引擎的DeepSeek

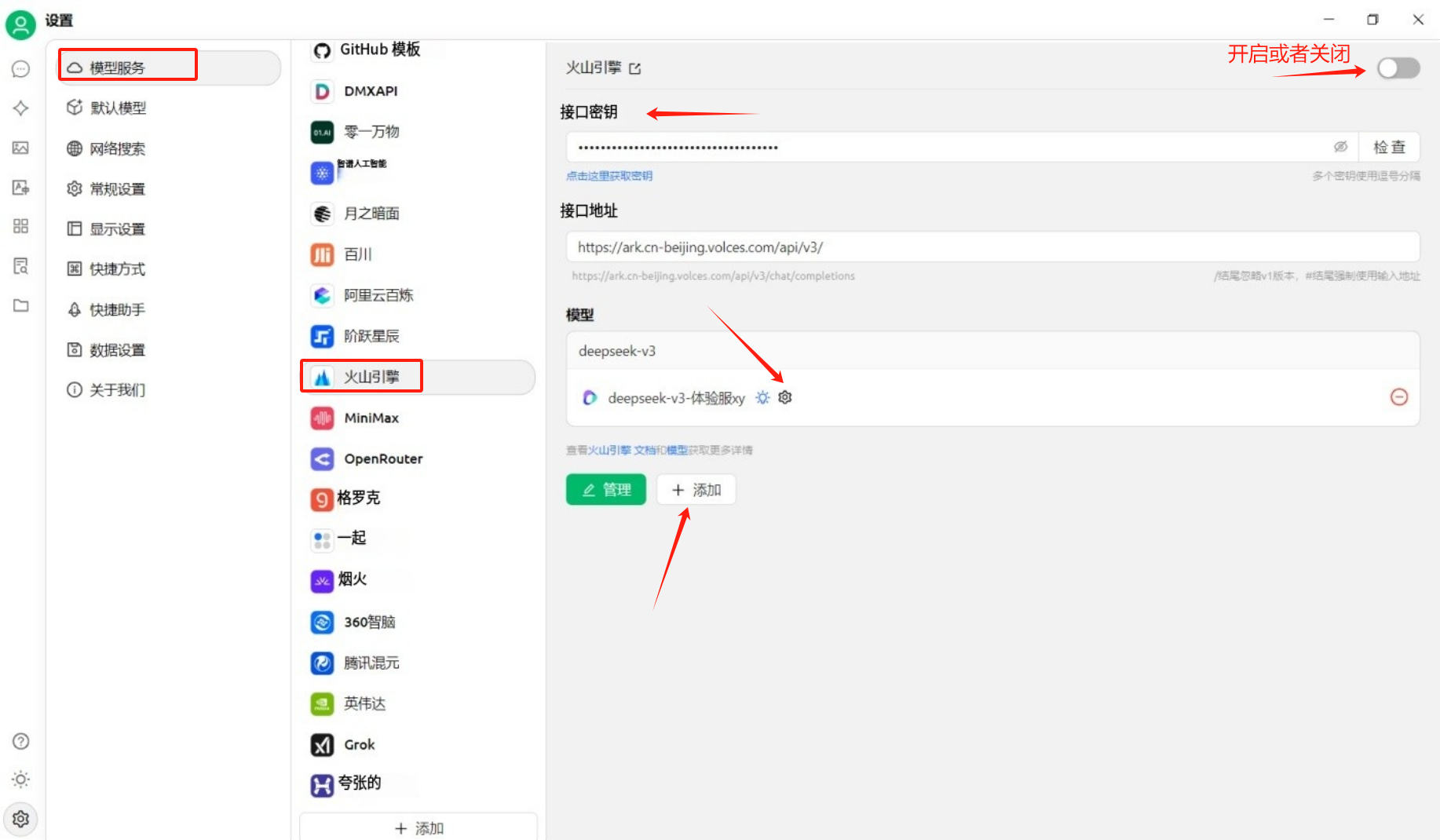

在对应设置,找到模型服务-火山引擎,填入对应的接口密钥(API-KEY),点击添加,模型ID就是火山方舟中的接入点名称/id中的ep开头的信息;

添加完成之后,点击检查按钮,确认参数填写正确,如果没问题,会有连接成功的提示;

下一步,就是客户端接入 DeepSeek API 了。

客户端配置的关键一步,就是上面的配置页。Model Name 是系统刚才分配给你的模型名字,Provider 选择 OpenAI Format,Base URL 填写https://ark.cn-beijing.volces.com/api/v3,API key 就是你在火山引擎模型详情的"API 调用"里面,让系统生成的 API 密钥。

客户端配置完成后,就可以开始使用 DeepSeek API 了。

在设置中可以选择默认模型,然后就可以通过客户端cherry studio来使用火山引擎上的DeepSeek上的服务;

这里用的是硅基流动上提供的DeeoSeek-V3的api接口服务;

在线交互的豆包,能够阅读的书籍字数有限制(大概10万字),然后通过第三方的deepseek模型服务,可以字数的更多,还可以通过创建知识库进行多本书籍联合阅读,输出对应的大纲笔记等内容;

–END

)

)