1.基础概念

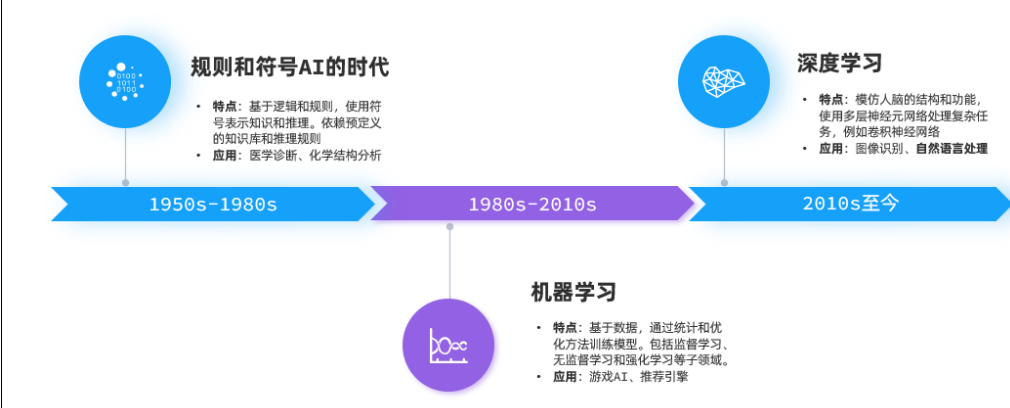

1.1 AI的概念:

1.2 神经网络的基本概念

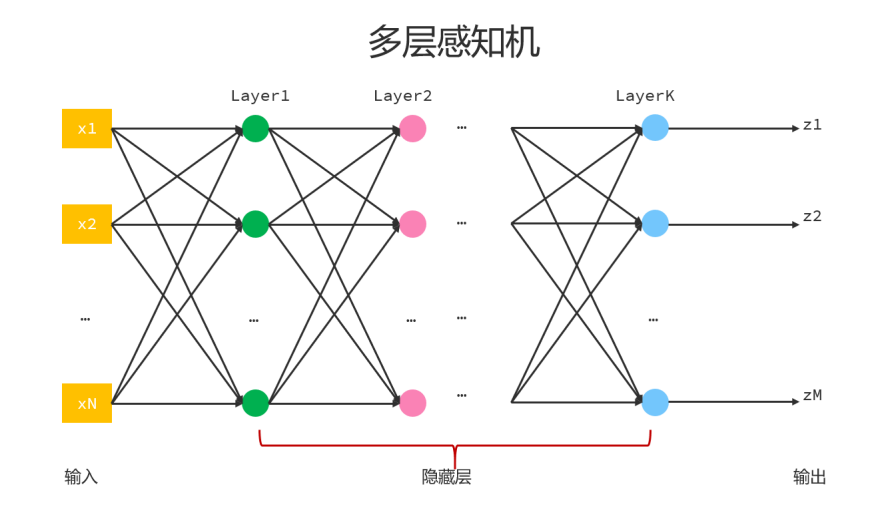

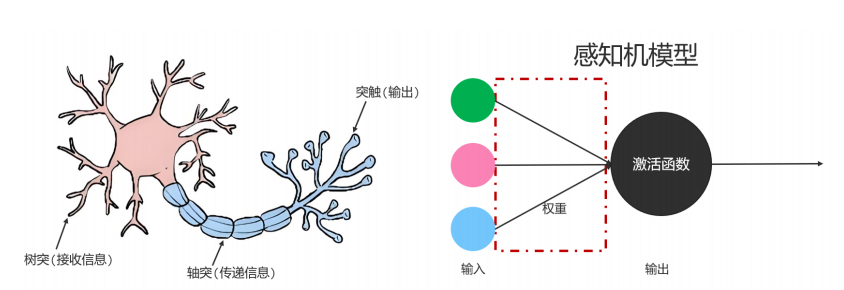

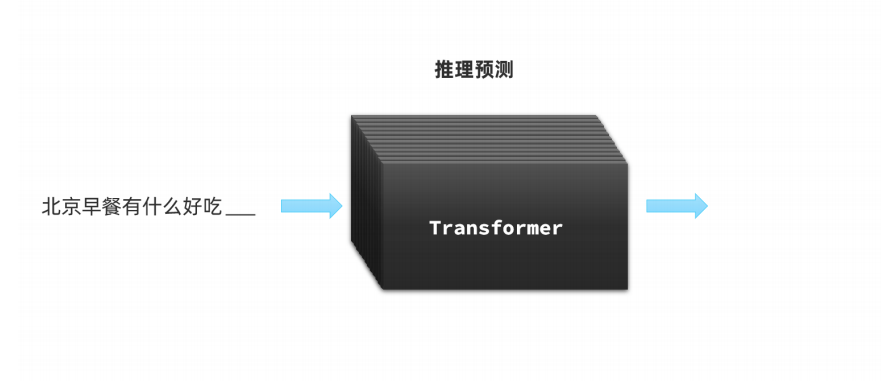

如果我们想通过模拟人脑的方式实现人工智能,首先就要模拟出一个神经元,于是人们提出感知机模型,用于模拟神经元,在感知机模型中,有输入,权重,激活函数,假设输入和激活函数都不变的情况下,我们可以通过调整权重值,得到不同输出。

单个感知机模型只能模拟单个神经元,每个感知机上都有输入,输出,激活函数,将来会结合用户的输入和权重以及激活函数,再与阈值(偏置)比较,最终得到输出,每个神经元上使用的权重和阈值都称为参数,每个神经元上的参数数量=权重数量+1,这里的1指的是偏置。

大模型的大指参数规模,现在我们通常将参数规模在1000亿以上的模型称为大模型。

1.3 大模型的基本概念

2.大模型基本使用

2.1 模型使用方案

我们要使用一个可访问的大模型通常有三种方案:

使用开放的API,在云平台部署私有大模型,在本地服务器部署私有大模型

开放API没有运维成本,按调用收费,但是长期使用成本较高且数据存在第三方,存在隐私和安全问题。云平台部署私有模型部署和运维方便,前期投入成本低,但是长期使用成本高,且同样存在安全问题。本地部署私有大模型数据完全自主掌控,安全性高,但硬件投入成本极高且维护困难。

2.2 Ollama本地部署

下载Ollama客户端并根据指令进行模型部署等操作

一、基础操作指令

| 指令 | 功能 | 示例 |

|---|---|---|

ollama run <模型名> | 运行指定模型(自动下载若不存在) | ollama run llama3 |

ollama list | 查看本地已下载的模型列表 | ollama list |

ollama pull <模型名> | 手动下载模型 | ollama pull mistral |

ollama rm <模型名> | 删除本地模型 | ollama rm llama2 |

ollama help | 查看帮助文档 | ollama help |

二、模型交互指令

1. 直接对话

ollama run llama3 "用中文写一首关于秋天的诗"2. 进入交互模式

ollama run llama3

# 进入后输入内容,按 Ctrl+D 或输入 `/bye` 退出3. 从文件输入

ollama run llama3 --file input.txt4. 流式输出控制

| 参数 | 功能 | 示例 |

|---|---|---|

--verbose | 显示详细日志 | ollama run llama3 --verbose |

--nowordwrap | 禁用自动换行 | ollama run llama3 --nowordwrap |

三、模型管理

1. 自定义模型配置(Modelfile)

创建 Modelfile 文件:

FROM llama3 # 基础模型

PARAMETER temperature 0.7 # 控制随机性(0-1)

PARAMETER num_ctx 4096 # 上下文长度

SYSTEM """ 你是一个严谨的学术助手,回答需引用论文来源。""" # 系统提示词构建自定义模型:

ollama create my-llama3 -f Modelfile

ollama run my-llama32. 查看模型信息

ollama show <模型名> --modelfile # 查看模型配置

ollama show <模型名> --parameters # 查看运行参数四、高级功能

1. API 调用

启动 API 服务

ollama serve通过 HTTP 调用

curl http://localhost:11434/api/generate -d '{"model": "llama3","prompt": "你好","stream": false

}'2. GPU 加速配置

# 指定显存分配比例(50%)

ollama run llama3 --num-gpu 502.3 API调用大模型接口

目前大多数大模型都遵循OpenAI的接口规范,是给予http协议的接口,具体规范可查看相关大模型官方API文档。

大模型接口规范:

这是DeepSeek官方文档给出的调用示例:

# Please install OpenAI SDK first: `pip3 install openai`

from openai import OpenAI

# 1.初始化OpenAI客⼾端,要指定两个参数:api_key、base_url

client = OpenAI(api_key="<DeepSeek API Key>",

base_url="https://api.deepseek.com")

# 2.发送http请求到⼤模型,参数⽐较多

response = client.chat.completions.create(

model="deepseek-chat", # 2.1.选择要访问的模型

messages=[ # 2.2.发送给⼤模型的消息

{"role": "system", "content": "You are a helpful assistant"},

{"role": "user", "content": "Hello"},

],

stream=False # 2.3.是否以流式返回结果

)

print(response.choices[0].message.content)接口说明:

请求路径:与平台有关

安全校验:开放平台提供API_KEY校验权限,Ollama不需要

请求参数:

model(访问模型名称)

message(发送给大模型的消息,是一个数组)

stream(true代表响应结果流式返回,false代表响应结果一次性返回,但需要等待)

temperature(取值范围[0,2),代表大模型生成结果的随机性,值越小随机性越低,deepseek-r1不支持此参数)

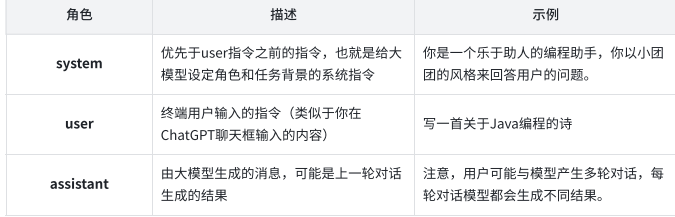

message数组中两个属性:role和content,通常,role有三种:

3.大模型应用

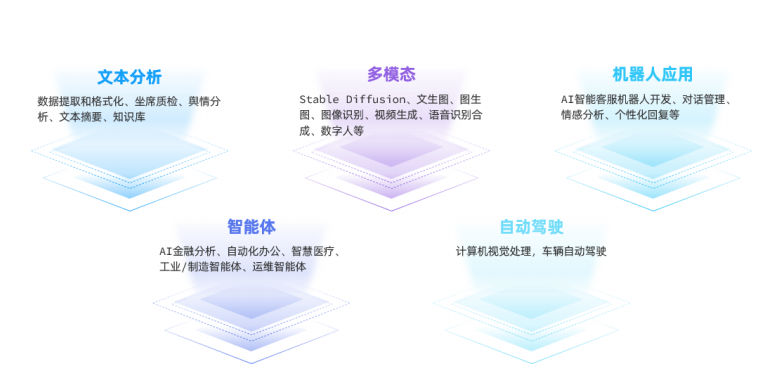

大模型应用是基于大模型的推理,分析,生成能力,结合传统编程能力,开发出的各种应用。

大模型是基于数据驱动的概率推理,擅长处理模糊性和不确定性,如自然语言处理(文本翻译),非结构化数据处理(医学影像诊断),创造性内容生成(生成图片),复杂模式预测(股票预测)等,而上述内容正式我们传统应用所不擅长处理的部分,因此,可以将传统编程和大模型整合起来,开发智能化的大模型应用。

大模型本身只是具备生成文本的能力,基本推理能力,我们平时使用的ChatGPT等对话产品除了生成和推理外,还有会话记忆,联网等功能,这些是大模型本身所不具备的,是需要额外程序去完成的,也就是基于大模型的应用。

常见的一些大模型产品及其模型关系:

| 大模型 | 对话产品 | 公司 | 地址 |

|---|---|---|---|

| GPT-3.5、GPT-4o | ChatGPT | OpenAI | https://chatgpt.com/ |

| Claude 4.0 | Claude AI | Anthropic | App unavailable \ Anthropic |

| DeepSeek-R1 | DeepSeek | 深度求索 | DeepSeek | 深度求索 |

| 文心大模型 3.5 | 文心一言 | 百度 | 文心一言 |

| 星火 3.5 | 讯飞星火 | 科大讯飞 | 讯飞星火-懂我的AI助手 |

| Qwen-Max | 通义千问 | 阿里巴巴 | 通义 - 你的实用AI助手 |

| Moonshoot | Kimi | 月之暗面 | Kimi - 会推理解析,能深度思考的AI助手 |

| Yi-Large | 零一万物 | 零一万物 | 零一万物-大模型开放平台 |

大模型应用的常见领域:

)

—模板方法模式)

:快速入门操作系统常见基础概念)

)

)

技术报告--2025.7.23--字节跳动 Seed)