本文还有配套的精品资源,点击获取

简介:安徽大学的概率论课程围绕随机现象的规律性,覆盖了多个核心概念,如随机事件的概率、条件概率、独立事件、概率分布、期望值、方差、大数定律和中心极限定理。本资源包含期末试卷及答案,旨在测试学生对概率论的理解和应用能力,并通过答案解析提供学习反馈,帮助学生深化对这些概念的理解。学生通过实际问题的应用,可以更有效地掌握这些理论知识,为考试和实际应用做准备。

1. 概率论课程重点概念解析

概率论是研究随机现象数量规律的数学分支,在数据分析、统计学和工程领域有着广泛的应用。本章将对概率论中的关键概念进行梳理,以便更好地理解和运用其理论。

1.1 概率论的数学基础

概率论的基础是集合论和测度论,这些数学工具帮助我们定义了随机事件及其概率。理解这些数学基础有助于深入分析复杂系统的随机性。

1.2 随机变量与概率分布

随机变量是概率论中的核心概念,它将样本空间中的元素与实数对应起来。概率分布则描述了随机变量取不同值的概率。熟悉各种分布类型是学习概率论的关键步骤。

1.3 数学期望与方差

数学期望和方差是评价随机变量特征的两个重要度量。期望值告诉我们随机变量的“平均”行为,而方差衡量了其波动程度。这两个概念在统计分析中具有重要作用。

在后续章节中,我们将逐一深入探讨上述概念,揭示它们在概率论和实际问题解决中的内在联系和应用。

2. 随机事件及概率计算

2.1 随机事件的基本概念

2.1.1 随机试验与样本空间

在概率论中,随机试验是所有可能结果已知,但每一次试验结果又不可预测的实验。例如掷骰子,我们知道可能的结果有6种,但无法确定下一次掷出的是哪一个。随机试验是概率论中构造随机事件的基础。

样本空间是随机试验所有可能结果的集合,通常用大写字母 (S) 表示。对于掷骰子这个随机试验,其样本空间 (S = {1, 2, 3, 4, 5, 6})。样本空间中的每一个元素称为一个基本事件。

2.1.2 基本事件与复合事件

基本事件是指样本空间中不可再分的单一结果。在这个掷骰子的例子里,每一个点数,如“掷出4点”,都是一个基本事件。

复合事件是由基本事件按照一定规则组合而成的事件。复合事件可以是一系列基本事件的并集、交集或补集。例如,“掷出的点数是偶数”就是一个复合事件,因为它包含了“掷出2点”,“掷出4点”,和“掷出6点”这三个基本事件。

代码块示例与参数说明

由于随机事件的讨论不直接关联到具体代码实现,下面的代码块示例用以说明如何在Python中通过代码模拟随机试验并生成样本空间。

import itertools# 定义掷骰子的函数,返回一个1到6的随机数

def roll_dice():return random.randint(1, 6)# 定义一个模拟掷骰子多次并返回结果列表的函数

def roll_dice_multiple_times(n):return [roll_dice() for _ in range(n)]# 模拟掷两次骰子

sample_space = roll_dice_multiple_times(2)

print(sample_space) # 输出可能是 [3, 5],表示掷出的点数

在这个代码块中,我们首先导入了 random 和 itertools 模块,然后定义了模拟掷骰子的函数 roll_dice 。我们通过调用 random.randint 函数生成1到6之间的随机整数,模拟单次掷骰子的结果。接着,我们定义了一个函数 roll_dice_multiple_times 来模拟掷骰子多次。这里我们模拟了掷两次骰子,并将结果打印出来。结果的列表构成了一个复合事件的一个实例,即两次掷骰子的所有可能结果集合。

逻辑分析

在上述Python代码的执行过程中,我们创建了一个函数来模拟掷骰子的动作,每次调用这个函数都可能返回一个不同的结果,这就是随机试验的核心。通过函数的多次调用,我们可以模拟实际中掷骰子的随机性,并构建出相关的样本空间和事件。

2.2 概率的定义与性质

2.2.1 古典概率模型

在古典概率模型中,当一个随机试验的所有可能结果数目有限且等可能时,单个事件发生的概率定义为该事件发生的结果数除以所有可能结果的总数。这个定义非常适用于那些每个基本事件发生的可能性相同的随机试验。

例如,掷一枚公平的硬币,结果有两个——正面和反面。因此,得到正面的概率是1/2。古典概率模型是对等可能原理的一个应用。

2.2.2 几何概率与条件概率

几何概率是基于几何图形的长度、面积或体积来计算概率。例如,如果我们随机从1到2之间选取一个数,选取到1.5的概率就是1/2,因为1.5位于区间[1,2]的中点,该区间长度为1。

条件概率是在某个条件下事件发生的概率,记作 (P(A|B)),表示事件A在事件B已经发生的条件下发生的概率。它满足条件 (P(A \cap B) = P(A|B) \cdot P(B)),其中 (P(A \cap B)) 表示事件A和B同时发生的概率。

代码块示例与参数说明

对于几何概率,我们可以用Python计算一个简单几何事件的概率,比如,随机投点落在单位正方形内的点落在该正方形内接圆的概率。以下代码块演示了如何通过蒙特卡洛方法来估计这个概率。

import randomdef throw_points(n):inside_circle = 0for _ in range(n):x, y = random.random(), random.random() # 在[0,1]区间随机生成点if x**2 + y**2 <= 1: # 判断点是否落在单位圆内inside_circle += 1return inside_circle / n# 使用10000个点估计概率

pi_estimate = 4 * throw_points(10000)

print(pi_estimate)

此代码模拟向单位正方形中随机投掷点,并判断该点是否落在内接圆内。由于圆的面积是正方形面积的1/4,根据面积比,我们可以通过落在圆内的点的比例来估计π的值。这个比例近似等于我们感兴趣的几何概率。

逻辑分析

代码 throw_points(n) 函数通过模拟在单位正方形内随机投点,计算了这些点中落在内接圆内的点的百分比,即概率的近似值。结果 pi_estimate 提供了一个根据几何概率估计π的方法,这也展现了蒙特卡洛方法在概率计算中的应用。

2.3 概率计算方法

2.3.1 加法原理与乘法原理

加法原理用来计算两个互斥事件中至少发生一个事件的概率。如果事件A和事件B互斥,即它们不能同时发生,则事件A或B发生的概率为 (P(A \cup B) = P(A) + P(B))。

乘法原理用来计算两个事件同时发生的概率。如果事件A和事件B相互独立,即一个事件的发生不影响另一个事件,则事件A和B同时发生的概率为 (P(A \cap B) = P(A) \cdot P(B))。

2.3.2 全概率公式与逆事件概率

全概率公式是当事件A可以被划分为几个互斥的事件 (B_1, B_2, …, B_n) 时,事件A发生的总概率等于这些互斥事件发生的概率之和:[ P(A) = P(A \cap B_1) + P(A \cap B_2) + … + P(A \cap B_n) ]

逆事件概率涉及到计算在某事件未发生的条件下,其他事件发生的概率。逆事件B|~A即为事件B在事件A未发生的条件下发生的概率,可以表示为:[ P(B|~A) = \frac{P(B \cap ~A)}{P(~A)} ]

表格和逻辑分析

| 概率类型 | 符号表示 | 计算公式 | 条件 | 适用场景 |

|---|---|---|---|---|

| 加法原理 | P(A ∪ B) | P(A) + P(B) | A和B互斥 | A和B无法同时发生 |

| 乘法原理 | P(A ∩ B) | P(A) * P(B) | A和B独立 | A和B可同时发生且相互不影响 |

| 全概率公式 | P(A) | ΣP(A ∩ Bi) | Bi为互斥且完备的事件序列 | A可被多个互斥事件分解 |

| 逆事件概率 | P(B | ~A) | P(B ∩ ~A) / P(~A) | 求B在A未发生的情况下发生的概率 |

通过上表的总结,我们可以看到不同概率计算方法的特点和适用场景。在实际问题中,需要根据具体的事件关系来选择合适的概率计算公式。

mermaid流程图展示

以下是一个mermaid流程图,用来描述全概率公式的应用流程。

graph TD;A[开始] --> B{事件A是否能被划分为互斥事件B1,B2,...,Bn};B -- 是 --> C[计算P(A ∩ Bi) for i = 1 to n];B -- 否 --> D[不可使用全概率公式];C --> E[求和ΣP(A ∩ Bi)];E --> F[计算得到P(A)];F --> G[结束];

在这个流程图中,我们首先判断事件A是否可以被分解为互斥的事件序列。如果是,我们对每一个事件Bi计算 (P(A \cap Bi)),然后将所有的概率加和得到 (P(A))。如果事件A不能被分解为互斥事件序列,那么我们无法使用全概率公式。

在概率计算中,选择合适的计算方法是关键。上述介绍的方法为分析和解决概率问题提供了基础工具,为深入的概率分析奠定了基础。

3. 条件概率和Bayes定理应用

3.1 条件概率的基本理论

3.1.1 条件概率的定义和性质

在处理不确定性问题时,条件概率是一个核心概念,它描述了在已知某些条件下事件发生的可能性。直观上,条件概率可以被理解为对事件发生的先验知识的利用,使得我们能够更精确地估计事件发生的概率。

条件概率的数学定义是,在事件A发生的条件下,事件B发生的概率,记为P(B|A)。其计算公式为:

[ P(B|A) = \frac{P(A \cap B)}{P(A)} ]

其中,(P(A \cap B))表示事件A和事件B同时发生的概率,而(P(A))是事件A发生的概率。在分母不为零的情况下,我们可以使用上述公式计算条件概率。

重要的是要理解条件概率的性质,例如:

- 当A和B是不相交事件时,(P(B|A) = 0)。

- 如果A是必然事件,那么(P(B|A) = P(B))。

3.1.2 独立事件的概率推导

条件概率的特殊情况是独立事件。当两个事件的概率不受对方发生的条件影响时,它们被称为独立事件。这意味着一个事件的发生不会影响另一个事件的概率。

对于任意两个独立事件A和B,条件概率(P(B|A))等于(P(B)),反之亦然。用公式表示为:

[ P(A \cap B) = P(A)P(B) ]

独立事件的概念在设计复杂系统和分析多阶段过程时非常有用,因为如果事件是独立的,那么它们同时发生的概率是它们各自发生概率的乘积。

3.2 Bayes定理的深入分析

3.2.1 Bayes定理的数学表达和意义

Bayes定理是概率论中的一项重要定理,它提供了一种计算逆条件概率的方法。在许多实际问题中,我们可能需要在已知结果的情况下,推断导致该结果的可能原因的概率。

Bayes定理的数学形式是:

[ P(A|B) = \frac{P(B|A)P(A)}{P(B)} ]

其中,(P(A|B))是在事件B已经发生的条件下,事件A发生的概率。Bayes定理表达了先验概率(P(A))和似然函数(P(B|A))的关系。

Bayes定理在统计学中尤其重要,它允许我们在已观察到数据的情况下更新对一个假设的概率估计。

3.2.2 Bayes定理在决策中的应用实例

Bayes定理在决策理论中的应用非常广泛,比如在医疗诊断、机器学习、风险管理等领域。一个经典的例子是疾病检测。

假设一个疾病在人群中发生的先验概率为(P(D)),而检测该疾病的测试准确率为(P(+)|D))。如果测试结果呈阳性,即事件“测试呈阳性”为(P(+)’),Bayes定理可以用来计算被测试者真正患有该疾病的概率(P(D|+)):

[ P(D|+) = \frac{P(+|D)P(D)}{P(+)} ]

其中,(P(+) = P(+|D)P(D) + P(+|\neg D)P(\neg D)),是测试结果呈阳性的总概率,包含患病和未患病两种情况下测试呈阳性的概率。

这一计算方法对于理解测试结果的真正含义至关重要,因为即使测试准确率非常高,如果疾病在人群中的先验概率很低,那么即使测试呈阳性,患者真正患病的概率可能并不高。

3.3 概率模型的构建与分析

3.3.1 常见概率模型的构建技巧

构建概率模型通常包括几个步骤:定义事件空间,确定概率分布,以及建立随机变量之间的关系。常见的概率模型构建技巧包括:

- 确定模型的用途和目标,这决定了模型的复杂度和细节程度。

- 明确事件空间,包括基本事件和可能的复合事件。

- 根据已有的数据和理论确定概率分布(例如二项分布、正态分布等)。

- 通过参数估计或假设检验来获得分布的具体参数。

3.3.2 实际问题中的概率模型分析

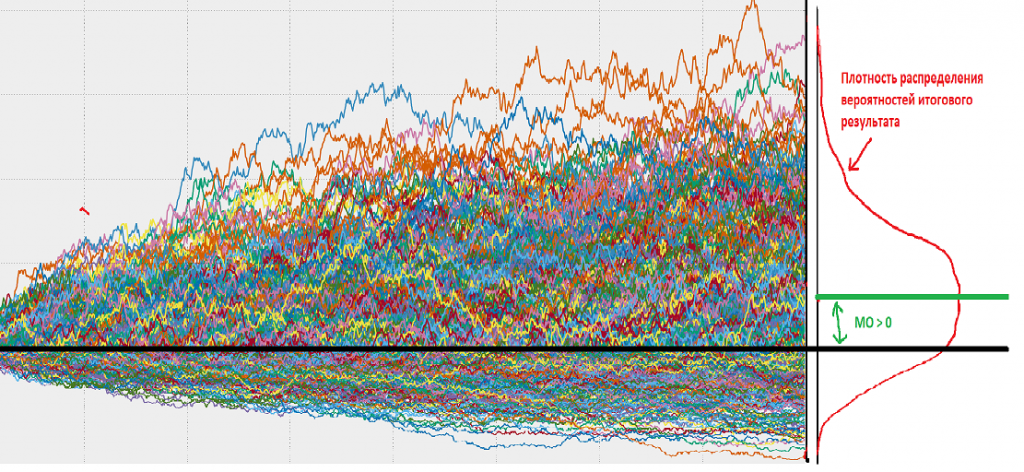

在实际问题中,构建概率模型需要综合考虑多个因素。例如,在预测市场动态时,可能需要建立一个包含多个随机变量的模型,这些变量可能代表不同的市场指标、经济因素等。

在进行概率模型分析时,我们通常会使用以下步骤:

- 数据收集 :搜集与问题相关的数据,作为模型建立的基础。

- 模型假设 :根据收集的数据和领域知识提出合理的假设。

- 模型参数估计 :使用统计方法,如最大似然估计或贝叶斯方法,来估计模型参数。

- 模型验证 :使用新的数据集来测试模型的有效性,包括检验其预测准确性。

- 结果解释和应用 :将模型的结果解释为实际可操作的决策或进一步的分析。

在构建和分析概率模型时,我们可能会遇到多种挑战,包括选择合适的分布、处理缺失数据、以及验证模型的有效性等。

在下一节中,我们将深入探讨独立事件的识别和计算,以及它们在复杂情境中的应用。

4. 独立事件的识别和计算

4.1 独立事件的判定方法

独立事件的定义与性质

独立事件在概率论中是指两个事件发生的结果互不影响。具体地,如果事件A的发生不会改变事件B发生的概率,反之亦然,那么我们称事件A和事件B是独立的。在数学表达上,事件A和事件B独立的定义可以表示为:

[ P(A \cap B) = P(A) \cdot P(B) ]

这里 ( P(A \cap B) ) 表示事件A和事件B同时发生的概率,( P(A) ) 和 ( P(B) ) 分别表示事件A和事件B发生的概率。从这个定义出发,我们可以看出独立事件之间的概率乘积关系是识别它们的关键。

多事件独立性的判断技巧

当我们需要判断多个事件的独立性时,问题会变得更加复杂。对于多个事件 ( A_1, A_2, …, A_n ) 来说,所有这些事件相互独立意味着任意两个事件以及任意多个事件组合的结果都不会互相影响其发生的概率。理论上,我们需要验证以下关系:

[ P(A_1 \cap A_2 \cap … \cap A_n) = P(A_1) \cdot P(A_2) \cdot … \cdot P(A_n) ]

对于三个以上的事件,我们可以通过两两配对验证它们是否满足独立性的定义来简化问题。例如,如果我们已经知道事件A和B独立,事件B和C独立,那么为了证明A、B、C三者独立,我们还需要验证:

[ P(A \cap C) = P(A) \cdot P(C) ]

在某些特殊情况下,比如事件是独立重复试验的结果,我们可以简单地通过事件发生的概率是否相乘来判断它们是否独立。

4.2 独立事件的概率计算

独立重复试验的概率计算

独立重复试验是指一系列的试验,每次试验的结果都不会影响到其他试验,且每次试验都有相同的结果发生的概率。例如,抛硬币的试验,每次抛出正面的概率都是 ( \frac{1}{2} ),且与前一次试验的结果无关。在独立重复试验中,计算特定结果发生的概率可以通过以下公式:

[ P(A) = 1 - (1 - p)^n ]

这里 ( p ) 是单次试验中事件A发生的概率,( n ) 是重复试验的次数。例如,连续抛一枚公正的硬币三次都出现正面的概率计算如下:

假设单次抛硬币出现正面的概率为 p = 0.5,要计算连续三次都出现正面的概率:

\[ P(三次都正面) = 1 - (1 - 0.5)^3 = 1 - (0.5)^3 = 1 - 0.125 = 0.875 \]

独立事件序列的概率分析

当处理多个独立事件的序列时,计算整个序列发生的所有可能结果的概率可以使用乘法原理。例如,若事件A和事件B是独立的,计算它们同时发生的概率就是将两者发生的概率相乘。假设事件A的概率为0.6,事件B的概率为0.4,那么它们同时发生的概率为:

\[ P(A \cap B) = P(A) \cdot P(B) = 0.6 \cdot 0.4 = 0.24 \]

对于多个独立事件的序列,我们可以用类似的方法计算它们所有可能组合的概率。但要注意的是,当事件数量增多时,需要考虑所有可能的组合,计算会变得复杂。

4.3 独立事件在复杂情境中的应用

组合事件的概率分析

在现实生活中,我们经常会遇到由多个独立事件组成的组合事件。例如,在制造过程中,一个部件损坏的概率是p,我们需要n个这样的部件,每个部件都是独立损坏的。那么,所有部件都正常工作的概率为:

[ P(所有部件正常) = (1-p)^n ]

这个概率可以帮助我们评估生产过程中部件损坏对整体生产的影响。

实际问题中独立事件的计算案例

假设一个网络服务有三个独立的子系统A、B和C,子系统A的稳定运行概率是90%,即 ( P(A) = 0.9 ),同理,B和C的概率分别是 ( P(B) = 0.85 ) 和 ( P(C) = 0.8 )。为了保证整个网络服务的稳定运行,我们需要所有三个子系统都稳定运行。那么整个服务的稳定概率可以通过乘法原理计算:

\[ P(服务稳定) = P(A \cap B \cap C) = P(A) \cdot P(B) \cdot P(C) = 0.9 \cdot 0.85 \cdot 0.8 = 0.612 \]

因此,服务的稳定概率是61.2%。这个结果对于系统设计者来说非常重要,因为如果稳定概率不满足需求,就需要考虑增加冗余部件、优化设计或者升级子系统以提高整体的服务稳定性。

在实际问题中,独立事件的概率计算和分析能帮助我们更好地理解复杂系统的行为,并作出合理的决策。通过对概率模型的构建和分析,可以预见和缓解潜在的问题,从而提高系统的可靠性和效率。

5. 离散型和连续型概率分布特征

5.1 离散型概率分布的典型模型

在概率论和统计学中,离散型概率分布描述了离散随机变量取各个不同值的概率。理解这些分布对于进行预测和分析是至关重要的。我们将重点介绍两种典型的离散型分布:二项分布和多项分布,以及泊松分布。

5.1.1 二项分布与多项分布

二项分布

二项分布是一种最基础且广泛使用的离散概率分布,它的应用范围涵盖了很多领域,比如质量控制、商业决策等。假设一个随机事件(如投硬币)只有两种可能结果(正面或反面),那么在固定次数(n次)的独立重复试验中,成功次数的分布就是二项分布。

- 数学表达式 :

二项分布的概率质量函数(probability mass function, PMF)为:

P(X = k) = C(n, k) * p^k * (1 - p)^(n - k)

其中X是成功次数的随机变量,k是具体的成功次数,p是每次试验成功的概率,C(n, k)表示组合数,即从 n 次试验中选取 k 次成功的组合数。 - 示例代码 :

```python

import math

# 计算二项分布概率质量函数

def binomial_pmf(k, n, p):

return math.comb(n, k) * (p ** k) * ((1 - p) ** (n - k))

# 计算当 n=5, p=0.5, k=3 时的概率

probability = binomial_pmf(3, 5, 0.5)

print(f”The probability of getting exactly 3 successes is: {probability}”)

```

多项分布

多项分布是二项分布的推广,它适用于多个结果(多于两个)的独立重复试验。比如说,在投掷一个六面骰子5次的情况下,我们可能对得到特定面次数的分布感兴趣。

- 数学表达式 :

多项分布的概率质量函数为:

P(X_1 = k_1, ..., X_r = k_r) = (n! / (k_1! * ... * k_r!)) * p_1^k_1 * ... * p_r^k_r

其中X_i是第 i 个结果的成功次数,k_i是具体的成功次数,p_i是第 i 个结果的概率,n 是试验次数,r 是结果种类数。 - 示例代码 :

```python

from math import comb

# 计算多项分布概率质量函数

def multinomial_pmf(k_list, n, p_list):

pmf_value = comb(n, k_list)

for p, k in zip(p_list, k_list):

pmf_value = (p ** k)

return pmf_value

# 计算当 n=5, p=[0.2, 0.5, 0.3], k=[1, 3, 1] 时的概率

probability = multinomial_pmf([1, 3, 1], 5, [0.2, 0.5, 0.3])

print(f”The probability of getting 1, 3, 1 outcomes for each of the three categories is: {probability}”)

```

5.1.2 泊松分布的特点和应用

泊松分布是一种描述在固定时间或空间内发生某个事件次数的概率分布。

- 数学表达式 :

泊松分布的概率质量函数为:

P(X = k) = (λ^k * e^-λ) / k!

其中X是事件发生次数的随机变量,k是特定次数,λ是单位时间(或单位面积)内事件的平均发生次数,e是自然对数的底数。 - 示例代码 :

```python

import math

# 计算泊松分布概率质量函数

def poisson_pmf(k, lam):

return (lam ** k * math.exp(-lam)) / math.factorial(k)

# 计算当 λ=3, k=5 时的概率

probability = poisson_pmf(5, 3)

print(f”The probability of having 5 events in a unit where the average number of events is 3 is: {probability}”)

```

以上是离散型概率分布中一些非常重要的模型。理解这些分布有助于处理现实世界中的各种统计问题。

6. 期望值和方差的计算与分析

6.1 期望值的定义及性质

6.1.1 离散型随机变量的期望值

期望值是衡量随机变量平均取值的一个度量,对于离散型随机变量,它是各个可能取值的加权平均数,权重为各值出现的概率。

计算公式:

对于离散型随机变量 (X),若其概率质量函数为 (P(X = x_i) = p_i),则期望值 (E(X)) 定义为:

[E(X) = \sum_{i=1}^{n} x_i p_i]

其中,(x_i) 表示随机变量 (X) 可以取到的第 (i) 个值。

实例:

假设有一个公平的六面骰子,随机变量 (X) 表示掷骰子的结果。(X) 取值为 1 到 6,每个值出现的概率是 (1/6)。那么 (E(X)) 的计算如下:

E(X) = 1*(1/6) + 2*(1/6) + 3*(1/6) + 4*(1/6) + 5*(1/6) + 6*(1/6) = 3.5

6.1.2 连续型随机变量的期望值

对于连续型随机变量,期望值的计算涉及积分运算。若随机变量 (X) 的概率密度函数为 (f(x)),则期望值 (E(X)) 的定义为:

[E(X) = \int_{-\infty}^{\infty} x f(x) dx]

实例:

考虑一个随机变量 (Y),它服从区间 ([0,1]) 上的均匀分布,那么 (Y) 的概率密度函数为 (f(y) = 1)。(Y) 的期望值计算如下:

E(Y) = \int_{0}^{1} y \cdot 1 dy = [y^2/2] from 0 to 1 = 0.5

6.2 方差与标准差的计算方法

6.2.1 方差的概念及其计算公式

方差是衡量随机变量取值分散程度的一个度量,它是随机变量与其期望值差的平方的期望值。

对于离散型随机变量 (X),方差 (\sigma^2) 的计算公式为:

[\sigma^2 = E[(X - E(X))^2] = \sum_{i=1}^{n} (x_i - E(X))^2 p_i]

对于连续型随机变量 (Y),方差的计算公式为:

[\sigma^2 = E[(Y - E(Y))^2] = \int_{-\infty}^{\infty} (y - E(Y))^2 f(y) dy]

6.2.2 标准差的意义与应用

标准差是方差的平方根,它和原变量有相同的单位,因此在比较数据的离散程度时更加直观。

计算公式为:

[\sigma = \sqrt{\sigma^2}]

实例:

对于前面提到的均匀分布的随机变量 (Y),其方差和标准差计算如下:

Variance: σ^2 = E[(Y - 0.5)^2] = \int_{0}^{1} (y - 0.5)^2 \cdot 1 dy = [1/12]

Standard Deviation: σ = √[1/12] ≈ 0.2887

6.3 期望值和方差在数据分析中的应用

6.3.1 描述性统计分析中的应用

在描述性统计分析中,期望值和方差被用来刻画数据集的中心趋势和离散程度。期望值表示数据的平均值,而方差和标准差帮助我们理解数据是如何围绕平均值分布的。

6.3.2 概率模型优化中的作用

在优化概率模型时,期望值可以用来评估不同决策方案的平均效果,而方差帮助我们识别哪些方案在不同情况下表现更加稳定。

实例:

在股票投资中,投资者会计算不同投资组合的预期收益(期望值),并评估这些组合收益的波动性(方差),以决定风险和收益的平衡点。

通过上述的分析和实例,期望值和方差不仅在理论研究中占有重要地位,它们在实际的数据分析和决策过程中也发挥着重要作用。在下一章节,我们将深入探讨离散型和连续型概率分布的特征及其在实际应用中的分析。

本文还有配套的精品资源,点击获取

简介:安徽大学的概率论课程围绕随机现象的规律性,覆盖了多个核心概念,如随机事件的概率、条件概率、独立事件、概率分布、期望值、方差、大数定律和中心极限定理。本资源包含期末试卷及答案,旨在测试学生对概率论的理解和应用能力,并通过答案解析提供学习反馈,帮助学生深化对这些概念的理解。学生通过实际问题的应用,可以更有效地掌握这些理论知识,为考试和实际应用做准备。

本文还有配套的精品资源,点击获取

)