一、MS COCO数据集

COCO 是一个大规模的对象检测、分割和图像描述数据集。COCO有几个 特点:

Object segmentation:目标级的分割(实例分割)

Recognition in context:上下文中的识别(图像情景识别)

Superpixel stuff segmentation:超像素分割

330K images (>200K labeled):330K 图像(>200K 已经做好标记)

1.5 million object instances:150 万个对象实例

80 object categories:80 个目标类别

91 stuff categories: 91 个场景物体类别 (stuff中包含没有明确边界 的材料和对象,比如天空)

5 captions per image:每张图片 5 个情景描述(标题)

250,000 people with keypoints:250,000 人体的关键点标注

注意:80 object categories 是 91 stuff categories 的子集

80 object categories 是传统意义上的“物体”,通常是可以单独识别和分 割的具体对象。它们通常具有明确的边界,可以用边界框(bounding box)和分割掩码(segmentation mask)进行标注。例如:人 (person)、自行车(bicycle) 这些物体类别在图像中通常是离散的,可 以被独立标注和识别。

91 Stuff Categories 是“场景物体”或“背景物体”,通常是一些没有明确边 界的区域,通常作为背景存在。它们不容易被单独识别,因为它们的边界 通常是连续的。这些类别在图像中通常覆盖大面积,且没有清晰的边界。 例如:草(grass)、天空(sky) 这些场景物体类别的标注通常用于场景 解析任务,例如场景分割(scene segmentation),而不是对象检测。

官方:

COCO - Common Objects in Context

论文

[1405.0312] Microsoft COCO: Common Objects in Context

二、与Pascal VOC对比

橙色是Pascal VOC包含的类别,蓝色是COCO包含的类别。纵坐标是标注 的数量。 很

多模型的预训练模型(模型文件)都是COCO数据集上训练出来的,然后我们自己去做迁移学习进行训练。

注意:COCO数据集训练非常耗时,一般单块GPU(如 NVIDIA V100): 通常需要数天到数周的训练时间。

三、目标检测需要的文件

2017 Train images [118K/18GB]:训练过程中使用到的所有图像文件

2017 Val images [5K/1GB]:验证过程中使用到的所有图像文件

2017 Train/Val annotations[241MB]:对应训练集和验证集的标注json文 件

train2017:所有训练图像文件夹(118287张)

val2017:所有验证图像文件夹(5000张)

annotations:对应标注文件夹

|—instances train2017.json:对应目标检测、分割任务的训练集标注 文

|—instances_val2017.json:对应目标检测、分割任务的验证集标注文 件

|—captions train2017.json:对应图像描述的训练集标注文件

|—captions_va12017.json:对应图像描述的验证集标注文件

|—person keypoints train2017.json:对应人体关键点检测的训练集 标注文件

|—person_keypoints_val2017.json:对应人体关键点检测的验证集标 注文件夹

四、读取COCO数据集的JSON

import jsonlabels =json.load(open("../annotations_trainval2017/annotations/instances_train2017.json","r"))

print(labels)直接打印的话,打印不全,同时格式很乱,所以使用debug。

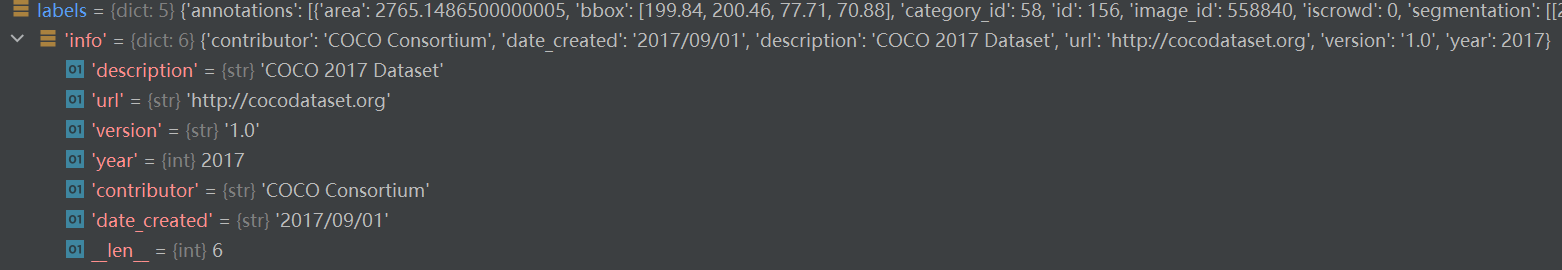

其中:labels中有5个字典:分别是info、licenses、Images、 annotations、categories。

4.1、info

这个字典包含了关于数据集的基本信息。

description : 数据集的描述,这里是 "COCO 2017 Dataset"。

url : 数据集的URL链接,即官网地址,这里是 "https://cocodataset.org/"。

version : 数据集的版本号,这里是 "1.0"。

year : 数据集创建的年份,这里是 2017。

contributor : 数据集的贡献者,这里是 "COCO Consortium"。

date_created : 数据集创建的日期,这里是 "2017/09/01"。

4.2、licenses

这个字典列表包含了数据集所用到的不同许可证的信息。

每个字典表示一种许可证,包含以下键:

id : 许可证的唯一标识符。

name : 许可证的名称。

url : 许可证的详细信息链接。

例如: id: 1 , name: Attribution-NonCommercial-ShareAlike License 代表此许可证。

4.3、images

这个字典列表包含了数据集中所有图像的信息。

每个字典表示一张图像,包含以下键:

id : 图像的唯一标识符。

coco_url : 图像的COCO数据集URL。

其他可能包含的信息如文件名、高度、宽度等。

4.4、annotations

这个字典列表包含了数据集中所有标注的信息。

每个字典表示一个标注,包含以下键:

id : 标注的唯一标识符。

image_id : 该标注所属图像的唯一标识符。

category_id : 该标注所属类别的唯一标识符(91 stuff categories的 索引)。

area : 标注区域的面积。

bbox : 标注的边界框(bounding box),通常用一个四元组表示(x, y, width, height)。

segmentation : 分割标注的信息,通常是一个多边形的点集。

其他标注信息如分数(score)、关键点(keypoints)等。

4.5、categories

这个字典列表包含了数据集中所有类别的信息(91 stuff categories,使用 80 object categories时需要映射)。

每个字典表示一个类别,包含以下键:

id : 类别的唯一标识符。

name : 类别的名称(如 "person", "bicycle" 等)。

supercategory : 类别的上一级分类(超类)。

例如:

id: 1 , name: person , supercategory: person 代表 "person" 类 别。

五、使用pycocotools读取COCO数据集

5.1、安装pycocotools

python -m pip install pycocotools-windows==2.0.0.2 -i https://pypi.tuna.tsinghua.edu.cn/simple/

5.2、读取COCO数据集并显示目标检测的第一张

import os

import json

from PIL import Image, ImageDraw

from pycocotools.coco import COCO# COCO数据集的路径

annotation_path = "./instances_val2017.json"

img_path = "./val2017/val2017"# 加载COCO数据集,打断点

coco = COCO(annotation_path)

# 查看5000张图像# 获取所有图像的ID

img_ids = coco.getImgIds()

# 看到所有5000张图像的索引# 处理前5张图像

for img_id in img_ids[:1]:# 获取图像信息,可以看到397133这章图片的信息img_info = coco.loadImgs(img_id)[0]img_file = os.path.join(img_path, img_info['file_name'])# 打开图像img = Image.open(img_file)draw = ImageDraw.Draw(img)# 获取该图像的所有标注# getAnnIds 函数可以接受多个参数,例如 imgIds、catIds 和 areaRng,以便根据图像ID、类别ID或面积范围来筛选标注。# 这个函数会返回一个标注ID列表,这些标注ID对应于指定图像ID的所有标注。ann_ids = coco.getAnnIds(imgIds=img_id)anns = coco.loadAnns(ann_ids)for ann in anns:# 获取类别名称category_id = ann['category_id']category_name = coco.loadCats(category_id)[0]['name']# 获取边界框bbox = ann['bbox']x, y, w, h = bbox# 绘制边界框draw.rectangle([x, y, x + w, y + h], outline="red", width=2)# 绘制类别名称draw.text((x, y - 10), category_name, fill="red")# 显示图像img.show()

)

:ROS入门指南 —— 核心解析与版本演进)

进程(2))