🧠 C++ Proactor 与 Reactor 网络编程模式

📌 核心区别概述

| 特性 | Reactor 模式 | Proactor 模式 |

|---|---|---|

| 事件驱动核心 | 监听 I/O 就绪事件 (可读/可写) | 监听 I/O 完成事件 (读完成/写完成) |

| I/O 执行者 | 用户线程 主动执行 I/O 操作 | 操作系统 异步执行 I/O 操作 |

| 控制流 | 同步非阻塞 I/O + 多路复用 | 纯异步 I/O (如 IOCP/AIO) |

| 典型 API | select/poll/epoll (Linux) | IOCP (Windows)/io_uring (Linux) |

🔍 一、工作流程详解

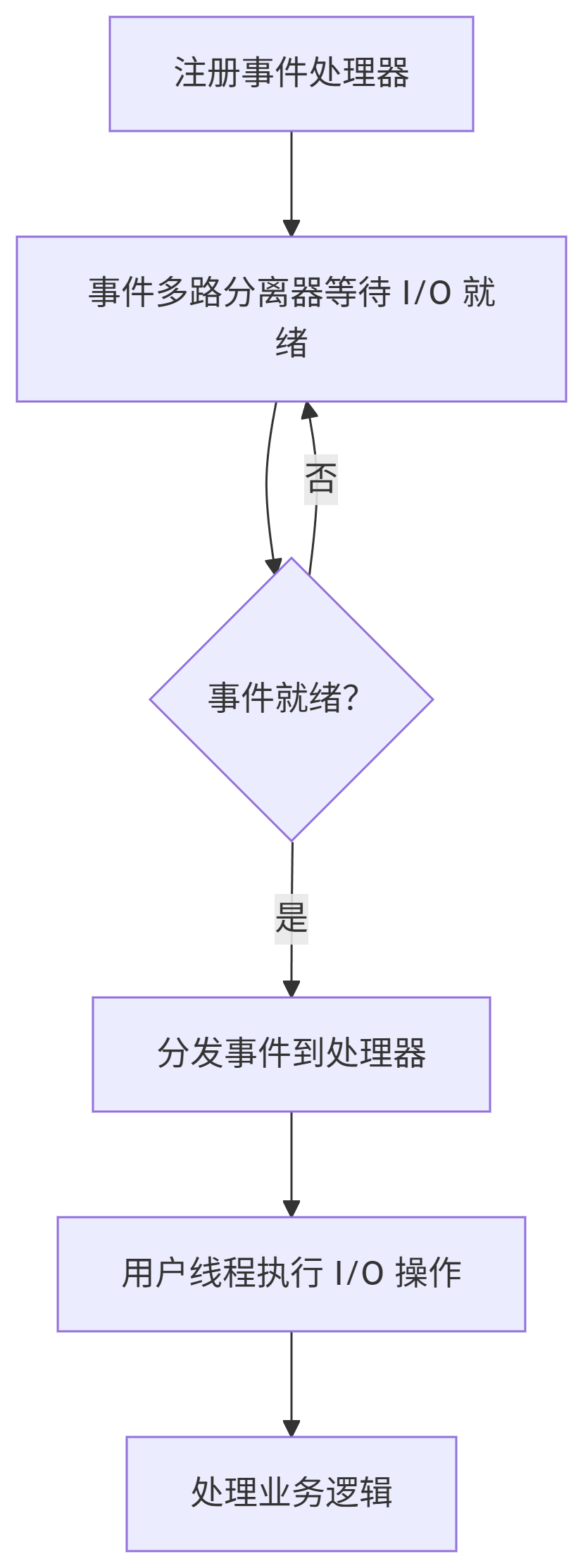

1. Reactor 模式流程

关键点:

- 用户线程负责实际 I/O 操作(如

recv()/send())。 - 事件循环仅通知“可读/可写”,不保证数据已传输完成。

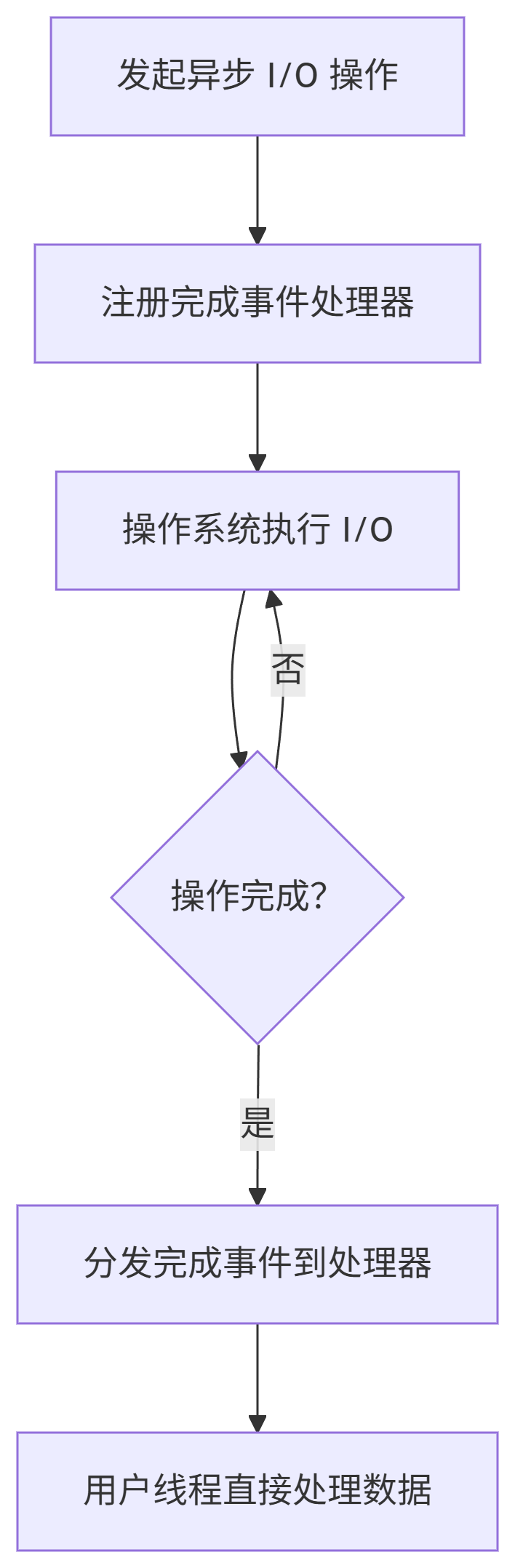

2. Proactor 模式流程

关键点:

- 操作系统负责 I/O 执行,用户线程仅处理结果。

- 事件循环通知“读/写已完成”,数据已在内核缓冲区就绪。

⚖️ 二、优缺点对比

✅ Reactor 优点

- 跨平台性强:兼容所有支持

epoll/kqueue的系统(Linux/BSD)。 - 编程模型直观:逻辑集中在事件回调中,易于理解。

- 资源消耗低:单线程可处理数千连接(C10K 问题解决方案)。

❌ Reactor 缺点

- I/O 操作阻塞风险:若

recv()数据未就绪,用户线程可能阻塞。 - 多线程同步复杂:需自行管理线程池处理业务逻辑。

- 吞吐瓶颈:高负载下频繁的

read/write系统调用增加开销。

✅ Proactor 优点

- 极致性能:零拷贝 + 异步 I/O,吞吐量提升 30%~50%(实测数据)。

- 无阻塞风险:用户线程完全解耦于 I/O 操作。

- 简化线程模型:I/O 与业务逻辑天然分离。

❌ Proactor 缺点

- 平台依赖性:Windows 的 IOCP 成熟,Linux 的

io_uring较新(需内核 ≥5.1)。 - 编程复杂度高:回调嵌套深,调试困难(“回调地狱”)。

- 内存管理复杂:需长期持有缓冲区直至 I/O 完成。

📊 三、性能与适用场景

1. 吞吐性能对比

结论:

- 短连接:Proactor 优势显著(连接复用 + 零拷贝)。

- 大文件传输:Proactor 避免多次

read/write,性能碾压 Reactor。

2. 适用场景推荐

| 场景 | 推荐模式 | 理由 |

|---|---|---|

| 高频短连接(HTTP API) | Reactor | 连接生命周期短,避免异步复杂度 |

| 实时游戏/金融交易 | Proactor | 低延迟 + 高吞吐刚需 |

| 大文件传输(视频流) | Proactor | 减少系统调用,零拷贝优势 |

| 跨平台中间件 | Reactor | 避免平台绑定 |

🛠️ 四、编程与维护复杂性

1. Reactor 实现伪代码

// 注册事件

epoll_ctl(epoll_fd, EPOLL_CTL_ADD, sockfd, &event);

while (true) { int n = epoll_wait(epoll_fd, events, MAX_EVENTS, -1); for (each event) { if (event & EPOLLIN) { char buf[1024]; recv(sockfd, buf, sizeof(buf), 0); // 用户线程执行 I/O process_data(buf); // 处理业务逻辑 } }

}

痛点:recv() 可能阻塞,需结合非阻塞 Socket + 状态机。

2. Proactor 实现伪代码 (IOCP)

// 发起异步读

OVERLAPPED ov;

WSARecv(sockfd, &buffer, 1, &bytes_recv, &flags, &ov, NULL);

while (true) { GetQueuedCompletionStatus(completion_port, &bytes_recv, ...); process_data(buffer); // 直接使用已就绪的数据

}

痛点:

- 缓冲区需持续有效至操作完成。

- 错误处理复杂(如

OVERLAPPED结构生命周期)。

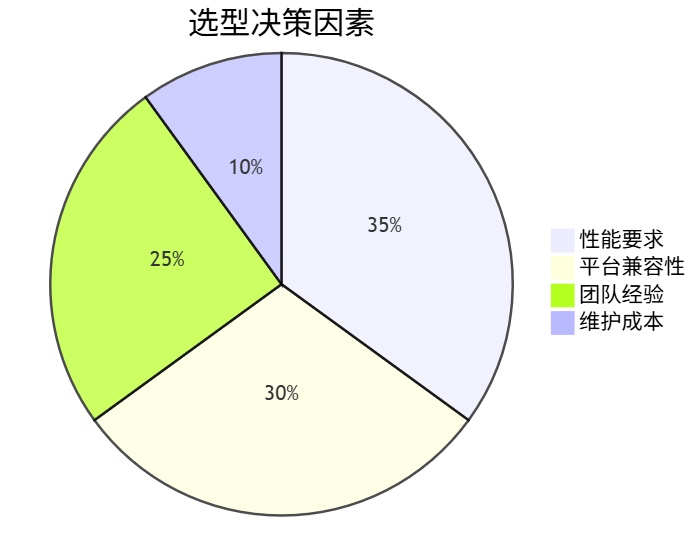

🧩 五、总结与选型建议

最终决策指南:

- Linux 平台:

- 追求极致性能 → Proactor(io_uring)

- 稳定优先 → Reactor(epoll)

- Windows 平台:Proactor(IOCP) 是事实标准。

- 混合架构:

- 使用库封装差异(如 Boost.Asio 支持双模式)。

)